コンピュータビジョンプロジェクトにおける主要なステップの理解

はじめに

コンピュータビジョンは、コンピュータが人間のように世界を見て理解するのを助ける人工知能 (AI) のサブフィールドです。画像や動画を処理および分析して情報を抽出し、パターンを認識し、そのデータに基づいて意思決定を行います。

見る: 方法 コンピュータビジョン プロジェクト | ステップごとのガイド

物体検出、画像分類、インスタンスセグメンテーションなどのコンピュータビジョン技術は、自動運転から医療画像処理まで、さまざまな業界に適用して、貴重な洞察を得ることができます。

独自のコンピュータービジョンプロジェクトに取り組むことは、コンピュータービジョンを理解し、さらに学ぶための素晴らしい方法です。しかし、コンピュータービジョンプロジェクトは多くのステップで構成されており、最初は混乱するかもしれません。このガイドの終わりまでに、コンピュータービジョンプロジェクトに含まれるステップに精通するでしょう。プロジェクトの最初から最後まで、各部分がなぜ重要であるかを説明しながら、すべてを順を追って説明します。

コンピュータビジョンプロジェクトの概要

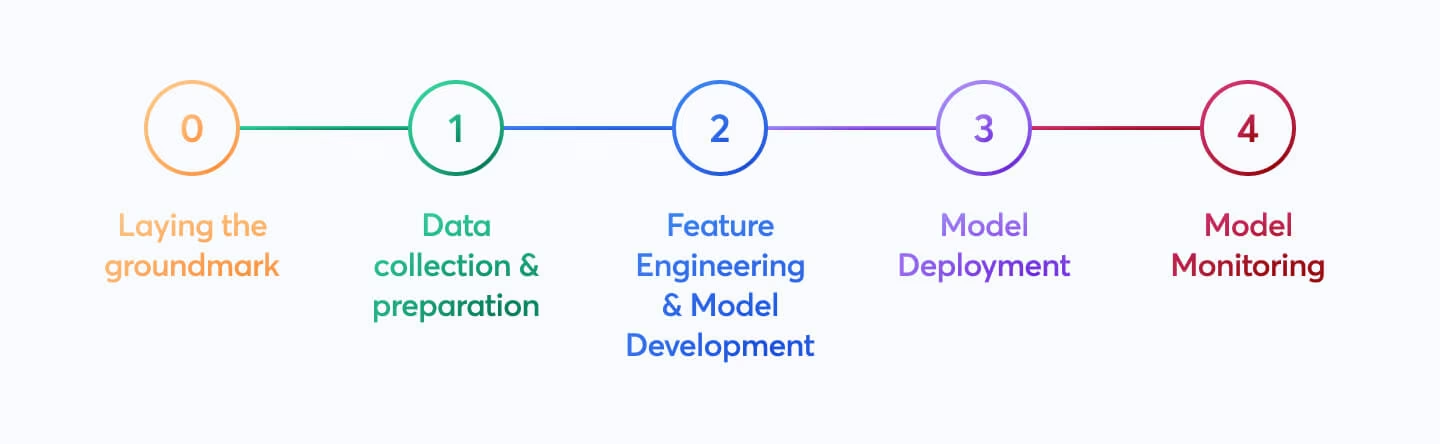

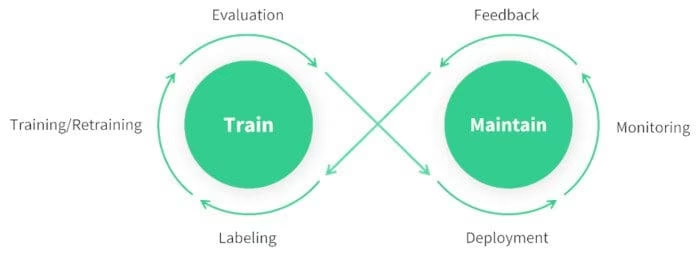

コンピュータビジョンプロジェクトの各ステップの詳細を説明する前に、プロセス全体を見てみましょう。今日、コンピュータビジョンプロジェクトを開始するとしたら、次の手順を実行します。

- まず、プロジェクトの要件を理解することが最優先事項です。

- 次に、モデルのトレーニングに役立つ画像を収集し、正確にラベル付けします。

- 次に、データをクリーンアップし、拡張技術を適用して、モデルのトレーニングに備えます。

- モデルのトレーニング後、モデルがさまざまな条件下で一貫して動作することを確認するために、モデルを徹底的にテストおよび評価する必要があります。

- 最後に、モデルを実世界にデプロイし、新しい洞察とフィードバックに基づいて更新します。

期待されることがわかったので、早速手順に進み、プロジェクトを前進させましょう。

ステップ1:プロジェクトの目標を定義する

コンピュータービジョンプロジェクトの最初のステップは、解決しようとしている問題を明確に定義することです。最終目標を知ることで、ソリューションの構築を開始できます。これは、プロジェクトの目的が、焦点を当てる必要のあるコンピュータービジョンタスクに直接影響するため、コンピュータービジョンの場合に特に当てはまります。

プロジェクトの目的と、これらの目的を達成するために使用できるコンピュータビジョンタスクの例を以下に示します。

Objective: 高速道路上のさまざまな車種の流れを監視および管理し、交通管理と安全性を向上させるシステムを開発すること。

- コンピュータビジョンタスク: 物体検出は、複数の車両を効率的に特定し、識別するため、交通監視に最適です。画像セグメンテーションよりも計算負荷が少なく、このタスクに不要な詳細を提供しないため、より高速なリアルタイム分析が保証されます。

Objective: 医療用画像スキャンで腫瘍の正確なピクセルレベルのアウトラインを提供することにより、放射線科医を支援するツールを開発すること。

- コンピュータビジョンタスク: 画像セグメンテーションは、腫瘍の正確で詳細な境界線を提供し、サイズ、形状、治療計画の評価に不可欠であるため、医療画像処理に適しています。

Objective: 組織の効率とドキュメント検索を向上させるために、さまざまなドキュメント(請求書、領収書、法的書類など)を分類するデジタルシステムを作成すること。

- コンピュータービジョンタスク:画像分類は、一度に1つのドキュメントを処理し、画像内のドキュメントの位置を考慮する必要がないため、ここでは理想的です。このアプローチにより、ソートプロセスが簡素化され、高速化されます。

ステップ1.5:適切なモデルとトレーニングアプローチの選択

プロジェクトの目的と適切なコンピュータビジョンタスクを理解した後、プロジェクトの目標を定義する上で不可欠な部分は、適切なモデルの選択とトレーニングアプローチです。

目的に応じて、最初にモデルを選択するか、ステップ2で収集できるデータを確認した後に選択するかを決定できます。たとえば、プロジェクトが特定の種類のデータの可用性に大きく依存しているとします。その場合、モデルを選択する前に、まずデータを収集して分析する方が現実的かもしれません。一方、モデルの要件を明確に理解している場合は、最初にモデルを選択し、それらの仕様に適合するデータを収集できます。

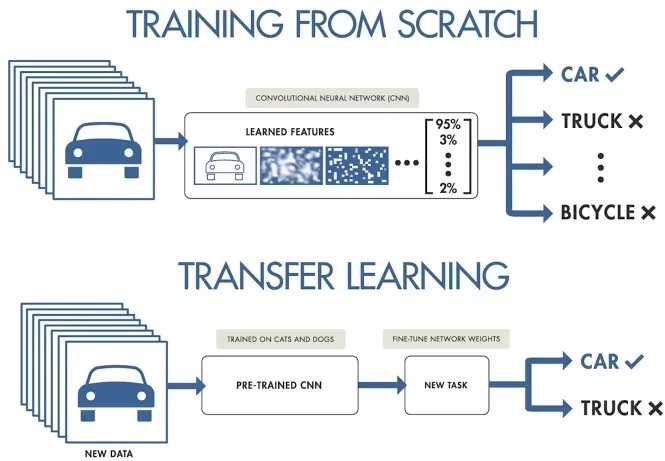

スクラッチからのトレーニングと転移学習の使用のどちらを選択するかは、データの準備方法に影響します。スクラッチからのトレーニングでは、モデルの理解をゼロから構築するために多様なデータセットが必要です。一方、転移学習では、事前学習済みモデルを使用し、より小さく、より具体的なデータセットで適応させることができます。また、トレーニングする特定のモデルを選択することで、モデルの特定の要件に応じて、画像のサイズ変更やアノテーションの追加など、データを準備する方法が決まります。

注:モデルを選択する際は、互換性とパフォーマンスを確保するために、デプロイメントを考慮してください。たとえば、軽量モデルは、リソースが限られたデバイスでの効率性から、エッジコンピューティングに最適です。プロジェクトの定義に関する重要なポイントの詳細については、プロジェクトの目標を定義し、適切なモデルを選択するためのガイドをお読みください。

コンピュータビジョンプロジェクトの実践的な作業に入る前に、これらの詳細を明確に理解しておくことが重要です。ステップ2に進む前に、次のことを検討したことを再確認してください。

- 解決しようとしている問題を明確に定義します。

- プロジェクトの最終目標を決定します。

- 必要な特定のコンピュータービジョンタスク(例:物体検出、画像分類、画像セグメンテーション)を特定します。

- モデルを最初からトレーニングするか、転移学習を使用するかを決定します。

- タスクとデプロイのニーズに適したモデルを選択してください。

ステップ2:データ収集とデータアノテーション

コンピュータービジョンモデルの品質は、データセットの品質に依存します。インターネットから画像を収集したり、自分で写真を撮ったり、既存のデータセットを使用したりできます。高品質なデータセットをダウンロードするための優れたリソースをいくつか紹介します:Google Dataset Search Engine、UC Irvine Machine Learning Repository、Kaggle Datasets。

Ultralyticsなどの一部のライブラリは、さまざまなデータセットに対する組み込みサポートを提供しており、高品質のデータを簡単に使い始めることができます。これらのライブラリには、一般的なデータセットをシームレスに使用するためのユーティリティが含まれていることが多く、プロジェクトの初期段階で多くの時間と労力を節約できます。

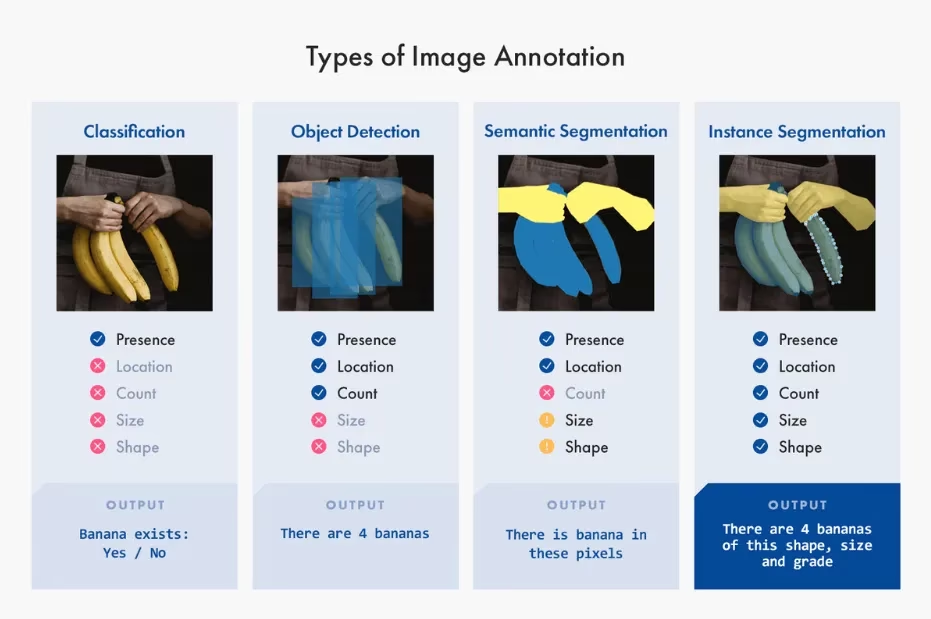

ただし、画像を収集したり、自分で写真を撮る場合は、データにアノテーションを付ける必要があります。データアノテーションとは、モデルに知識を付与するためにデータにラベルを付けるプロセスです。使用するデータアノテーションの種類は、特定のコンピュータビジョン技術によって異なります。以下にいくつかの例を示します。

- 画像分類: 画像全体を単一のクラスとしてラベル付けします。

- 物体検出: 画像内の各オブジェクトの周りにバウンディングボックスを描画し、各ボックスにラベルを付けます。

- 画像セグメンテーション: 画像内の各ピクセルを、それが属するオブジェクトに従ってラベル付けし、詳細なオブジェクト境界を作成します。

データ収集とアノテーションは、時間のかかる手作業になる可能性があります。アノテーションツールは、このプロセスを容易にするのに役立ちます。役立つオープンアノテーションツールを以下に示します:LabeI Studio、CVAT、Labelme。

ステップ3:データ拡張とデータセットの分割

画像データを収集してアノテーションを付けた後、データ拡張を実行する前に、まずデータセットをトレーニング、検証、およびテストセットに分割することが重要です。拡張の前にデータセットを分割することは、元の変更されていないデータでモデルをテストおよび検証するために重要です。これにより、モデルが新しい、未知のデータにどれだけうまく一般化できるかを正確に評価できます。

データ分割の方法は以下のとおりです。

- トレーニングセット: これはデータの最大の部分であり、通常は合計の70〜80%で、モデルのトレーニングに使用されます。

- Validation Set(検証用データセット): 通常、データ全体の10~15%程度。ハイパーパラメータの調整や、学習中のモデルの検証に用いられ、過学習を防ぐのに役立ちます。

- Test Set: 残りの10〜15%のデータは、テストセットとして確保されます。これは、トレーニング完了後に、モデルが未知のデータに対してどの程度機能するかを評価するために使用されます。

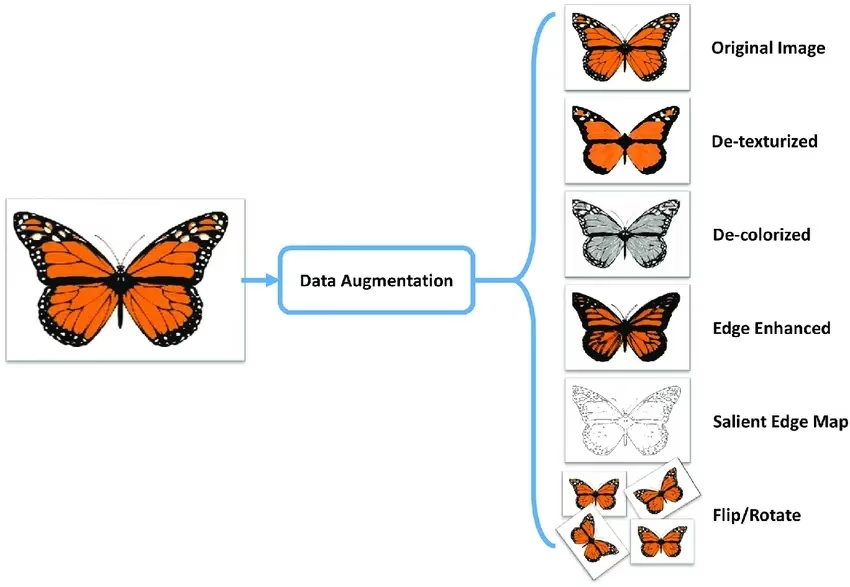

データを分割した後、画像の回転、拡大縮小、反転などの変換を適用してデータ拡張を実行し、データセットのサイズを人工的に増やすことができます。データ拡張により、モデルはバリエーションに対してより堅牢になり、未知の画像に対するパフォーマンスが向上します。

OpenCV、Albumentations、TensorFlowなどのライブラリは、使用できる柔軟な拡張機能を提供しています。さらに、Ultralyticsなどの一部のライブラリには、モデルトレーニング機能内に組み込みの拡張設定が直接用意されており、プロセスを簡素化します。

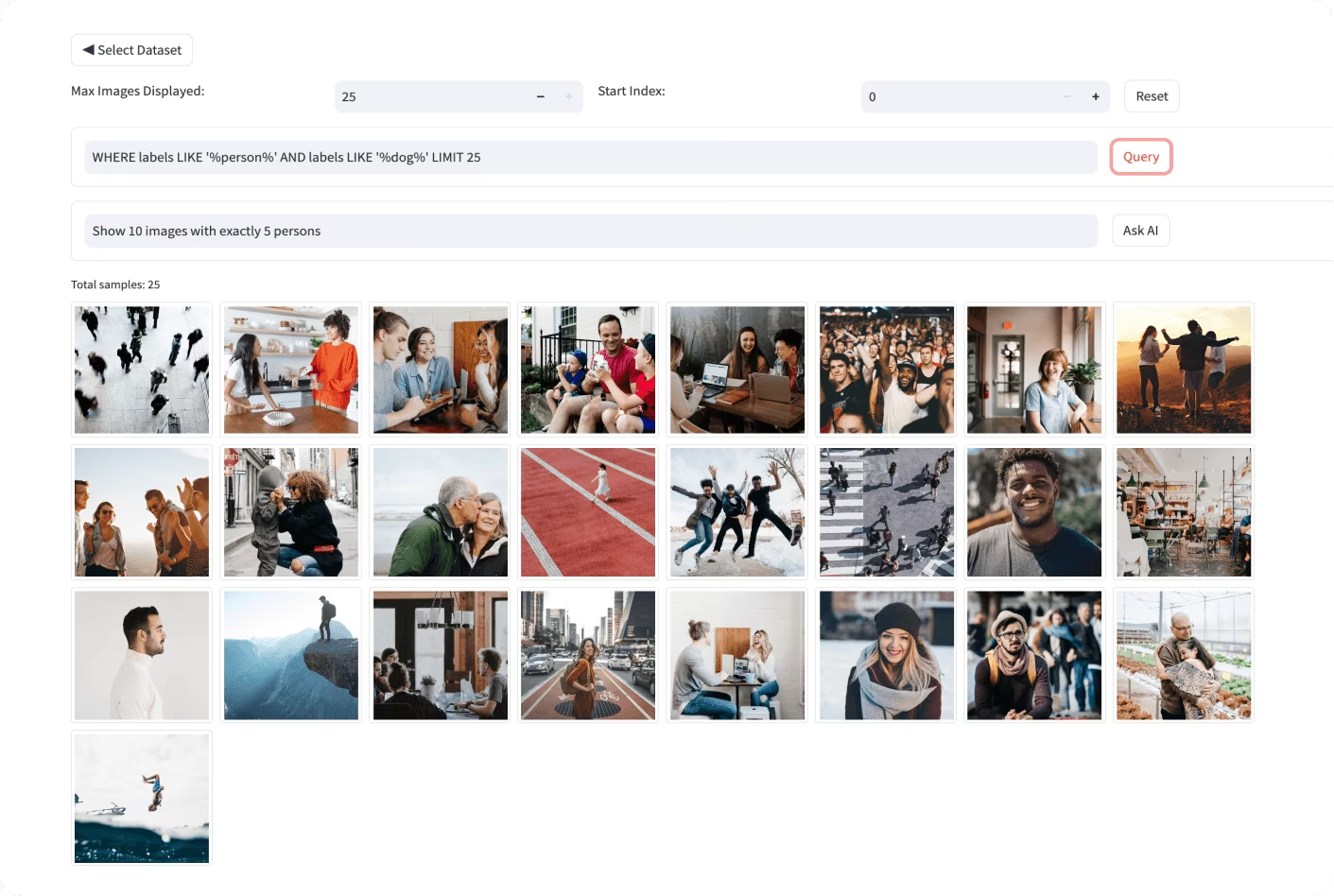

データをよりよく理解するために、MatplotlibやSeabornなどのツールを使用して画像を視覚化し、その分布と特性を分析できます。データを視覚化することで、パターン、異常、および拡張手法の有効性を特定するのに役立ちます。また、セマンティック検索、SQLクエリ、ベクター類似性検索を備えたコンピュータービジョンデータセットを探索するためのツールであるUltralytics Explorerを使用することもできます。

適切にデータを理解し、分割し、拡張することで、現実世界のアプリケーションで優れたパフォーマンスを発揮する、十分にトレーニングされ、検証され、テストされたモデルを開発できます。

ステップ 4: モデルのトレーニング

データセットのトレーニング準備が整ったら、必要な環境のセットアップ、データセットの管理、およびモデルのトレーニングに集中できます。

まず、環境が正しく構成されていることを確認する必要があります。通常、これには以下が含まれます。

- TensorFlow、PyTorch、またはUltralyticsのような必須ライブラリとフレームワークのインストール。

- GPUを使用している場合は、CUDAやcuDNNなどのライブラリをインストールすると、GPUアクセラレーションが有効になり、トレーニングプロセスが高速化されます。

次に、トレーニングデータセットと検証データセットを環境にロードできます。サイズ変更、形式変換、または拡張を通じてデータを正規化および前処理します。モデルを選択したら、レイヤーを構成し、ハイパーパラメータを指定します。損失関数、オプティマイザー、およびパフォーマンスメトリクスを設定して、モデルをコンパイルします。

Ultralyticsのようなライブラリは、トレーニングプロセスを簡素化します。最小限のコードでモデルにデータを供給することにより、トレーニングを開始できます。これらのライブラリは、重みの調整、バックプロパゲーション、および検証を自動的に処理します。また、進捗状況を監視し、ハイパーパラメータを簡単に調整するためのツールも提供します。トレーニング後、いくつかのコマンドでモデルとその重みを保存します。

効率的なトレーニングには適切なデータセット管理が不可欠であることを覚えておくことが重要です。データセットのバージョン管理を使用して変更を追跡し、再現性を確保します。DVC (Data Version Control)のようなツールは、大規模なデータセットの管理に役立ちます。

ステップ 5: モデルの評価とモデルの微調整

さまざまな指標を使用してモデルのパフォーマンスを評価し、精度を向上させるために改良することが重要です。評価は、モデルが優れている領域と改善が必要な領域を特定するのに役立ちます。微調整により、モデルが可能な限り最高のパフォーマンスを発揮できるように最適化されます。

- パフォーマンス指標: 精度、適合率、再現率、F1スコアなどの指標を使用して、モデルのパフォーマンスを評価します。これらの指標は、モデルがどの程度適切に予測を行っているかについての洞察を提供します。

- ハイパーパラメータの調整: ハイパーパラメータを調整して、モデルのパフォーマンスを最適化します。グリッドサーチやランダムサーチなどの手法は、最適なハイパーパラメータ値を見つけるのに役立ちます。

- 微調整: モデルアーキテクチャまたはトレーニングプロセスに小さな調整を加えて、パフォーマンスを向上させます。 これには、学習率、バッチサイズ、またはその他のモデルパラメータの調整が含まれる場合があります。

モデルの評価と微調整の手法をより深く理解するには、モデル評価の洞察ガイドをご覧ください。

ステップ 6: モデルのテスト

このステップでは、モデルが完全に未知のデータで適切に機能することを確認し、デプロイの準備ができていることを確認できます。モデルのテストとモデルの評価の違いは、反復的に改善するのではなく、最終的なモデルのパフォーマンスを検証することに重点を置いていることです。

発生する可能性のある一般的な問題を徹底的にテストおよびデバッグすることが重要です。トレーニングまたは検証中に使用されなかった別のテストデータセットでモデルをテストします。このデータセットは、モデルのパフォーマンスが一貫性があり信頼できることを保証するために、現実世界のシナリオを表す必要があります。

また、過学習、学習不足、データリークなどの一般的な問題にも対処してください。交差検証や異常検出などの手法を使用して、これらの問題を特定して修正します。包括的なテスト戦略については、モデルテストガイドを参照してください。

ステップ 7: モデルのデプロイ

モデルのテストが完了したら、いよいよデプロイです。モデルのデプロイとは、モデルを本番環境で使用できるようにすることです。以下に、コンピュータビジョンモデルをデプロイする手順を示します。

- 環境のセットアップ: クラウドベース(AWS、Google Cloud、Azure)であろうと、エッジベース(ローカルデバイス、IoT)であろうと、選択したデプロイオプションに必要なインフラストラクチャを構成します。

- モデルのエクスポート: モデルを適切な形式(例:YOLO26の場合はONNX、TensorRT、CoreML)にエクスポートし、デプロイメントプラットフォームとの互換性を確保します。

- モデルのデプロイ: APIまたはエンドポイントを設定し、アプリケーションと統合してモデルをデプロイします。

- スケーラビリティの確保: リソースを管理し、増加するデータとユーザーリクエストを処理するために、ロードバランサー、自動スケーリンググループ、および監視ツールを実装します。

デプロイ戦略とベストプラクティスに関する詳細なガイダンスについては、モデルデプロイメントプラクティスガイドをご覧ください。

ステップ 8: 監視、メンテナンス、およびドキュメント

モデルをデプロイしたら、パフォーマンスを継続的に監視し、問題に対処するためにメンテナンスを行い、将来の参照と改善のためにプロセス全体を文書化することが重要です。

監視ツールは、主要業績評価指標 (KPI) を追跡し、異常や精度の低下を検出するのに役立ちます。モデルを監視することで、入力データの変化によりモデルのパフォーマンスが時間とともに低下するモデルドリフトを認識できます。精度と関連性を維持するために、更新されたデータでモデルを定期的に再トレーニングします。

監視とメンテナンスに加えて、ドキュメント化も重要です。モデルアーキテクチャ、トレーニング手順、ハイパーパラメータ、データ前処理ステップ、およびデプロイメントとメンテナンス中に加えられた変更など、プロセス全体を徹底的に文書化します。優れたドキュメント化は、再現性を保証し、将来の更新またはトラブルシューティングを容易にします。モデルの監視、保守、およびドキュメント化を効果的に行うことで、ライフサイクル全体にわたって正確で信頼性が高く、管理しやすい状態を維持できます。

コミュニティとの連携

コンピュータビジョンのコミュニティと繋がることで、コンピュータビジョンプロジェクトに取り組む際に直面するあらゆる問題を自信を持って解決できます。効果的に学び、トラブルシューティングを行い、ネットワークを構築するための方法をいくつかご紹介します。

コミュニティリソース

- GitHub Issues: YOLO26 GitHubリポジトリを確認し、Issuesタブを使用して質問したり、バグを報告したり、新機能を提案したりしてください。活発なコミュニティとメンテナーが、特定の問題についてサポートします。

- Ultralytics Discordサーバー: Ultralytics Discordサーバーに参加して、他のユーザーや開発者と交流し、サポートを受け、洞察を共有しましょう。

公式ドキュメント

- Ultralytics YOLO26ドキュメント: 公式YOLO26ドキュメントを参照し、さまざまなコンピュータビジョンタスクやプロジェクトに関する役立つヒントが記載された詳細なガイドを確認してください。

これらのリソースを使用すると、課題を克服し、コンピュータービジョンコミュニティの最新のトレンドとベストプラクティスを常に把握できます。

次のステップ

コンピュータービジョンプロジェクトに取り組むことは、刺激的でやりがいのあることです。このガイドの手順に従うことで、成功のための強固な基盤を築くことができます。各ステップは、目標を達成し、現実世界のシナリオでうまく機能するソリューションを開発するために不可欠です。経験を積むにつれて、プロジェクトを改善するための高度な技術やツールを発見するでしょう。

よくある質問

プロジェクトに適したコンピュータビジョンタスクを選択するにはどうすればよいですか?

適切なコンピュータビジョンタスクの選択は、プロジェクトの最終目標によって異なります。たとえば、交通状況を監視したい場合、リアルタイムで複数の車種を特定できる物体検出が適しています。医療画像処理の場合、腫瘍の詳細な境界線を提供し、診断と治療計画を支援する画像セグメンテーションが理想的です。物体検出、画像分類、インスタンスセグメンテーションなどの特定のタスクの詳細をご覧ください。

コンピュータビジョンプロジェクトにおいて、データアノテーションが重要なのはなぜですか?

データアノテーションは、モデルにパターンを認識させるために不可欠です。アノテーションの種類はタスクによって異なります。

- 画像分類: 画像全体を単一のクラスとしてラベル付けします。

- Object Detection: オブジェクトの周りに描かれたバウンディングボックス。

- 画像セグメンテーション: 各ピクセルを、それが属するオブジェクトに従ってラベル付けします。

Label Studio、CVAT、Labelmeなどのツールがこのプロセスを支援します。詳細については、データ収集とアノテーションのガイドを参照してください。

データセットを効果的に拡張および分割するには、どのような手順に従うべきですか?

データ拡張の前にデータセットを分割すると、元の変更されていないデータに対するモデルのパフォーマンスを検証するのに役立ちます。以下の手順に従ってください。

- トレーニングセット:データの70〜80%。

- Validation Set(検証用データセット): ハイパーパラメータ調整用に10~15%。

- Test Set: 最終評価用に残りの10〜15%。

分割後、データセットの多様性を高めるために、回転、スケーリング、反転などのデータ拡張手法を適用します。AlbumentationsやOpenCVなどのライブラリが役立ちます。Ultralyticsは、利便性のために組み込みの拡張設定も提供しています。

学習済みのコンピュータビジョンモデルをデプロイ用にエクスポートするにはどうすればよいですか?

モデルをエクスポートすることで、さまざまなデプロイメントプラットフォームとの互換性が確保されます。Ultralyticsは、ONNX、TensorRT、CoreMLを含む複数の形式を提供します。YOLO26モデルをエクスポートするには、このガイドに従ってください。

- 以下を使用します

export目的の形式パラメータを持つ関数。 - エクスポートされたモデルが、デプロイメント環境(エッジデバイス、クラウドなど)の仕様に適合していることを確認してください。

詳細については、モデルエクスポートガイドをご覧ください。

デプロイされたコンピュータビジョンモデルを監視および維持するためのベストプラクティスは何ですか?

モデルの長期的な成功には、継続的な監視とメンテナンスが不可欠です。主要業績評価指標(KPI)を追跡し、異常を検出するためのツールを実装してください。モデルのドリフトに対抗するために、更新されたデータで定期的にモデルを再トレーニングしてください。再現性と将来の更新を容易にするために、モデルアーキテクチャ、ハイパーパラメータ、変更など、プロセス全体を文書化してください。詳細については、監視とメンテナンスのガイドをご覧ください。