Neural MagicのDeepSparse EngineによるYOLO26推論の最適化

物体検出モデル、例えばUltralytics YOLO26を様々なハードウェアにデプロイする際、最適化のような特有の問題に直面することがあります。ここでYOLO26とNeural MagicのDeepSparse Engineの統合が役立ちます。これにより、YOLO26モデルの実行方法が変革され、CPU上で直接GPUレベルのパフォーマンスが実現可能になります。

このガイドでは、Neural MagicのDeepSparseを使用してYOLO26をデプロイし、推論を実行する方法、そしてパフォーマンスをベンチマークして最適化されていることを確認する方法について説明します。

SparseML EOL

Neural Magicは 2025 年 1 月に Red Hat に買収されました、およびコミュニティ版の deepsparse, sparseml, sparsezoo、および sparsify ライブラリ。詳細については、掲載されている通知をご覧ください。 Readmeの sparseml GitHubリポジトリ.

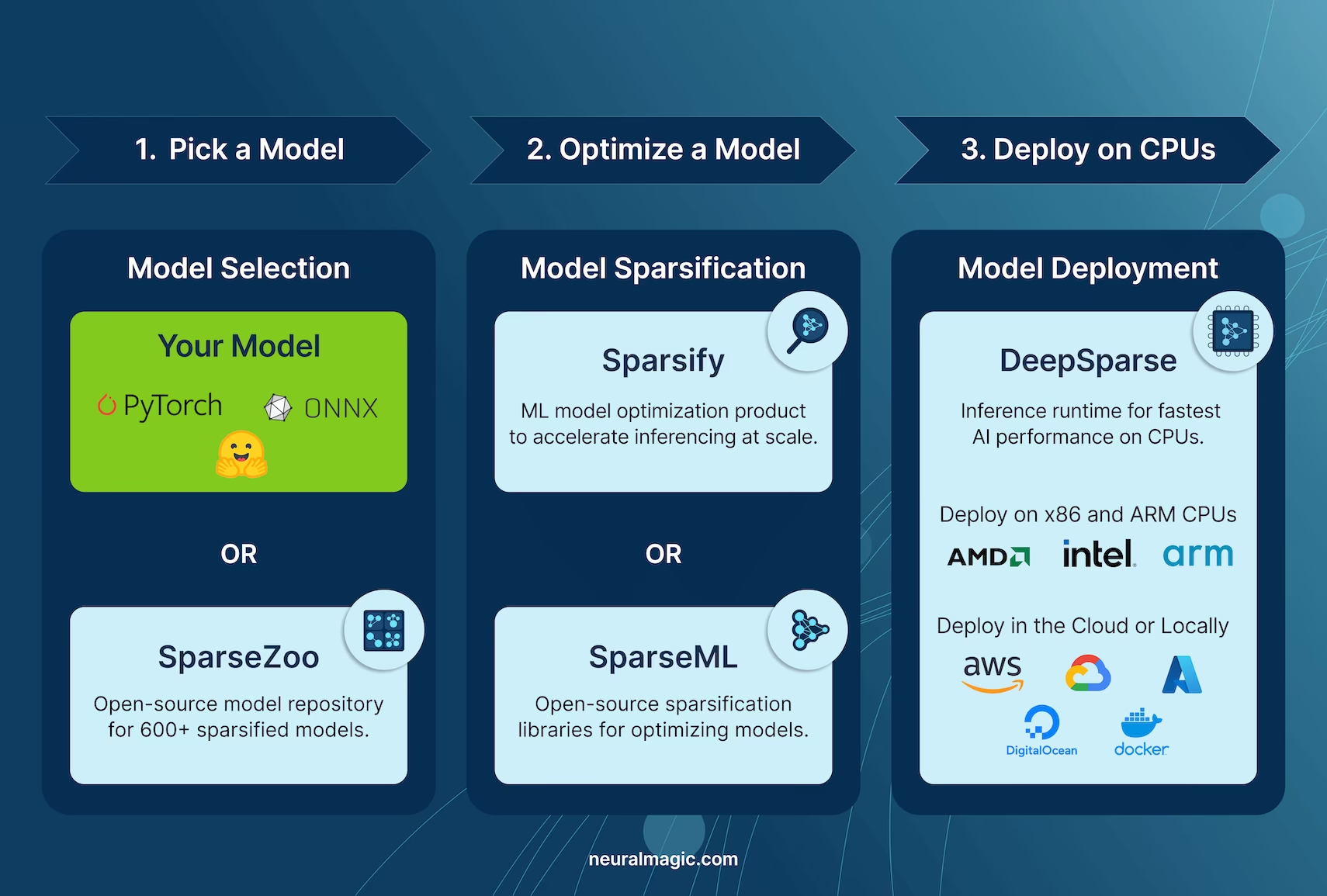

Neural MagicのDeepSparse

Neural Magic's DeepSparseは、CPU上でのニューラルネットワークの実行を最適化するように設計された推論ランタイムです。スパース性、枝刈り、量子化などの高度な手法を適用して、精度を維持しながら計算需要を大幅に削減します。DeepSparseは、さまざまなデバイスにわたる効率的でスケーラブルなニューラルネットワーク実行のためのアジャイルソリューションを提供します。

Neural MagicのDeepSparseとYOLO26を統合する利点

DeepSparseを使用してYOLO26をデプロイする方法について詳しく説明する前に、DeepSparseを使用する利点を理解しましょう。主な利点には以下が含まれます。

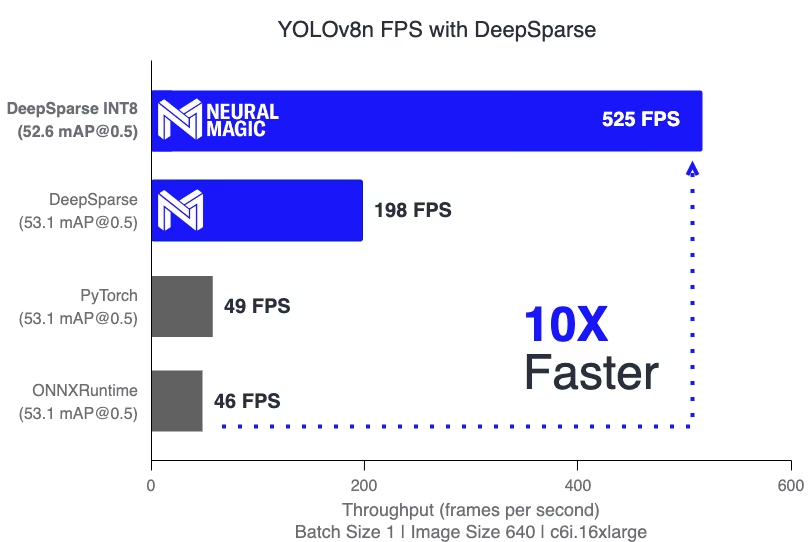

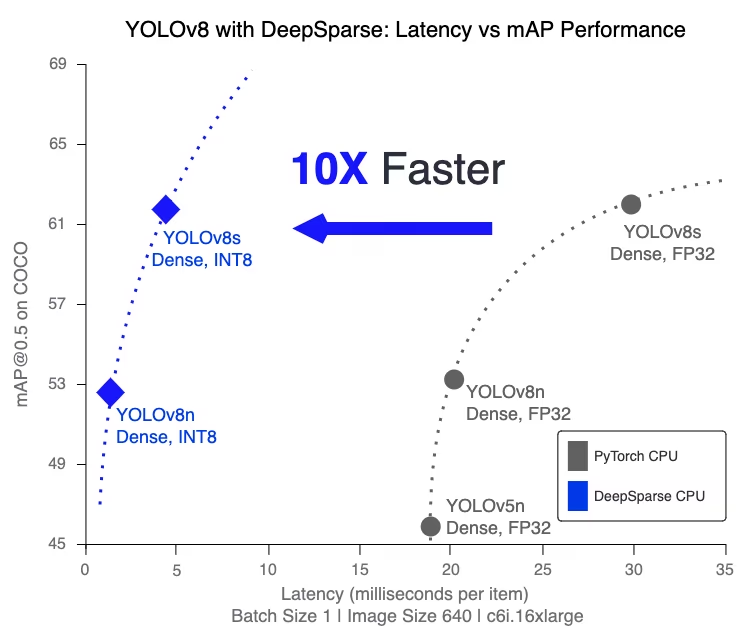

- 推論速度の向上: 最大525 FPS(YOLO11nの場合)を達成し、従来の方法と比較してYOLOの推論能力を大幅に高速化します。

- モデル効率の最適化: プルーニングと量子化を使用し、YOLO26の効率を向上させ、精度を維持しながらモデルサイズと計算要件を削減します。

標準CPUでの高パフォーマンス: CPU上でGPUのようなパフォーマンスを提供し、さまざまなアプリケーションに対して、よりアクセスしやすく、コスト効率の高いオプションを提供します。

統合とデプロイの合理化: 画像およびビデオのアノテーション機能を含め、YOLO26をアプリケーションに簡単に統合するためのユーザーフレンドリーなツールを提供します。

様々なモデルタイプのサポート: 標準モデルとスパース性最適化YOLO26モデルの両方に対応しており、デプロイの柔軟性を高めます。

費用対効果が高くスケーラブルなソリューション:運用コストを削減し、高度な物体検出モデルのスケーラブルなデプロイメントを提供します。

Neural MagicのDeepSparseテクノロジーはどのように機能しますか?

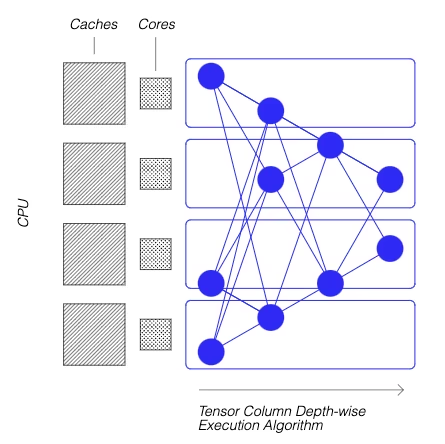

Neural Magic の DeepSparse テクノロジーは、ニューラルネットワーク計算における人間の脳の効率性に触発されています。それは、脳から以下の2つの主要な原則を採用しています。

スパース性: スパース化のプロセスでは、深層学習ネットワークから冗長な情報を取り除くことで、精度を損なうことなく、より小型で高速なモデルを実現します。この技術により、ネットワークのサイズと計算に必要なリソースを大幅に削減できます。

参照の局所性: DeepSparseは、ネットワークをTensor Columnsに分割する独自の方法を使用します。これらのカラムは、CPUのキャッシュ内に完全に収まるように、深さ方向に実行されます。このアプローチは、脳の効率を模倣し、データ移動を最小限に抑え、CPUのキャッシュ使用率を最大化します。

カスタムデータセットでトレーニングされたYOLO26のスパースバージョンを作成する

Neural Magicが提供するオープンソースのモデルリポジトリであるSparseZooは、事前にスパース化されたYOLO26モデルのチェックポイントのコレクションを提供しています。Ultralyticsとシームレスに統合されたSparseMLを使用すると、ユーザーはシンプルなコマンドラインインターフェースを用いて、これらのスパースなチェックポイントを独自のデータセットで簡単にファインチューニングできます。

詳細については、Neural MagicのSparseML YOLO26ドキュメントを参照してください。

使用法:DeepSparseを使用したYOLO26のデプロイ

Neural MagicのDeepSparseでYOLO26をデプロイするには、いくつかの簡単なステップが必要です。使用方法の説明に入る前に、Ultralyticsが提供するYOLO26モデルの範囲を必ず確認してください。これにより、プロジェクトの要件に最も適したモデルを選択できます。ここから始めましょう。

ステップ1:インストール

必要なパッケージをインストールするには、以下を実行します:

インストール

# Install the required packages

pip install deepsparse[yolov8]

ステップ2:YOLO26をONNX形式にエクスポートする

DeepSparse EngineはONNX形式のYOLO26モデルを必要とします。DeepSparseとの互換性のためには、モデルをこの形式にエクスポートすることが不可欠です。YOLO26モデルをエクスポートするには、以下のコマンドを使用します。

モデルのエクスポート

# Export YOLO26 model to ONNX format

yolo task=detect mode=export model=yolo26n.pt format=onnx opset=13

このコマンドは、 yolo26n.onnx モデルをディスクにエクスポートします。

ステップ 3: 推論のデプロイと実行

YOLO26モデルがONNX形式であれば、DeepSparseを使用してデプロイし、推論を実行できます。これは、直感的なPython APIで簡単に行うことができます。

推論のデプロイと実行

from deepsparse import Pipeline

# Specify the path to your YOLO26 ONNX model

model_path = "path/to/yolo26n.onnx"

# Set up the DeepSparse Pipeline

yolo_pipeline = Pipeline.create(task="yolov8", model_path=model_path)

# Run the model on your images

images = ["path/to/image.jpg"]

pipeline_outputs = yolo_pipeline(images=images)

ステップ 4: パフォーマンスのベンチマーク

DeepSparse上でYOLO26モデルが最適に動作しているかを確認することが重要です。スループットとレイテンシを分析するために、モデルのパフォーマンスをベンチマークできます。

ベンチマーク

# Benchmark performance

deepsparse.benchmark model_path="path/to/yolo26n.onnx" --scenario=sync --input_shapes="[1,3,640,640]"

ステップ 5: 追加機能

DeepSparseは、画像アノテーションやデータセット評価など、アプリケーションにおけるYOLO26の実用的な統合のための追加機能を提供します。

追加機能

# For image annotation

deepsparse.yolov8.annotate --source "path/to/image.jpg" --model_filepath "path/to/yolo26n.onnx"

# For evaluating model performance on a dataset

deepsparse.yolov8.eval --model_path "path/to/yolo26n.onnx"

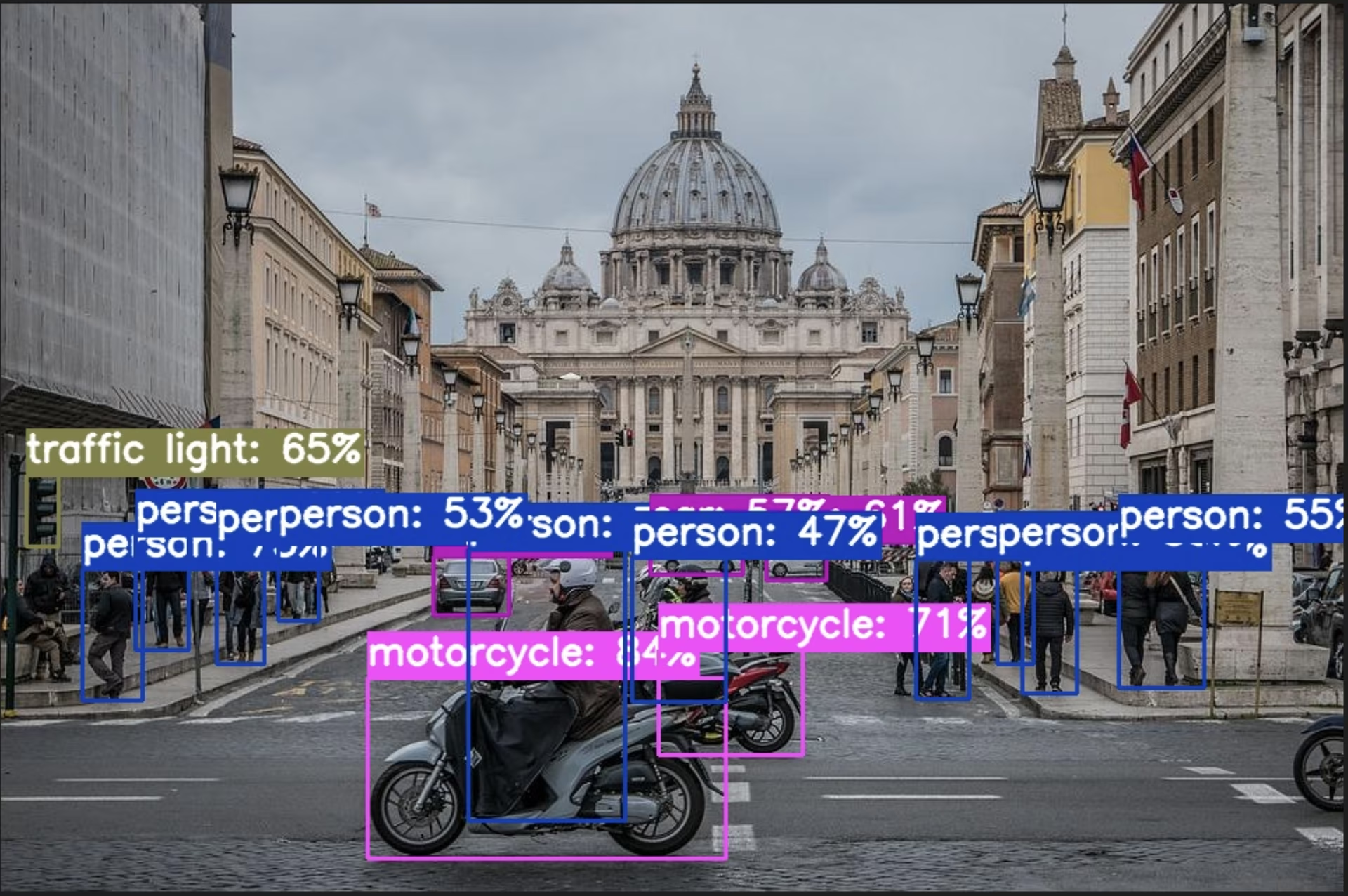

annotate コマンドを実行すると、指定した画像が処理され、オブジェクトが検出され、バウンディングボックスと分類を含むアノテーション付きの画像が保存されます。アノテーション付きの画像は、annotation-results フォルダに保存されます。これは、モデルの検出機能の視覚的な表現を提供するのに役立ちます。

evalコマンドを実行すると、precision、recall、およびmAP(平均平均精度)などの詳細な出力メトリクスが得られます。これは、データセット上でのモデルのパフォーマンスの包括的なビューを提供し、特定のユースケース向けにYOLO26モデルをファインチューニングおよび最適化するのに特に役立ち、高い精度と効率を確保します。

概要

このガイドでは、UltralyticsのYOLO26とNeural MagicのDeepSparse Engineの統合について解説しました。この統合がCPUプラットフォームでのYOLO26のパフォーマンスをどのように向上させ、GPUレベルの効率と高度なニューラルネットワークスパース性技術を提供するかを強調しました。

詳細情報や高度な使用方法については、Neural MagicによるDeepSparseドキュメントをご覧ください。また、YOLO26統合ガイドを参照したり、YouTubeでウォークスルーセッションを視聴することもできます。

さらに、様々なYOLO26統合についてより広く理解するために、Ultralytics統合ガイドページをご覧ください。そこでは、他にも様々な魅力的な統合の可能性を発見できます。

よくある質問

Neural MagicのDeepSparse Engineとは何ですか、またYOLO26のパフォーマンスをどのように最適化しますか?

Neural MagicのDeepSparse Engineは、スパース性、プルーニング、量子化などの高度な技術を通じて、CPU上でのニューラルネットワークの実行を最適化するために設計された推論ランタイムです。DeepSparseをYOLO26と統合することで、標準的なCPUでGPUのようなパフォーマンスを達成でき、精度を維持しながら推論速度、モデル効率、および全体的なパフォーマンスを大幅に向上させることができます。詳細については、Neural MagicのDeepSparseセクションをご覧ください。

Neural MagicのDeepSparseを使用してYOLO26をデプロイするために必要なパッケージをインストールするにはどうすればよいですか?

Neural MagicのDeepSparseでYOLO26をデプロイするために必要なパッケージのインストールは簡単です。CLIを使用して簡単にインストールできます。実行する必要があるコマンドは次のとおりです。

pip install deepsparse[yolov8]

インストール後、インストールセクションに記載されている手順に従って環境をセットアップし、DeepSparseをYOLO26と併用を開始してください。

DeepSparseで使用するためにYOLO26モデルをONNX形式に変換するにはどうすればよいですか?

DeepSparseとの互換性のために必要なONNX形式にYOLO26モデルを変換するには、以下のCLIコマンドを使用できます。

yolo task=detect mode=export model=yolo26n.pt format=onnx opset=13

このコマンドはYOLO26モデルをエクスポートします(yolo26n.pt)形式に変換できます(yolo26n.onnx)で、DeepSparse Engineで利用できます。モデルのエクスポートに関する詳細は、 モデルのエクスポートセクション.

DeepSparse Engine上でYOLO26のパフォーマンスをベンチマークするにはどうすればよいですか?

DeepSparse上でのYOLO26のパフォーマンスベンチマークは、スループットとレイテンシの分析に役立ち、モデルが最適化されていることを確認できます。ベンチマークを実行するには、以下のCLIコマンドを使用します。

deepsparse.benchmark model_path="path/to/yolo26n.onnx" --scenario=sync --input_shapes="[1,3,640,640]"

このコマンドは、重要なパフォーマンス指標を提供します。詳細については、パフォーマンスのベンチマークセクションを参照してください。

物体検出タスクにNeural MagicのDeepSparseとYOLO26を併用するメリットは何ですか?

Neural MagicのDeepSparseとYOLO26の統合は、いくつかの利点をもたらします。

- 推論速度の向上: 最大525 FPS(YOLO11nの場合)を達成し、DeepSparseの最適化能力を示しています。

- 最適化されたモデル効率: 精度を維持しながら、モデルサイズと計算ニーズを削減するために、スパース性、プルーニング、および量子化の手法を使用します。

- 標準CPUでの高パフォーマンス: コスト効率の高いCPUハードウェア上でGPUのようなパフォーマンスを提供します。

- 合理化された統合: 容易なデプロイと統合のための、ユーザーフレンドリーなツール。

- 柔軟性: 標準モデルとスパース性最適化YOLO26モデルの両方をサポートします。

- 費用対効果: 効率的なリソース活用により、運用コストを削減します。

これらの利点の詳細については、Neural MagicのDeepSparseとYOLO26を統合する利点セクションをご覧ください。