Ensemble de données COCO-Seg

L'ensemble de données COCO-Seg, une extension de l'ensemble de données COCO (Common Objects in Context), est spécialement conçu pour faciliter la recherche dans la segmentation d'instance d'objets. Il utilise les mêmes images que COCO, mais introduit des annotations de segmentation plus détaillées. Cet ensemble de données est une ressource essentielle pour les chercheurs et les développeurs travaillant sur des tâches de segmentation d'instance, en particulier pour la formation de modèles Ultralytics YOLO.

Modèles pré-entraînés COCO-Seg

| Modèle | Taille (pixels) | mAPbox 50-95(e2e) | mAPmasque 50-95(e2e) | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Principales caractéristiques

- COCO-Seg conserve les 330 000 images originales de COCO.

- L'ensemble de données est constitué des mêmes 80 catégories d'objets que celles de l'ensemble de données COCO original.

- Les annotations comprennent désormais des masques de segmentation d'instances plus détaillés pour chaque objet dans les images.

- COCO-Seg fournit des métriques d'évaluation standardisées telles que la précision moyenne moyenne (mAP) pour la détection d'objets, et le rappel moyen moyen (mAR) pour les tâches de segmentation d'instances, permettant une comparaison efficace des performances des modèles.

Structure du jeu de données

L'ensemble de données COCO-Seg est divisé en trois sous-ensembles :

- Train2017 : 118 000 images pour la formation de modèles de segmentation d’instance.

- Val2017 : 5 000 images utilisées pour la validation pendant le développement du modèle.

- Test2017 : 20 000 images utilisées pour l’évaluation comparative. Les annotations de vérité terrain pour ce sous-ensemble ne sont pas accessibles au public, les prédictions doivent donc être soumises au serveur d’évaluation COCO pour la notation.

Applications

COCO-Seg est largement utilisé pour l'entraînement et l'évaluation des modèles de deep learning dans la segmentation d'instances, tels que les modèles YOLO. Le grand nombre d'images annotées, la diversité des catégories d'objets et les métriques d'évaluation standardisées en font une ressource indispensable pour les chercheurs et les praticiens en vision par ordinateur.

YAML du jeu de données

Un fichier YAML (Yet Another Markup Language) est utilisé pour définir la configuration du dataset. Il contient des informations sur les chemins, les classes et d'autres informations pertinentes du dataset. Dans le cas du dataset COCO-Seg, le coco.yaml fichier est maintenu à l'adresse https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco.yaml.

ultralytics/cfg/datasets/coco.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # val images (relative to 'path') 5000 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

segments = True # segment or box labels

dir = Path(yaml["path"]) # dataset root dir

urls = [ASSETS_URL + ("/coco2017labels-segments.zip" if segments else "/coco2017labels.zip")] # labels

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

Utilisation

Pour entraîner un modèle YOLO26n-seg sur le jeu de données COCO-Seg pendant 100 époques avec une taille d'image de 640, vous pouvez utiliser les extraits de code suivants. Pour une liste complète des arguments disponibles, consultez la page d'entraînement du modèle.

Exemple d'entraînement

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo segment train data=coco.yaml model=yolo26n-seg.pt epochs=100 imgsz=640

Images et annotations d'exemple

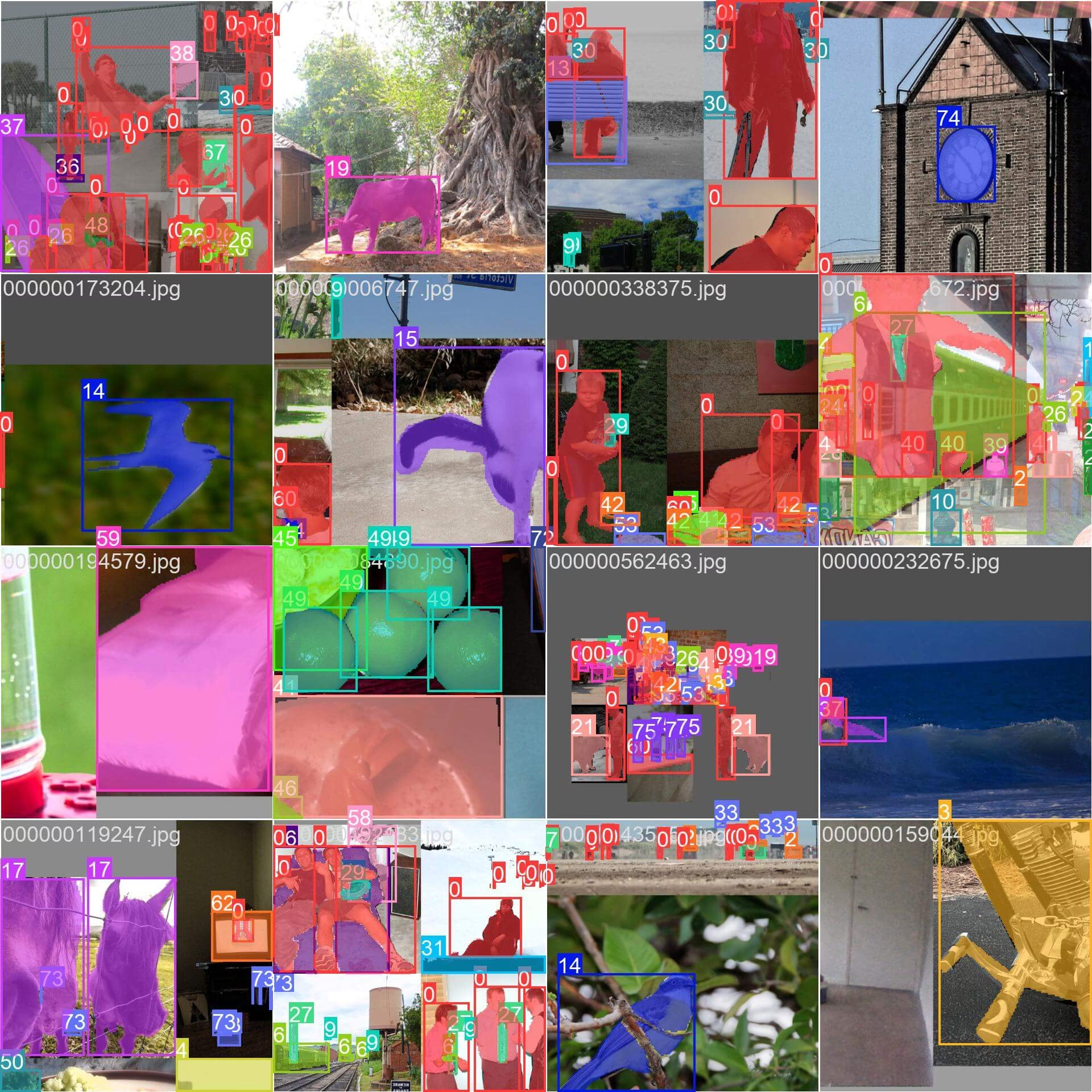

COCO-Seg, comme son prédécesseur COCO, contient un ensemble diversifié d'images avec diverses catégories d'objets et des scènes complexes. Cependant, COCO-Seg introduit des masques de segmentation d'instances plus détaillés pour chaque objet dans les images. Voici quelques exemples d'images de l'ensemble de données, ainsi que leurs masques de segmentation d'instances correspondants :

- Image mosaiquée : Cette image montre un lot d’entraînement composé d’images d’ensemble de données en mosaïque. La mosaïque est une technique utilisée pendant l’entraînement qui combine plusieurs images en une seule image afin d’accroître la variété des objets et des scènes dans chaque lot d’entraînement. Cela aide la capacité du modèle à se généraliser à différentes tailles d’objet, rapports d’aspect et contextes.

L'exemple illustre la variété et la complexité des images dans l'ensemble de données COCO-Seg et les avantages de l'utilisation du mosaïquage pendant le processus d'entraînement.

Citations et remerciements

Si vous utilisez l'ensemble de données COCO-Seg dans vos travaux de recherche ou de développement, veuillez citer l'article COCO original et reconnaître l'extension à COCO-Seg :

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Nous remercions le COCO Consortium d'avoir créé et maintenu cette ressource inestimable pour la communauté de la vision par ordinateur. Pour plus d'informations sur l'ensemble de données COCO et ses créateurs, visitez le site web de l'ensemble de données COCO.

FAQ

Qu’est-ce que le jeu de données COCO-Seg et en quoi diffère-t-il du jeu de données COCO original ?

L'ensemble de données COCO-Seg est une extension de l'ensemble de données COCO (Common Objects in Context) original, spécialement conçu pour les tâches de segmentation d'instance. Bien qu'il utilise les mêmes images que l'ensemble de données COCO, COCO-Seg comprend des annotations de segmentation plus détaillées, ce qui en fait une ressource puissante pour les chercheurs et les développeurs qui se concentrent sur la segmentation d'instance d'objet.

Comment puis-je entraîner un modèle YOLO26 en utilisant le jeu de données COCO-Seg ?

Pour entraîner un modèle YOLO26n-seg sur le jeu de données COCO-Seg pendant 100 époques avec une taille d'image de 640, vous pouvez utiliser les extraits de code suivants. Pour une liste détaillée des arguments disponibles, consultez la page d'entraînement du modèle.

Exemple d'entraînement

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo segment train data=coco.yaml model=yolo26n-seg.pt epochs=100 imgsz=640

Quelles sont les principales caractéristiques du jeu de données COCO-Seg ?

L'ensemble de données COCO-Seg comprend plusieurs fonctionnalités clés :

- Conserve les 330 000 images originales de l'ensemble de données COCO.

- Annote les 80 catégories d'objets présentes dans le COCO original.

- Fournit des masques de segmentation d'instance plus détaillés pour chaque objet.

- Utilise des métriques d'évaluation standardisées telles que la précision moyenne (mAP) pour la détection d'objets et le rappel moyen (mAR) pour les tâches de segmentation d'instances.

Quels modèles pré-entraînés sont disponibles pour COCO-Seg, et quelles sont leurs mesures de performance ?

Le jeu de données COCO-Seg prend en charge plusieurs modèles de segmentation YOLO26 pré-entraînés avec des métriques de performance variées. Voici un résumé des modèles disponibles et de leurs métriques clés :

| Modèle | Taille (pixels) | mAPbox 50-95(e2e) | mAPmasque 50-95(e2e) | Vitesse CPU ONNX (ms) | Vitesse T4 TensorRT10 (ms) | paramètres (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Ces modèles vont du léger YOLO26n-seg au plus puissant YOLO26x-seg, offrant différents compromis entre vitesse et précision pour répondre à diverses exigences d'application. Pour plus d'informations sur la sélection des modèles, visitez la page des modèles Ultralytics.

Comment l'ensemble de données COCO-Seg est-il structuré et quels sous-ensembles contient-il ?

L'ensemble de données COCO-Seg est divisé en trois sous-ensembles pour des besoins spécifiques de formation et d'évaluation :

- Train2017 : Contient 118 000 images principalement utilisées pour entraîner des modèles de segmentation d'instance.

- Val2017 : Comprend 5 000 images utilisées pour la validation pendant le processus d'entraînement.

- Test2017 : Comprend 20 000 images réservées aux tests et à l’évaluation comparative des modèles entraînés. Notez que les annotations de vérité terrain pour ce sous-ensemble ne sont pas accessibles au public, et les résultats de performance sont soumis au serveur d’évaluation COCO pour évaluation.

Pour les besoins d'expérimentation plus modestes, vous pouvez également envisager d'utiliser l'ensemble de données COCO8-seg, qui est une version compacte contenant seulement 8 images de l'ensemble COCO train 2017.