Best practice per il Deployment del Modello

Introduzione

Il deployment del modello è la fase di un progetto di computer vision che porta un modello dalla fase di sviluppo a un'applicazione nel mondo reale. Esistono diverse opzioni di deployment del modello: il deployment su cloud offre scalabilità e facilità di accesso, il deployment edge riduce la latenza avvicinando il modello all'origine dati e il deployment locale garantisce privacy e controllo. La scelta della strategia giusta dipende dalle esigenze della tua applicazione, bilanciando velocità, sicurezza e scalabilità.

Guarda: Come ottimizzare e distribuire modelli di intelligenza artificiale: best practice, risoluzione dei problemi e considerazioni sulla sicurezza

È inoltre importante seguire le migliori pratiche quando si distribuisce un modello, poiché la distribuzione può influire in modo significativo sull'efficacia e l'affidabilità delle prestazioni del modello. In questa guida, ci concentreremo su come assicurarci che la distribuzione del tuo modello sia fluida, efficiente e sicura.

Opzioni di deployment del modello

Spesso, una volta che un modello è stato addestrato, valutato e testato, deve essere convertito in formati specifici per essere implementato efficacemente in vari ambienti, come cloud, edge o dispositivi locali.

Con YOLO26, puoi esportare il tuo modello in vari formati a seconda delle tue esigenze di deployment. Ad esempio, esportare YOLO26 in ONNX è semplice e ideale per trasferire modelli tra framework. Per esplorare ulteriori opzioni di integrazione e garantire un deployment fluido tra diversi ambienti, visita il nostro hub di integrazione dei modelli.

Scelta di un ambiente di distribuzione

La scelta di dove distribuire il tuo modello di computer vision dipende da diversi fattori. Ambienti diversi presentano vantaggi e sfide uniche, quindi è essenziale scegliere quello più adatto alle tue esigenze.

Distribuzione su Cloud

La distribuzione su cloud è ideale per applicazioni che necessitano di scalare rapidamente e gestire grandi quantità di dati. Piattaforme come AWS, Google Cloud e Azure semplificano la gestione dei tuoi modelli dalla fase di training alla distribuzione. Offrono servizi come AWS SageMaker, Google AI Platform e Azure Machine Learning per supportarti durante l'intero processo.

Tuttavia, l'utilizzo del cloud può essere costoso, soprattutto con un elevato utilizzo di dati, e potresti riscontrare problemi di latenza se i tuoi utenti sono lontani dai data center. Per gestire i costi e le prestazioni, è importante ottimizzare l'uso delle risorse e garantire la conformità alle norme sulla privacy dei dati.

Distribuzione Edge

La distribuzione edge è ideale per le applicazioni che richiedono risposte in tempo reale e bassa latenza, soprattutto in luoghi con accesso a Internet limitato o assente. La distribuzione di modelli su dispositivi edge come smartphone o gadget IoT garantisce un'elaborazione rapida e mantiene i dati in locale, migliorando la privacy. La distribuzione su edge consente anche di risparmiare larghezza di banda grazie alla riduzione dei dati inviati al cloud.

Tuttavia, i dispositivi edge hanno spesso una potenza di elaborazione limitata, quindi dovrai ottimizzare i tuoi modelli. Strumenti come TensorFlow Lite e NVIDIA Jetson possono essere d'aiuto. Nonostante i vantaggi, la manutenzione e l'aggiornamento di molti dispositivi possono essere impegnativi.

Distribuzione locale

La distribuzione locale è la soluzione migliore quando la privacy dei dati è fondamentale o quando l'accesso a Internet è inaffidabile o assente. L'esecuzione di modelli su server locali o desktop offre il pieno controllo e protegge i dati. Può anche ridurre la latenza se il server è vicino all'utente.

Tuttavia, il ridimensionamento locale può essere difficile e la manutenzione può richiedere molto tempo. L'utilizzo di strumenti come Docker per la containerizzazione e Kubernetes per la gestione può contribuire a rendere più efficienti le implementazioni locali. Sono necessari aggiornamenti e manutenzione regolari per mantenere tutto in funzione senza problemi.

Containerizzazione per una distribuzione semplificata

La containerizzazione è un approccio efficace che impacchetta il tuo modello e tutte le sue dipendenze in un'unità standardizzata chiamata container. Questa tecnica garantisce prestazioni coerenti in diversi ambienti e semplifica il processo di distribuzione.

Vantaggi dell'Utilizzo di Docker per il Deployment di Modelli

Docker è diventato lo standard industriale per la containerizzazione nelle implementazioni di machine learning per diversi motivi:

- Coerenza dell'ambiente: I container Docker incapsulano il tuo modello e tutte le sue dipendenze, eliminando il problema del "funziona sulla mia macchina" garantendo un comportamento coerente tra gli ambienti di sviluppo, test e produzione.

- Isolamento: I container isolano le applicazioni l'una dall'altra, prevenendo conflitti tra diverse versioni di software o librerie.

- Portabilità: I container Docker possono essere eseguiti su qualsiasi sistema che supporti Docker, semplificando l'implementazione dei modelli su diverse piattaforme senza modifiche.

- Scalabilità: I container possono essere facilmente scalati in base alla domanda e gli strumenti di orchestrazione come Kubernetes possono automatizzare questo processo.

- Controllo della versione: Le immagini Docker possono essere versionate, consentendo di tenere traccia delle modifiche e di ripristinare le versioni precedenti, se necessario.

Implementazione di Docker per il Deployment di YOLO26

Per containerizzare il tuo modello YOLO26, puoi creare un Dockerfile che specifichi tutte le dipendenze e le configurazioni necessarie. Ecco un esempio di base:

FROM ultralytics/ultralytics:latest

WORKDIR /app

# Copy your model and any additional files

COPY ./models/yolo26.pt /app/models/

COPY ./scripts /app/scripts/

# Set up any environment variables

ENV MODEL_PATH=/app/models/yolo26.pt

# Command to run when the container starts

CMD ["python", "/app/scripts/predict.py"]

Questo approccio garantisce che il deployment del modello sia riproducibile e coerente in diversi ambienti, riducendo significativamente il problema del "funziona sulla mia macchina" che spesso affligge i processi di deployment.

Tecniche di ottimizzazione del modello

L'ottimizzazione del tuo modello di computer vision aiuta a farlo funzionare in modo efficiente, specialmente quando viene implementato in ambienti con risorse limitate come i dispositivi edge. Ecco alcune tecniche chiave per ottimizzare il tuo modello.

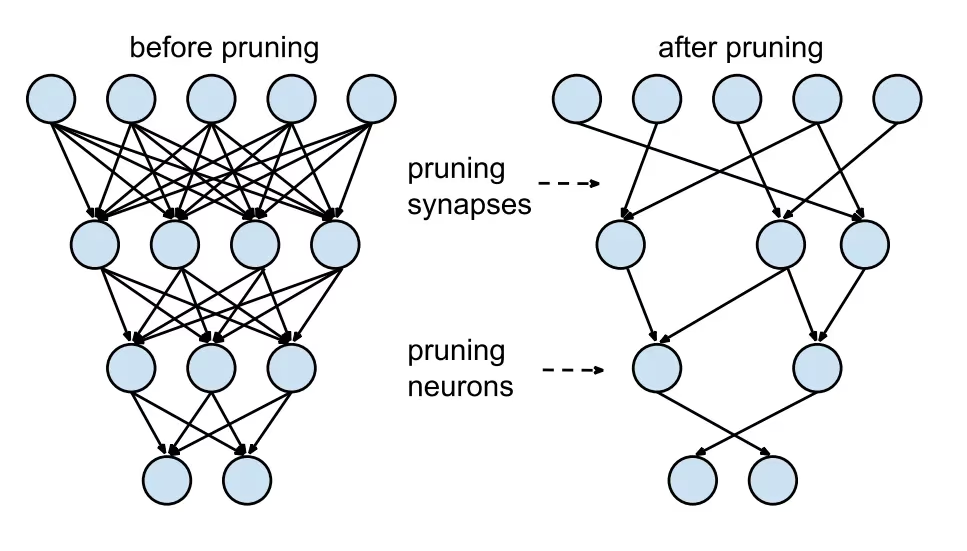

Potatura del modello

La potatura riduce le dimensioni del modello rimuovendo i pesi che contribuiscono poco all'output finale. Rende il modello più piccolo e veloce senza influire significativamente sulla precisione. La potatura comporta l'identificazione e l'eliminazione dei parametri non necessari, risultando in un modello più leggero che richiede meno potenza di calcolo. È particolarmente utile per la distribuzione di modelli su dispositivi con risorse limitate.

Quantizzazione del modello

La quantizzazione converte i pesi e le attivazioni del modello da alta precisione (come i float a 32 bit) a precisione inferiore (come gli interi a 8 bit). Riducendo le dimensioni del modello, si velocizza l'inferenza. L'addestramento con riconoscimento della quantizzazione (QAT) è un metodo in cui il modello viene addestrato tenendo presente la quantizzazione, preservando l'accuratezza meglio della quantizzazione post-addestramento. Gestendo la quantizzazione durante la fase di addestramento, il modello impara ad adattarsi a una precisione inferiore, mantenendo le prestazioni e riducendo al contempo le esigenze computazionali.

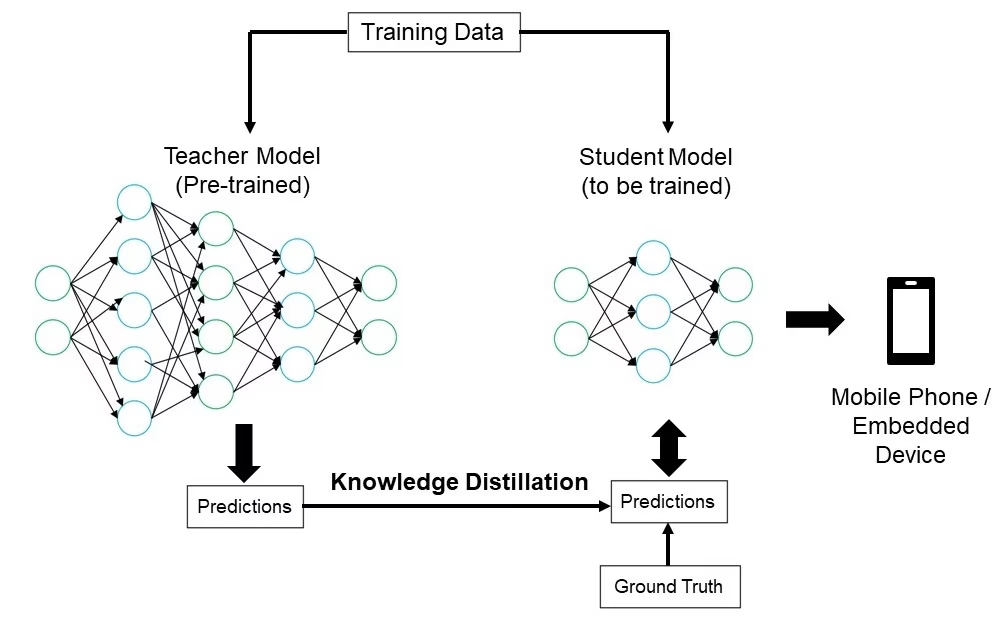

Knowledge Distillation (Distillazione della conoscenza)

La distillazione della conoscenza prevede l'addestramento di un modello più piccolo e semplice (lo studente) per imitare gli output di un modello più grande e complesso (l'insegnante). Il modello studente impara ad approssimare le previsioni dell'insegnante, risultando in un modello compatto che conserva gran parte dell'accuratezza dell'insegnante. Questa tecnica è utile per creare modelli efficienti adatti all'implementazione su dispositivi edge con risorse limitate.

Risoluzione dei problemi di implementazione

Potresti incontrare delle difficoltà durante la distribuzione dei tuoi modelli di computer vision, ma la comprensione dei problemi comuni e delle relative soluzioni può semplificare il processo. Ecco alcuni suggerimenti generali per la risoluzione dei problemi e le best practice per aiutarti a superare i problemi di distribuzione.

Il tuo modello è meno preciso dopo la distribuzione

Sperimentare un calo di accuratezza del modello dopo la distribuzione può essere frustrante. Questo problema può derivare da vari fattori. Ecco alcuni passaggi per aiutarti a identificare e risolvere il problema:

- Verifica la coerenza dei dati: Verifica che i dati elaborati dal tuo modello dopo la distribuzione siano coerenti con i dati su cui è stato addestrato. Differenze nella distribuzione, nella qualità o nel formato dei dati possono influire significativamente sulle prestazioni.

- Convalida dei passaggi di pre-elaborazione: Verifica che tutti i passaggi di pre-elaborazione applicati durante l'addestramento vengano applicati in modo coerente anche durante l'implementazione. Ciò include il ridimensionamento delle immagini, la normalizzazione dei valori dei pixel e altre trasformazioni dei dati.

- Valutare l'ambiente del modello: Assicurarsi che le configurazioni hardware e software utilizzate durante la distribuzione corrispondano a quelle utilizzate durante l'addestramento. Differenze nelle librerie, nelle versioni e nelle capacità hardware possono introdurre discrepanze.

- Monitorare l'inferenza del modello: Registra input e output in varie fasi della pipeline di inferenza per rilevare eventuali anomalie. Può aiutare a identificare problemi come la corruzione dei dati o la gestione impropria degli output del modello.

- Rivedi l'esportazione e la conversione del modello: Riesporta il modello e assicurati che il processo di conversione mantenga l'integrità dei pesi e dell'architettura del modello.

- Test con un set di dati controllato: Distribuisci il modello in un ambiente di test con un set di dati che controlli e confronta i risultati con la fase di addestramento. Puoi identificare se il problema riguarda l'ambiente di distribuzione o i dati.

Quando si effettua il deployment di YOLO26, diversi fattori possono influenzare l'accuratezza del modello. La conversione dei modelli in formati come TensorRT implica ottimizzazioni come la quantizzazione dei pesi e la fusione dei layer, che possono causare lievi perdite di precisione. L'uso di FP16 (precisione dimezzata) invece di FP32 (precisione completa) può accelerare l'inferenza ma potrebbe introdurre errori di precisione numerica. Inoltre, i vincoli hardware, come quelli sul Jetson Nano, con un numero inferiore di core CUDA e una larghezza di banda di memoria ridotta, possono influire sulle prestazioni.

Le inferenze richiedono più tempo del previsto

Quando si distribuiscono modelli di machine learning, è importante che funzionino in modo efficiente. Se le inferenze richiedono più tempo del previsto, ciò può influire sull'esperienza dell'utente e sull'efficacia dell'applicazione. Ecco alcuni passaggi per aiutarti a identificare e risolvere il problema:

- Implementa esecuzioni di warm-up: le esecuzioni iniziali spesso includono l'overhead di configurazione, che può distorcere le misurazioni della latenza. Esegui alcune inferenze di warm-up prima di misurare la latenza. L'esclusione di queste esecuzioni iniziali fornisce una misurazione più accurata delle prestazioni del modello.

- Ottimizza l'Inference Engine: Verifica che l'inference engine sia completamente ottimizzato per l'architettura GPU specifica. Utilizza i driver e le versioni software più recenti, progettati su misura per il tuo hardware, per garantire massime prestazioni e compatibilità.

- Usa l'elaborazione asincrona: L'elaborazione asincrona può aiutare a gestire i carichi di lavoro in modo più efficiente. Utilizza tecniche di elaborazione asincrona per gestire più inferenze contemporaneamente, il che può aiutare a distribuire il carico e ridurre i tempi di attesa.

- Profilare la pipeline di inferenza: Identificare i colli di bottiglia nella pipeline di inferenza può aiutare a individuare l'origine dei ritardi. Utilizzare strumenti di profilazione per analizzare ogni fase del processo di inferenza, identificando e risolvendo eventuali fasi che causano ritardi significativi, come livelli inefficienti o problemi di trasferimento dati.

- Usa una precisione appropriata: L'utilizzo di una precisione superiore al necessario può rallentare i tempi di inferenza. Sperimenta l'utilizzo di una precisione inferiore, come FP16 (mezza precisione), invece di FP32 (precisione completa). Sebbene FP16 possa ridurre il tempo di inferenza, tieni presente che può influire sulla precisione del modello.

Se stai affrontando questo problema durante il deployment di YOLO26, considera che YOLO26 offre diverse dimensioni di modello, come YOLO26n (nano) per dispositivi con minore capacità di memoria e YOLO26x (extra-large) per GPU più potenti. Scegliere la variante di modello giusta per il tuo hardware può aiutare a bilanciare l'utilizzo della memoria e il tempo di elaborazione.

Inoltre, tieni presente che le dimensioni delle immagini di input influiscono direttamente sull'utilizzo della memoria e sui tempi di elaborazione. Risoluzioni inferiori riducono l'utilizzo della memoria e velocizzano l'inferenza, mentre risoluzioni superiori migliorano la precisione ma richiedono più memoria e potenza di elaborazione.

Considerazioni sulla sicurezza nell'implementazione del modello

Un altro aspetto importante del deployment è la sicurezza. La sicurezza dei modelli distribuiti è fondamentale per proteggere i dati sensibili e la proprietà intellettuale. Ecco alcune best practice che puoi seguire relative al deployment sicuro dei modelli.

Trasmissione sicura dei dati

Assicurarsi che i dati inviati tra client e server siano sicuri è molto importante per evitare che vengano intercettati o accessibili a terzi non autorizzati. È possibile utilizzare protocolli di crittografia come TLS (Transport Layer Security) per crittografare i dati durante la trasmissione. Anche se qualcuno intercetta i dati, non sarà in grado di leggerli. Puoi anche utilizzare la crittografia end-to-end che protegge i dati dalla sorgente alla destinazione, in modo che nessuno nel mezzo possa accedervi.

Controlli di accesso

È essenziale controllare chi può accedere al tuo modello e ai suoi dati per prevenire usi non autorizzati. Utilizza metodi di autenticazione forti per verificare l'identità degli utenti o dei sistemi che tentano di accedere al modello e valuta la possibilità di aggiungere ulteriore sicurezza con l'autenticazione a più fattori (MFA). Imposta il controllo degli accessi basato sui ruoli (RBAC) per assegnare le autorizzazioni in base ai ruoli degli utenti, in modo che le persone abbiano accesso solo a ciò di cui hanno bisogno. Conserva registri di controllo dettagliati per monitorare tutti gli accessi e le modifiche al modello e ai suoi dati e rivedi regolarmente questi registri per individuare eventuali attività sospette.

Offuscamento del modello

Proteggere il tuo modello dal reverse engineering o dall'uso improprio può essere fatto attraverso l'offuscamento del modello. Ciò comporta la crittografia dei parametri del modello, come pesi e bias nelle reti neurali, per rendere difficile a persone non autorizzate comprendere o alterare il modello. Puoi anche offuscare l'architettura del modello rinominando livelli e parametri o aggiungendo livelli fittizi, rendendo più difficile per gli aggressori effettuare il reverse engineering. Puoi anche servire il modello in un ambiente sicuro, come un enclave sicuro o utilizzando un ambiente di esecuzione affidabile (TEE), in grado di fornire un ulteriore livello di protezione durante l'inferenza.

Condividi idee con i tuoi colleghi

Far parte di una comunità di appassionati di computer vision può aiutarti a risolvere i problemi e imparare più velocemente. Ecco alcuni modi per connettersi, ottenere aiuto e condividere idee.

Risorse della community

- GitHub Issues: Esplora il repository GitHub di YOLO26 e usa la scheda Issues per porre domande, segnalare bug e suggerire nuove funzionalità. La community e i manutentori sono molto attivi e pronti ad aiutare.

- Server Discord di Ultralytics: Unisciti al server Discord di Ultralytics per chattare con altri utenti e sviluppatori, ottenere supporto e condividere le tue esperienze.

Documentazione ufficiale

- Documentazione Ultralytics YOLO26: Visita la documentazione ufficiale di YOLO26 per guide dettagliate e consigli utili su vari progetti di visione artificiale.

L'utilizzo di queste risorse ti aiuterà a risolvere le sfide e a rimanere aggiornato con le ultime tendenze e pratiche nella comunità della computer vision.

Conclusioni e prossimi passi

Abbiamo esaminato alcune best practice da seguire quando si distribuiscono modelli di computer vision. Proteggendo i dati, controllando l'accesso e offuscando i dettagli del modello, è possibile proteggere le informazioni sensibili mantenendo i modelli in esecuzione senza problemi. Abbiamo anche discusso come affrontare problemi comuni come la riduzione dell'accuratezza e le inferenze lente utilizzando strategie come le esecuzioni di warm-up, l'ottimizzazione dei motori, l'elaborazione asincrona, la profilazione delle pipeline e la scelta della precisione giusta.

Dopo aver distribuito il modello, il passo successivo consiste nel monitoraggio, nella manutenzione e nella documentazione dell'applicazione. Un monitoraggio regolare aiuta a individuare e risolvere rapidamente i problemi, la manutenzione mantiene i modelli aggiornati e funzionali e una buona documentazione tiene traccia di tutte le modifiche e gli aggiornamenti. Questi passaggi ti aiuteranno a raggiungere gli obiettivi del tuo progetto di computer vision.

FAQ

Quali sono le best practice per il deployment di un modello di machine learning utilizzando Ultralytics YOLO26?

Il deployment di un modello di machine learning, in particolare con Ultralytics YOLO26, implica diverse best practice per garantirne efficienza e affidabilità. Innanzitutto, scegli l'ambiente di deployment più adatto alle tue esigenze: cloud, edge o locale. Ottimizza il tuo modello tramite tecniche come pruning, quantizzazione e knowledge distillation per un deployment efficiente in ambienti con risorse limitate. Considera l'uso della containerizzazione con Docker per garantire la coerenza tra i diversi ambienti. Infine, assicurati che la coerenza dei dati e i passaggi di pre-elaborazione siano allineati con la fase di training per mantenere le prestazioni. Puoi anche fare riferimento alle opzioni di deployment del modello per linee guida più dettagliate.

Come posso risolvere i problemi comuni di deployment con i modelli Ultralytics YOLO26?

La risoluzione dei problemi di implementazione può essere suddivisa in alcuni passaggi chiave. Se la precisione del modello diminuisce dopo l'implementazione, verificare la coerenza dei dati, convalidare i passaggi di preelaborazione e assicurarsi che l'ambiente hardware/software corrisponda a quello utilizzato durante l'addestramento. Per tempi di inferenza lenti, eseguire warm-up run, ottimizzare il motore di inferenza, utilizzare l'elaborazione asincrona e profilare la pipeline di inferenza. Consultare la sezione risoluzione dei problemi di implementazione per una guida dettagliata su queste best practice.

In che modo l'ottimizzazione di Ultralytics YOLO26 migliora le prestazioni del modello sui dispositivi edge?

L'ottimizzazione dei modelli Ultralytics YOLO26 per dispositivi edge implica l'uso di tecniche come il pruning per ridurre la dimensione del modello, la quantizzazione per convertire i pesi a una precisione inferiore e la knowledge distillation per addestrare modelli più piccoli che imitano quelli più grandi. Queste tecniche garantiscono che il modello funzioni in modo efficiente su dispositivi con potenza di calcolo limitata. Strumenti come TensorFlow Lite e NVIDIA Jetson sono particolarmente utili per queste ottimizzazioni. Scopri di più su queste tecniche nella nostra sezione sull'ottimizzazione del modello.

Quali sono le considerazioni sulla sicurezza per il deployment di modelli di machine learning con Ultralytics YOLO26?

La sicurezza è fondamentale quando si distribuiscono modelli di machine learning. Garantire una trasmissione sicura dei dati utilizzando protocolli di crittografia come TLS. Implementare controlli di accesso robusti, inclusa l'autenticazione forte e il controllo degli accessi basato sui ruoli (RBAC). Le tecniche di offuscamento del modello, come la crittografia dei parametri del modello e la fornitura di modelli in un ambiente sicuro come un ambiente di esecuzione affidabile (TEE), offrono una protezione aggiuntiva. Per pratiche dettagliate, fare riferimento alle considerazioni sulla sicurezza.

Come scelgo l'ambiente di deployment giusto per il mio modello Ultralytics YOLO26?

La scelta dell'ambiente di deployment ottimale per il tuo modello Ultralytics YOLO26 dipende dalle esigenze specifiche della tua applicazione. Il deployment su cloud offre scalabilità e facilità di accesso, rendendolo ideale per applicazioni con grandi volumi di dati. Il deployment edge è la soluzione migliore per applicazioni a bassa latenza che richiedono risposte in tempo reale, utilizzando strumenti come TensorFlow Lite. Il deployment locale è adatto a scenari che richiedono rigorosa privacy e controllo dei dati. Per una panoramica completa di ciascun ambiente, consulta la nostra sezione sulla scelta di un ambiente di deployment.