クイックスタートガイド:Raspberry PiとUltralytics YOLO26

この包括的なガイドでは、Raspberry PiデバイスにUltralytics YOLO26をデプロイするための詳細な手順を説明します。さらに、これらの小型で強力なデバイス上でのYOLO26の能力を示すパフォーマンスベンチマークも紹介しています。

見る: Raspberry Pi 5のアップデートと改善点。

注

このガイドは、最新のRaspberry Pi OS Bookworm (Debian 12)を実行している Raspberry Pi 4 および Raspberry Pi 5 でテストされています。同じ Raspberry Pi OS Bookworm がインストールされていれば、Raspberry Pi 3 などの古い Raspberry Pi デバイスでもこのガイドを使用できるはずです。

Raspberry Piとは何ですか?

Raspberry Piは、小型で手頃な価格のシングルボードコンピュータです。趣味のホームオートメーションから産業用途まで、幅広いプロジェクトやアプリケーションで普及しています。Raspberry Piボードは、さまざまなオペレーティングシステムを実行でき、センサー、アクチュエータ、その他のハードウェアコンポーネントとの容易な統合を可能にするGPIO(汎用入出力)ピンを提供します。仕様が異なるさまざまなモデルがありますが、すべて低コスト、コンパクト、汎用性があるという基本的な設計思想を共有しています。

Raspberry Piシリーズ比較

| Raspberry Pi 3 | Raspberry Pi 4 | Raspberry Pi 5 | |

|---|---|---|---|

| CPU | Broadcom BCM2837, Cortex-A53 64Bit SoC | Broadcom BCM2711、Cortex-A72 64Bit SoC | Broadcom BCM2712, Cortex-A76 64Bit SoC |

| CPU 最大周波数 | 1.4GHz | 1.8GHz | 2.4GHz |

| GPU | Videocore IV | Videocore VI | VideoCore VII |

| GPU 最大周波数 | 400MHz | 500MHz | 800Mhz |

| メモリ | 1GB LPDDR2 SDRAM | 1GB、2GB、4GB、8GB LPDDR4-3200 SDRAM | 4GB、8GB LPDDR4X-4267 SDRAM |

| PCIe | N/A | N/A | 1xPCIe 2.0インターフェース |

| 最大消費電力 | 2.5A@5V | 3A@5V | 5A@5V (PD対応) |

Raspberry Pi OSとは何ですか?

Raspberry Pi OS(以前はRaspbianとして知られていました)は、Raspberry Pi Foundationによって配布されているRaspberry Piファミリーのコンパクトなシングルボードコンピュータ用のDebian GNU/Linuxディストリビューションに基づくUnixライクなオペレーティングシステムです。Raspberry Pi OSは、ARM CPUを搭載したRaspberry Pi向けに高度に最適化されており、Openboxスタッキングウィンドウマネージャーを備えた変更されたLXDEデスクトップ環境を使用しています。Raspberry Pi OSは活発に開発されており、Raspberry Piで可能な限り多くのDebianパッケージの安定性とパフォーマンスを向上させることに重点を置いています。

Raspberry PiへのRaspberry Pi OSのフラッシュ

Raspberry Piを入手した後に最初にすべきことは、Raspberry Pi OSをmicro-SDカードに書き込み、デバイスに挿入してOSを起動することです。詳細なRaspberry Piによる入門ドキュメントに従って、デバイスを初めて使用する準備をしてください。

Ultralyticsのセットアップ

UltralyticsパッケージをRaspberry Piにセットアップして、次世代のコンピュータービジョンプロジェクトを構築する方法は2つあります。どちらの方法でも可能です。

Dockerから開始

Raspberry PiでUltralytics YOLO26を始める最も速い方法は、Raspberry Pi用の事前構築済みDockerイメージを実行することです。

下記のコマンドを実行して、Dockerコンテナをpullし、Raspberry Pi上で実行してください。これは、Python 3環境にDebian 12(Bookworm)を含むarm64v8/debian Dockerイメージに基づいています。

t=ultralytics/ultralytics:latest-arm64

sudo docker pull $t && sudo docker run -it --ipc=host $t

完了したら、Raspberry PiでNCNNを使用するセクションに進んでください。

Dockerなしで開始

Ultralyticsパッケージのインストール

ここでは、PyTorchモデルを他のさまざまな形式でエクスポートできるように、オプションの依存関係とともにUltralyticsパッケージをRaspberry Piにインストールします。

パッケージリストの更新、pipのインストール、および最新バージョンへのアップグレード

sudo apt update sudo apt install python3-pip -y pip install -U pipインストール

ultralyticsオプションの依存関係を含む pip パッケージpip install ultralytics[export]デバイスを再起動

sudo reboot

Raspberry Piで NCNN を使用する

Ultralyticsがサポートするすべてのモデルエクスポート形式の中で、NCNNは、Raspberry Piデバイスで作業する場合に最高の推論パフォーマンスを提供します。これは、NCNNがモバイル/組み込みプラットフォーム(ARMアーキテクチャなど)向けに高度に最適化されているためです。

モデルをNCNNに変換して推論を実行

PyTorch形式のYOLO26nモデルは、エクスポートされたモデルで推論を実行するためにNCNNに変換されます。

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to NCNN format

model.export(format="ncnn") # creates 'yolo26n_ncnn_model'

# Load the exported NCNN model

ncnn_model = YOLO("yolo26n_ncnn_model")

# Run inference

results = ncnn_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to NCNN format

yolo export model=yolo26n.pt format=ncnn # creates 'yolo26n_ncnn_model'

# Run inference with the exported model

yolo predict model='yolo26n_ncnn_model' source='https://ultralytics.com/images/bus.jpg'

ヒント

サポートされているエクスポートオプションの詳細については、Ultralyticsのデプロイメントオプションに関するドキュメントページをご覧ください。

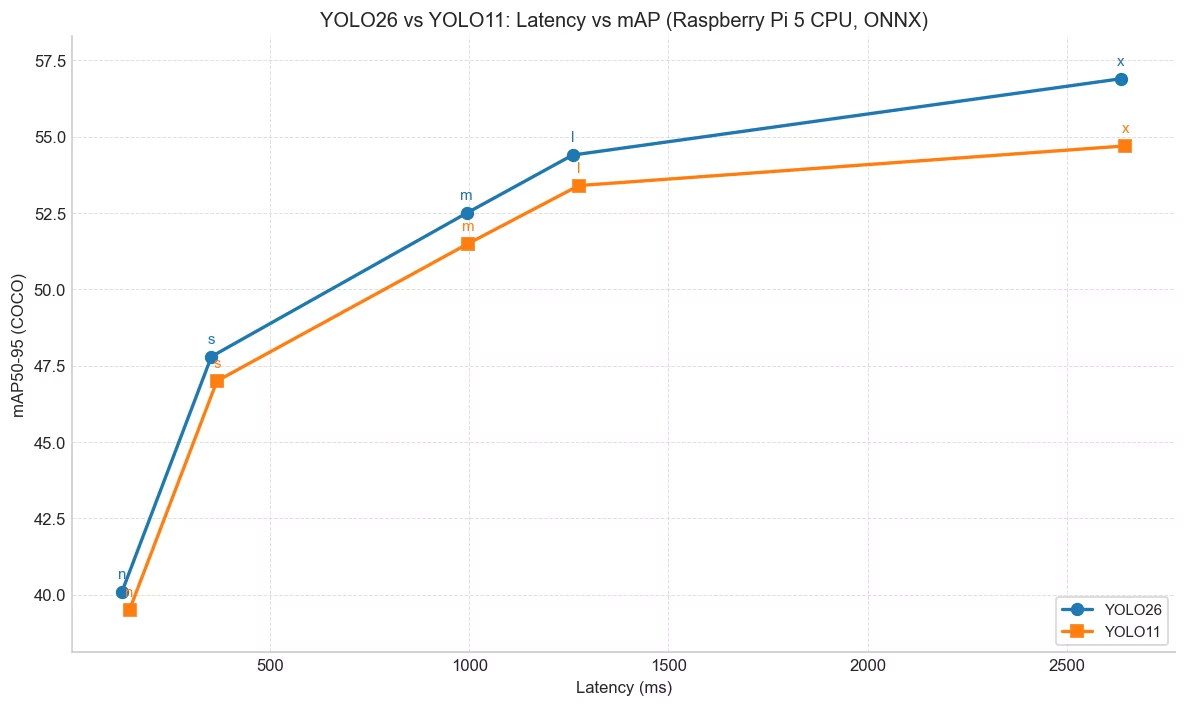

YOLO26のYOLO11に対する性能向上

YOLO26は、Raspberry Pi 5などのハードウェア制約のあるデバイスで動作するよう特別に設計されています。 Raspberry Pi 5上でONNXを使用した場合、入力サイズ640ピクセルにおいて、YOLO26nはYOLO11nと比較してFPSが約15%向上(6.79 → 7.79)し、同時にmAP 向上mAP 40.1 vs 39.5)しています。下記の表とグラフはこの比較を示しています。

パフォーマンス

| モデル | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|

| YOLO26n | 40.1 | 128.42 |

| YOLO26s | 47.8 | 352.84 |

| YOLO26m | 52.5 | 993.78 |

| YOLO26l | 54.4 | 1259.46 |

| YOLO26x | 56.9 | 2636.26 |

| モデル | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|

| YOLO11n | 39.5 | 147.20 |

| YOLO11s | 47.0 | 366.83 |

| YOLO11m | 51.5 | 997.46 |

| YOLO11l | 53.4 | 1274.95 |

| YOLO11x | 54.7 | 2646.76 |

Ultralytics .4.14 を用いてベンチマークを実施しました。

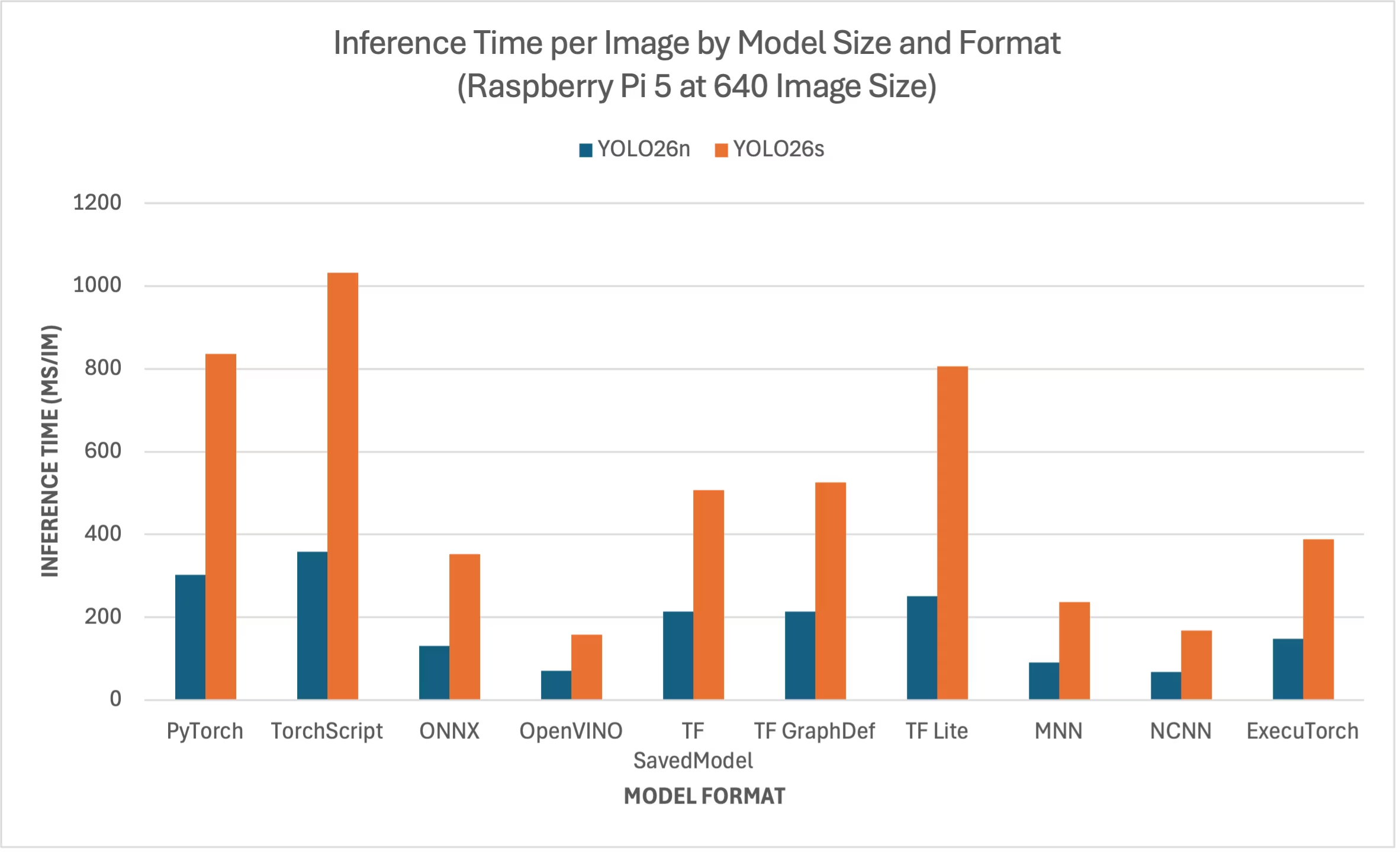

ラズベリーパイ5 YOLO26 ベンチマーク

Ultralytics は、速度と精度を測定するため、10種類の異なるモデル形式(PyTorch、TorchScript、ONNX、OpenVINO、TF SavedModel、TF GraphDef、TF 、MNN、NCNN、ExecuTorch)でYOLO26ベンチマークを実行しました。ベンチマークはRaspberry Pi 5上でFP32精度、デフォルト入力画像サイズ640ピクセルで実行されました。

比較チャート

YOLO26nおよびYOLO26sモデルのベンチマークのみを掲載しました。他のモデルサイズはラズベリーパイ上で実行するには大きすぎ、十分な性能を発揮しないためです。

詳細な比較表

以下の表は、2つの異なるモデル (YOLO26n, YOLO26s) のベンチマーク結果を示しています。10種類の異なるフォーマット(PyTorch、TorchScript、ONNX、OpenVINO、TF SavedModel、TF GraphDef、TF 、MNN、NCNN、ExecuTorch)で、Raspberry Pi 5 上で実行した結果です。各組み合わせについて、ステータス、サイズ、mAP50(B) メトリクス、推論時間を示しています。

パフォーマンス

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.3 | 0.4798 | 302.15 |

| TorchScript | ✅ | 9.8 | 0.4764 | 357.58 |

| ONNX | ✅ | 9.5 | 0.4764 | 130.33 |

| OpenVINO | ✅ | 9.6 | 0.4818 | 70.74 |

| TF SavedModel | ✅ | 24.6 | 0.4764 | 213.58 |

| TF GraphDef | ✅ | 9.5 | 0.4764 | 213.5 |

| TF Lite | ✅ | 9.9 | 0.4764 | 251.41 |

| MNN | ✅ | 9.4 | 0.4784 | 90.89 |

| NCNN | ✅ | 9.4 | 0.4805 | 67.69 |

| ExecuTorch | ✅ | 9.4 | 0.4764 | 148.36 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 19.5 | 0.5740 | 836.54 |

| TorchScript | ✅ | 36.8 | 0.5665 | 1032.25 |

| ONNX | ✅ | 36.5 | 0.5665 | 351.96 |

| OpenVINO | ✅ | 36.7 | 0.5654 | 158.6 |

| TF SavedModel | ✅ | 92.2 | 0.5665 | 507.6 |

| TF GraphDef | ✅ | 36.5 | 0.5665 | 525.64 |

| TF Lite | ✅ | 36.9 | 0.5665 | 805.3 |

| MNN | ✅ | 36.4 | 0.5644 | 236.47 |

| NCNN | ✅ | 36.4 | 0.5697 | 168.47 |

| ExecuTorch | ✅ | 36.5 | 0.5665 | 388.72 |

Ultralytics .4.1 を用いてベンチマークを実施

注

推論時間には、プリ/ポスト処理は含まれていません。

結果の再現

上記のUltralyticsベンチマークをすべてのエクスポート形式で再現するには、次のコードを実行します:

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

なお、ベンチマーク結果は、システムの正確なハードウェアおよびソフトウェア構成、ならびにベンチマーク実行時のシステムの現在のワークロードによって異なる場合があります。最も信頼性の高い結果を得るには、多数の画像を含むデータセットを使用してください (例: )。 data='coco.yaml' (5000の検証画像)。

Raspberry Pi Cameraを使用する

コンピュータービジョンプロジェクトでRaspberry Piを使用する場合、リアルタイムのビデオフィードを取得して推論を実行することが不可欠です。Raspberry PiのオンボードMIPI CSIコネクタを使用すると、公式のRaspberry Piカメラモジュールを接続できます。このガイドでは、Raspberry Pi Camera Module 3を使用してビデオフィードを取得し、YOLO26モデルで推論を実行しました。

ヒント

Raspberry Piが提供するさまざまなカメラモジュール、およびRaspberry Piカメラモジュールの使用を開始する方法の詳細はこちら。

注

Raspberry Pi 5 は Raspberry Pi 4 よりも小型の CSI コネクタを使用しているため (15 ピン vs 22 ピン)、Raspberry Pi カメラに接続するには 15 ピン - 22 ピンのアダプタケーブル が必要になります。

カメラのテスト

カメラをRaspberry Piに接続した後、次のコマンドを実行します。カメラからのライブビデオフィードが約5秒間表示されるはずです。

rpicam-hello

ヒント

詳細についてはこちらをご覧ください rpicam-hello 公式のRaspberry Piドキュメントでの使用法

カメラを使用した推論

Raspberry Piカメラを使用してYOLO26モデルで推論を実行する方法は2つあります。

使用法

使用できます picamera2 これはRaspberry Pi OSにプリインストールされており、カメラにアクセスしてYOLO26モデルで推論を実行できます。

例

import cv2

from picamera2 import Picamera2

from ultralytics import YOLO

# Initialize the Picamera2

picam2 = Picamera2()

picam2.preview_configuration.main.size = (1280, 720)

picam2.preview_configuration.main.format = "RGB888"

picam2.preview_configuration.align()

picam2.configure("preview")

picam2.start()

# Load the YOLO26 model

model = YOLO("yolo26n.pt")

while True:

# Capture frame-by-frame

frame = picam2.capture_array()

# Run YOLO26 inference on the frame

results = model(frame)

# Visualize the results on the frame

annotated_frame = results[0].plot()

# Display the resulting frame

cv2.imshow("Camera", annotated_frame)

# Break the loop if 'q' is pressed

if cv2.waitKey(1) == ord("q"):

break

# Release resources and close windows

cv2.destroyAllWindows()

TCPストリームを確立する必要があります。 rpicam-vid 接続されたカメラから、推論時にこのストリームURLを入力として使用できるようにします。TCPストリームを開始するには、次のコマンドを実行します。

rpicam-vid -n -t 0 --inline --listen -o tcp://127.0.0.1:8888

詳細についてはこちらをご覧ください rpicam-vid 公式のRaspberry Piドキュメントでの使用法

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Run inference

results = model("tcp://127.0.0.1:8888")

yolo predict model=yolo26n.pt source="tcp://127.0.0.1:8888"

ヒント

画像/ビデオの入力タイプを変更する場合は、推論ソースに関するドキュメントをご覧ください。

Raspberry Pi 使用時のベストプラクティス

YOLO26を実行するRaspberry Piで最高のパフォーマンスを可能にするためには、いくつかのベストプラクティスに従う必要があります。

SSDを使用する

Raspberry Piを24時間365日継続して使用する場合は、SDカードが継続的な書き込みに耐えられず、破損する可能性があるため、システムにSSDを使用することをお勧めします。Raspberry Pi 5のオンボードPCIeコネクタを使用すると、NVMe Base for Raspberry Pi 5などのアダプターを使用してSSDを接続できるようになりました。

GUIなしでのフラッシュ

Raspberry Pi OSをフラッシュする際、デスクトップ環境(Raspberry Pi OS Lite)をインストールしないことを選択できます。これにより、デバイスのRAMを少し節約でき、コンピュータビジョン処理のためのスペースを増やすことができます。

Raspberry Piのオーバークロック

Raspberry Pi 5でUltralytics YOLO26モデルを実行する際にパフォーマンスを少し向上させたい場合は、CPUをベースの2.4GHzから2.9GHzに、GPUを800MHzから1GHzにオーバークロックできます。システムが不安定になったりクラッシュしたりする場合は、オーバークロック値を100MHzずつ減らしてください。オーバークロックは発熱を増加させ、サーマルスロットリングにつながる可能性があるため、適切な冷却が施されていることを確認してください。

a. ソフトウェアをアップグレードする

sudo apt update && sudo apt dist-upgradeb. 構成ファイルを編集するために開きます

sudo nano /boot/firmware/config.txtc. 以下の行を末尾に追加します

arm_freq=3000 gpu_freq=1000 force_turbo=1d. CTRL + X、次にYを押して保存して終了し、ENTERを押します

e. Raspberry Piを再起動します

次のステップ

Raspberry PiにYOLOを正常にセットアップしました。さらなる学習とサポートについては、Ultralytics YOLO26 DocsとKashmir World Foundationをご覧ください。

謝辞と引用

このガイドは当初、絶滅危惧種の保護に YOLO を活用することに尽力している Kashmir World Foundation の Daan Eeltink によって作成されました。オブジェクト検出技術の分野における彼らの先駆的な取り組みと教育的焦点に感謝いたします。

Kashmir World Foundation の活動に関する詳細については、彼らのウェブサイトをご覧ください。

よくある質問

Dockerを使用せずにRaspberry PiにUltralytics YOLO26をセットアップするにはどうすればよいですか?

DockerなしでRaspberry PiにUltralytics YOLO26をセットアップするには、以下の手順に従ってください。

- パッケージリストを更新してインストール

pip:sudo apt update sudo apt install python3-pip -y pip install -U pip - オプションの依存関係とともにUltralyticsパッケージをインストール:

pip install ultralytics[export] - 変更を適用するには、デバイスを再起動してください。

sudo reboot

詳細な手順については、Dockerなしで開始セクションを参照してください。

AIタスクでRaspberry PiにUltralytics YOLO26のNCNN形式を使用すべき理由は何ですか?

Ultralytics YOLO26のNCNN形式は、モバイルおよび組み込みプラットフォーム向けに高度に最適化されており、Raspberry PiデバイスでAIタスクを実行するのに理想的です。NCNNはARMアーキテクチャを活用することで推論パフォーマンスを最大化し、他の形式と比較してより高速で効率的な処理を提供します。サポートされているエクスポートオプションの詳細については、Ultralyticsのデプロイオプションに関するドキュメントページをご覧ください。

Raspberry Piで使用するためにYOLO26モデルをNCNN形式に変換するにはどうすればよいですか?

PyTorch YOLO26モデルをNCNN形式に変換するには、pythonまたはCLIコマンドを使用できます。

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to NCNN format

model.export(format="ncnn") # creates 'yolo26n_ncnn_model'

# Load the exported NCNN model

ncnn_model = YOLO("yolo26n_ncnn_model")

# Run inference

results = ncnn_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to NCNN format

yolo export model=yolo26n.pt format=ncnn # creates 'yolo26n_ncnn_model'

# Run inference with the exported model

yolo predict model='yolo26n_ncnn_model' source='https://ultralytics.com/images/bus.jpg'

詳細については、Raspberry Pi での NCNN の使用のセクションをご覧ください。

Raspberry Pi 4とRaspberry Pi 5の間で、YOLO26の実行に関連するハードウェアの違いは何ですか?

主な違いは以下の通りです。

- CPU: Raspberry Pi 4はBroadcom BCM2711、Cortex-A72 64-bit SoCを使用し、Raspberry Pi 5はBroadcom BCM2712、Cortex-A76 64-bit SoCを使用します。

- 最大CPU周波数: Raspberry Pi 4の最大周波数は1.8GHzですが、Raspberry Pi 5は2.4GHzに達します。

- メモリ: Raspberry Pi 4は最大8GBのLPDDR4-3200 SDRAMを提供し、Raspberry Pi 5は4GBおよび8GBのバリアントで利用可能なLPDDR4X-4267 SDRAMを備えています。

これらの機能強化により、Raspberry Pi 4と比較してRaspberry Pi 5でのYOLO26モデルのパフォーマンスベンチマークが向上します。詳細については、Raspberry Piシリーズ比較表を参照してください。

Ultralytics YOLO26で動作するようにRaspberry Piカメラモジュールを設定するにはどうすればよいですか?

YOLO26推論のためにRaspberry Piカメラを設定する方法は2つあります。

使用

picamera2:import cv2 from picamera2 import Picamera2 from ultralytics import YOLO picam2 = Picamera2() picam2.preview_configuration.main.size = (1280, 720) picam2.preview_configuration.main.format = "RGB888" picam2.preview_configuration.align() picam2.configure("preview") picam2.start() model = YOLO("yolo26n.pt") while True: frame = picam2.capture_array() results = model(frame) annotated_frame = results[0].plot() cv2.imshow("Camera", annotated_frame) if cv2.waitKey(1) == ord("q"): break cv2.destroyAllWindows()TCPストリームの使用:

rpicam-vid -n -t 0 --inline --listen -o tcp://127.0.0.1:8888from ultralytics import YOLO model = YOLO("yolo26n.pt") results = model("tcp://127.0.0.1:8888")

詳細なセットアップ手順については、カメラを使った推論セクションをご覧ください。