Insights sobre Avaliação e Ajuste Fino de Modelos

Introdução

Depois de treinar seu modelo de visão computacional, é essencial avaliá-lo e refiná-lo para que tenha um desempenho ideal. Apenas treinar seu modelo não é suficiente. Você precisa garantir que seu modelo seja preciso, eficiente e cumpra o objetivo do seu projeto de visão computacional. Ao avaliar e ajustar seu modelo, você pode identificar fraquezas, melhorar sua precisão e aumentar o desempenho geral.

Assista: Insights sobre Avaliação de Modelo e Ajuste Fino | Dicas para Melhorar a Precisão Média (Mean Average Precision)

Neste guia, partilhamos conhecimentos sobre avaliação e ajuste fino de modelos para tornar esta etapa de um projeto de visão computacional mais acessível. Discutimos como compreender as métricas de avaliação e implementar técnicas de ajuste fino, fornecendo-lhe o conhecimento para elevar as capacidades do seu modelo.

Avaliando o Desempenho do Modelo Usando Métricas

Avaliar o desempenho de um modelo nos ajuda a entender o quão eficazmente ele funciona. Várias métricas são usadas para medir o desempenho. Essas métricas de desempenho fornecem insights numéricos claros que podem orientar as melhorias para garantir que o modelo atenda aos seus objetivos pretendidos. Vamos dar uma olhada mais de perto em algumas métricas-chave.

Pontuação de Confiança

A pontuação de confiança representa a certeza do modelo de que um objeto detectado pertence a uma classe específica. Varia de 0 a 1, com pontuações mais altas indicando maior confiança. A pontuação de confiança ajuda a filtrar as previsões; apenas as detecções com pontuações de confiança acima de um limite especificado são consideradas válidas.

Dica rápida: Ao executar inferências, se você não estiver vendo nenhuma previsão e já tiver verificado todo o resto, tente diminuir a pontuação de confiança. Às vezes, o limite é muito alto, fazendo com que o modelo ignore previsões válidas. Diminuir a pontuação permite que o modelo considere mais possibilidades. Isso pode não atender aos objetivos do seu projeto, mas é uma boa maneira de ver o que o modelo pode fazer e decidir como ajustá-lo.

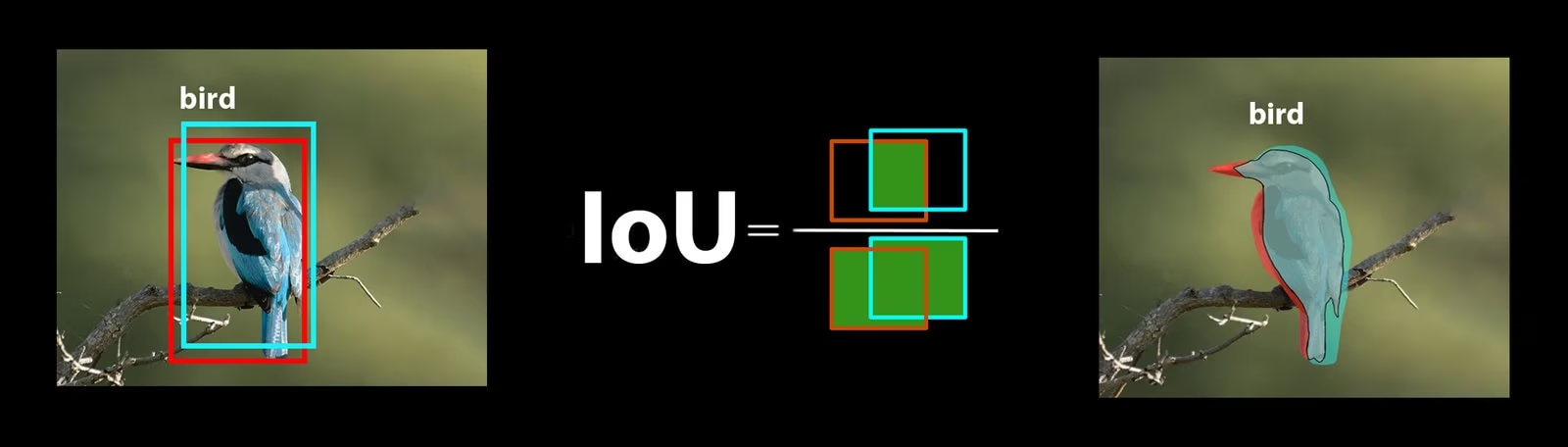

Intersecção sobre União

Intersecção sobre União (IoU) é uma métrica em detecção de objetos que mede o quão bem a bounding box prevista se sobrepõe à bounding box ground truth. Os valores de IoU variam de 0 a 1, onde um representa uma correspondência perfeita. O IoU é essencial porque mede o quão perto as fronteiras previstas correspondem às fronteiras reais do objeto.

Precisão Média Média

A Precisão Média Média (mAP) é uma forma de medir o desempenho de um modelo de detecção de objetos. Ela analisa a precisão da detecção de cada classe de objeto, calcula a média dessas pontuações e fornece um número geral que mostra a precisão com que o modelo pode identificar e classificar objetos.

Vamos focar em duas métricas mAP específicas:

- mAP@.5: Mede a precisão média num único limiar de IoU (Intersection over Union) de 0.5. Esta métrica verifica se o modelo consegue encontrar corretamente objetos com um requisito de precisão mais flexível. Concentra-se em saber se o objeto está aproximadamente no sítio certo, não necessitando de um posicionamento perfeito. Ajuda a perceber se o modelo é geralmente bom a identificar objetos.

- mAP@.5:.95: Calcula a média dos valores de mAP calculados em múltiplos limiares de IoU, de 0.5 a 0.95 em incrementos de 0.05. Esta métrica é mais detalhada e rigorosa. Fornece uma imagem mais completa de quão precisamente o modelo consegue encontrar objetos em diferentes níveis de rigor e é especialmente útil para aplicações que necessitam de uma detecção de objetos precisa.

Outras métricas de mAP incluem mAP@0.75, que usa um limite de IoU mais rigoroso de 0.75, e mAP@small, medium e large, que avaliam a precisão em objetos de diferentes tamanhos.

Avaliando o Desempenho do Modelo YOLO26

Em relação ao YOLO26, você pode usar o modo de validação para avaliar o modelo. Além disso, não deixe de consultar nosso guia que aborda em profundidade as métricas de desempenho do YOLO26 e como elas podem ser interpretadas.

Perguntas Comuns da Comunidade

Ao avaliar seu modelo YOLO26, você pode encontrar alguns obstáculos. Com base em perguntas comuns da comunidade, aqui estão algumas dicas para ajudá-lo a tirar o máximo proveito do seu modelo YOLO26:

Lidar com Tamanhos de Imagem Variáveis

Avaliar seu modelo YOLO26 com imagens de diferentes tamanhos pode ajudar a entender seu desempenho em diversos conjuntos de dados. Usando o rect=true parâmetro de validação, o YOLO26 ajusta o passo da rede para cada lote com base nos tamanhos das imagens, permitindo que o modelo lide com imagens retangulares sem forçá-las a um único tamanho.

O imgsz O parâmetro de validação define a dimensão máxima para redimensionamento de imagem, que é 640 por padrão. Você pode ajustar isso com base nas dimensões máximas do seu conjunto de dados e na memória da GPU disponível. Mesmo com imgsz definir, rect=true permite que o modelo gerencie tamanhos de imagem variáveis de forma eficaz, ajustando dinamicamente o stride.

Acessando Métricas do YOLO26

Se você deseja obter uma compreensão mais profunda do desempenho do seu modelo YOLO26, pode acessar facilmente métricas de avaliação específicas com algumas linhas de código Python. O trecho de código abaixo permitirá que você carregue seu modelo, execute uma avaliação e imprima várias métricas que mostram o quão bem seu modelo está se saindo.

Utilização

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Run the evaluation

results = model.val(data="coco8.yaml")

# Print specific metrics

print("Class indices with average precision:", results.ap_class_index)

print("Average precision for all classes:", results.box.all_ap)

print("Average precision:", results.box.ap)

print("Average precision at IoU=0.50:", results.box.ap50)

print("Class indices for average precision:", results.box.ap_class_index)

print("Class-specific results:", results.box.class_result)

print("F1 score:", results.box.f1)

print("F1 score curve:", results.box.f1_curve)

print("Overall fitness score:", results.box.fitness)

print("Mean average precision:", results.box.map)

print("Mean average precision at IoU=0.50:", results.box.map50)

print("Mean average precision at IoU=0.75:", results.box.map75)

print("Mean average precision for different IoU thresholds:", results.box.maps)

print("Mean results for different metrics:", results.box.mean_results)

print("Mean precision:", results.box.mp)

print("Mean recall:", results.box.mr)

print("Precision:", results.box.p)

print("Precision curve:", results.box.p_curve)

print("Precision values:", results.box.prec_values)

print("Specific precision metrics:", results.box.px)

print("Recall:", results.box.r)

print("Recall curve:", results.box.r_curve)

O objeto de resultados também inclui métricas de velocidade como tempo de pré-processamento, tempo de inferência, perda e tempo de pós-processamento. Ao analisar essas métricas, você pode ajustar e otimizar seu modelo YOLO26 para um melhor desempenho, tornando-o mais eficaz para seu caso de uso específico.

Como funciona o ajuste fino (Fine-Tuning)?

O ajuste fino envolve pegar um modelo pré-treinado e ajustar os seus parâmetros para melhorar o desempenho numa tarefa ou conjunto de dados específico. O processo, também conhecido como retreinamento de modelo, permite que o modelo compreenda e preveja melhor os resultados para os dados específicos que encontrará em aplicações do mundo real. Pode retreinar o seu modelo com base na avaliação do seu modelo para alcançar resultados ótimos.

Dicas para Ajustar Seu Modelo

Ajustar um modelo significa prestar muita atenção a vários parâmetros e técnicas vitais para alcançar o desempenho ideal. Aqui estão algumas dicas essenciais para guiá-lo durante o processo.

Começando Com uma Taxa de Aprendizagem Mais Alta

Normalmente, durante as épocas iniciais de treinamento, a taxa de aprendizado começa baixa e aumenta gradualmente para estabilizar o processo de treinamento. No entanto, como seu modelo já aprendeu alguns recursos do conjunto de dados anterior, começar com uma taxa de aprendizado mais alta imediatamente pode ser mais benéfico.

Ao avaliar seu modelo YOLO26, você pode definir o warmup_epochs parâmetro de validação para warmup_epochs=0 para evitar que a taxa de aprendizado comece muito baixa. Ao seguir este processo, o treinamento continuará a partir dos pesos fornecidos, ajustando-se às nuances dos seus novos dados.

Tiling de Imagem para Objetos Pequenos

O mosaico de imagens pode melhorar a precisão da detect para objetos pequenos. Ao dividir imagens maiores em segments menores, como dividir imagens 1280x1280 em múltiplos segments 640x640, você mantém a resolução original, e o modelo pode aprender com fragmentos de alta resolução. Ao usar o YOLO26, certifique-se de ajustar seus rótulos para esses novos segments corretamente.

Interaja com a Comunidade

Compartilhar suas ideias e perguntas com outros entusiastas de visão computacional pode inspirar soluções criativas para os obstáculos em seus projetos. Aqui estão algumas maneiras excelentes de aprender, solucionar problemas e se conectar.

Encontrando Ajuda e Suporte

- Problemas no GitHub: Explore o repositório YOLO26 no GitHub e use a aba de Issues para fazer perguntas, relatar bugs e sugerir recursos. A comunidade e os mantenedores estão disponíveis para ajudar com quaisquer problemas que você encontrar.

- Servidor Ultralytics Discord: Junte-se ao servidor Ultralytics Discord para se conectar com outros usuários e desenvolvedores, obter suporte, compartilhar conhecimento e trocar ideias.

Documentação Oficial

- Documentação Ultralytics YOLO26: Consulte a documentação oficial do YOLO26 para guias abrangentes e insights valiosos sobre várias tarefas e projetos de visão computacional.

Considerações Finais

Avaliar e ajustar seu modelo de visão computacional são passos importantes para uma implantação de modelo bem-sucedida. Esses passos ajudam a garantir que seu modelo seja preciso, eficiente e adequado à sua aplicação geral. A chave para treinar o melhor modelo possível é a experimentação e o aprendizado contínuos. Não hesite em ajustar parâmetros, experimentar novas técnicas e explorar diferentes conjuntos de dados. Continue experimentando e expandindo os limites do que é possível!

FAQ

Quais são as principais métricas para avaliar o desempenho do modelo YOLO26?

Para avaliar o desempenho do modelo YOLO26, métricas importantes incluem Pontuação de Confiança, Interseção sobre União (IoU) e Precisão Média (mAP). A Pontuação de Confiança mede a certeza do modelo para cada classe de objeto detect. A IoU avalia o quão bem a caixa delimitadora prevista se sobrepõe à verdade fundamental. A Precisão Média (mAP) agrega pontuações de precisão entre as classes, sendo mAP@.5 e mAP@.5:.95 dois tipos comuns para diferentes limiares de IoU. Saiba mais sobre essas métricas em nosso guia de métricas de desempenho do YOLO26.

Como posso ajustar um modelo YOLO26 pré-treinado para meu conjunto de dados específico?

O ajuste fino de um modelo YOLO26 pré-treinado envolve ajustar seus parâmetros para melhorar o desempenho em uma tarefa ou conjunto de dados específico. Comece avaliando seu modelo usando métricas e, em seguida, defina uma taxa de aprendizado inicial mais alta ajustando o warmup_epochs parâmetro para 0 para estabilidade imediata. Use parâmetros como rect=true para lidar com tamanhos de imagem variados de forma eficaz. Para orientações mais detalhadas, consulte a nossa seção sobre ajuste fino de modelos YOLO26.

Como posso lidar com tamanhos de imagem variáveis ao avaliar meu modelo YOLO26?

Para lidar com tamanhos de imagem variáveis durante a avaliação, use o rect=true parâmetro no YOLO26, que ajusta o passo da rede para cada lote com base nos tamanhos das imagens. O imgsz parâmetro define a dimensão máxima para redimensionamento de imagem, o padrão é 640. Ajuste imgsz para adequar ao seu conjunto de dados e à memória da GPU. Para mais detalhes, visite nosso seção sobre como lidar com tamanhos de imagem variáveis.

Que passos práticos posso tomar para melhorar a precisão média para o meu modelo YOLO26?

Melhorar a precisão média (mAP) para um modelo YOLO26 envolve várias etapas:

- Ajuste de Hiperparâmetros: Experimente diferentes taxas de aprendizado, tamanhos de lote e aumentos de imagem.

- Aumento de Dados: Use técnicas como Mosaic e MixUp para criar amostras de treinamento diversificadas.

- Image Tiling: Divida imagens maiores em tiles menores para melhorar a precisão da detecção de objetos pequenos. Consulte nosso guia detalhado sobre ajuste fino do modelo para estratégias específicas.

Como acesso as métricas de avaliação do modelo YOLO26 em Python?

É possível acessar as métricas de avaliação do modelo YOLO26 usando Python com as seguintes etapas:

Utilização

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Run the evaluation

results = model.val(data="coco8.yaml")

# Print specific metrics

print("Class indices with average precision:", results.ap_class_index)

print("Average precision for all classes:", results.box.all_ap)

print("Mean average precision at IoU=0.50:", results.box.map50)

print("Mean recall:", results.box.mr)

A análise dessas métricas ajuda a ajustar e otimizar seu modelo YOLO26. Para uma análise mais aprofundada, consulte nosso guia sobre métricas do YOLO26.