모델 평가 및 미세 조정에 대한 통찰력

소개

컴퓨터 비전 모델을 학습한 후에는 최적의 성능을 발휘하도록 평가하고 개선하는 것이 필수적입니다. 모델을 학습하는 것만으로는 충분하지 않습니다. 모델이 정확하고 효율적이며 컴퓨터 비전 프로젝트의 목표를 충족하는지 확인해야 합니다. 모델을 평가하고 미세 조정하면 약점을 식별하고 정확도를 높이며 전반적인 성능을 향상시킬 수 있습니다.

참고: 모델 평가 및 미세 조정에 대한 통찰력 | 평균 정밀도 향상을 위한 팁

이 가이드에서는 모델 평가 및 미세 조정에 대한 통찰력을 공유하여 이 컴퓨터 비전 프로젝트 단계를 더 쉽게 접근할 수 있도록 합니다. 평가 지표를 이해하고 미세 조정 기술을 구현하는 방법을 논의하여 모델의 기능을 향상시킬 수 있는 지식을 제공합니다.

메트릭을 사용한 모델 성능 평가

모델이 얼마나 잘 수행되는지 평가하면 모델이 얼마나 효과적으로 작동하는지 이해하는 데 도움이 됩니다. 성능을 측정하기 위해 다양한 메트릭이 사용됩니다. 이러한 성능 메트릭은 명확하고 수치적인 통찰력을 제공하여 모델이 의도한 목표를 충족하는지 확인하기 위한 개선 사항을 안내할 수 있습니다. 몇 가지 주요 메트릭을 자세히 살펴보겠습니다.

신뢰도 점수

신뢰도 점수는 감지된 객체가 특정 클래스에 속할 것이라는 모델의 확신을 나타냅니다. 범위는 0에서 1 사이이며 점수가 높을수록 신뢰도가 높습니다. 신뢰도 점수는 예측을 필터링하는 데 도움이 됩니다. 지정된 임계값보다 높은 신뢰도 점수를 가진 감지만 유효한 것으로 간주됩니다.

간단한 팁: 추론을 실행할 때 예측이 표시되지 않고 다른 모든 것을 확인했다면 신뢰도 점수를 낮춰보세요. 때로는 임계값이 너무 높아서 모델이 유효한 예측을 무시하게 됩니다. 점수를 낮추면 모델이 더 많은 가능성을 고려할 수 있습니다. 이것이 프로젝트 목표에 부합하지 않을 수도 있지만 모델이 무엇을 할 수 있는지 확인하고 미세 조정 방법을 결정하는 좋은 방법입니다.

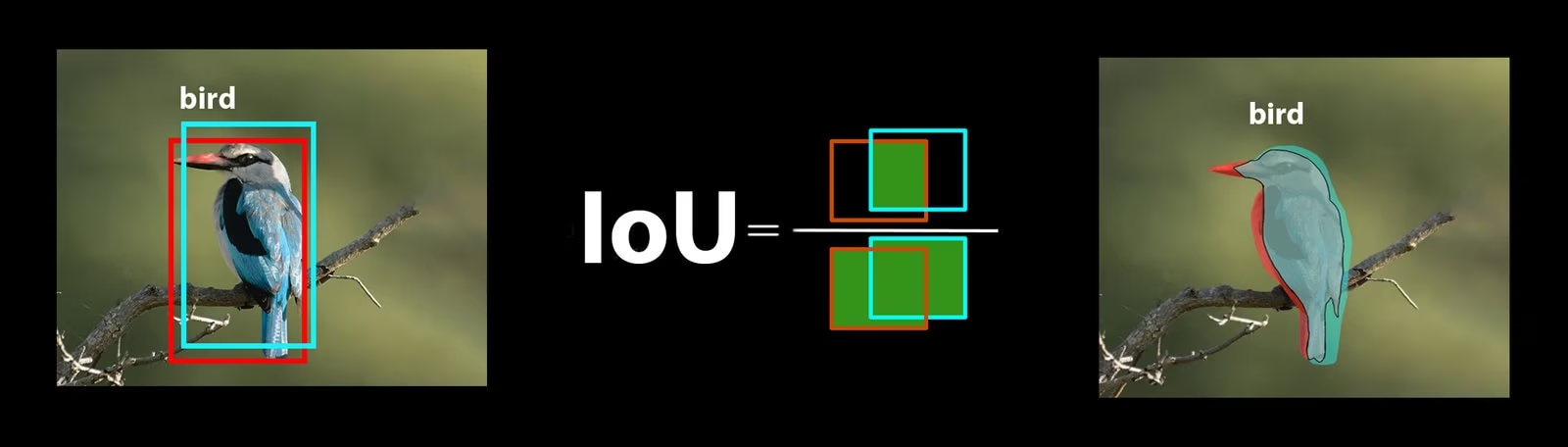

Intersection over Union

IoU(Intersection over Union)는 예측된 bounding box가 실제 bounding box와 얼마나 겹치는지를 측정하는 객체 감지의 지표입니다. IoU 값은 0에서 1 사이이며, 1은 완벽한 일치를 나타냅니다. IoU는 예측된 경계가 실제 객체 경계와 얼마나 일치하는지 측정하기 때문에 중요합니다.

평균 정밀도

평균 정밀도(mAP)는 객체 감지 모델의 성능을 측정하는 방법입니다. 각 객체 클래스를 감지하는 정밀도를 살펴보고 이러한 점수를 평균화하여 모델이 객체를 얼마나 정확하게 식별하고 분류할 수 있는지 보여주는 전체 숫자를 제공합니다.

두 가지 특정 mAP 지표에 집중해 보겠습니다:

- mAP@.5: 0.5의 단일 IoU (Intersection over Union) 임계값에서 평균 정확도를 측정합니다. 이 지표는 모델이 느슨한 정확도 요구 사항으로 객체를 올바르게 찾을 수 있는지 확인합니다. 완벽한 배치가 필요하지 않고 객체가 대략 올바른 위치에 있는지 여부에 중점을 둡니다. 모델이 일반적으로 객체를 식별하는 데 능숙한지 확인하는 데 도움이 됩니다.

- mAP@.5:.95: 0.05 간격으로 0.5에서 0.95까지의 여러 IoU 임계값에서 계산된 mAP 값을 평균냅니다. 이 지표는 더 자세하고 엄격합니다. 다양한 수준의 엄격성에서 모델이 객체를 얼마나 정확하게 찾을 수 있는지에 대한 더 완전한 그림을 제공하며, 특히 정확한 객체 detect이 필요한 애플리케이션에 유용합니다.

다른 mAP 지표로는 0.75의 더 엄격한 IoU 임계값을 사용하는 mAP@0.75와 다양한 크기의 객체에 대한 정밀도를 평가하는 mAP@small, medium, large가 있습니다.

YOLO26 모델 성능 평가하기

YOLO26과 관련하여, 검증 모드(validation mode)를 사용하여 모델을 평가할 수 있습니다. 또한, YOLO26 성능 지표와 이를 해석하는 방법에 대해 심층적으로 다루는 가이드도 꼭 확인해 보세요.

일반적인 커뮤니티 질문

YOLO26 모델을 평가할 때 몇 가지 어려움에 부딪힐 수 있습니다. 일반적인 커뮤니티 질문을 바탕으로, YOLO26 모델을 최대한 활용하는 데 도움이 되는 몇 가지 팁을 소개합니다.

가변 이미지 크기 처리

다양한 크기의 이미지로 YOLO26 모델을 평가하면 다양한 데이터셋에서의 성능을 이해하는 데 도움이 될 수 있습니다. 다음을 사용하여 rect=true 검증 매개변수(validation parameter)를 사용하면 YOLO26은 이미지 크기에 따라 각 배치에 대한 네트워크의 스트라이드(stride)를 조정하여, 모델이 직사각형 이미지를 단일 크기로 강제 변환하지 않고도 처리할 수 있도록 합니다.

에 지정되어 있습니다. imgsz validation 매개변수는 이미지 크기 조정을 위한 최대 크기를 설정하며 기본적으로 640입니다. 데이터 세트의 최대 크기 및 사용 가능한 GPU 메모리에 따라 조정할 수 있습니다. 심지어 imgsz 설정 rect=true 모델이 스트라이드를 동적으로 조정하여 다양한 이미지 크기를 효과적으로 관리할 수 있습니다.

YOLO26 지표 접근하기

YOLO26 모델의 성능에 대해 더 깊이 이해하고 싶다면, 몇 줄의 python 코드로 특정 평가 지표에 쉽게 접근할 수 있습니다. 아래 코드 스니펫을 통해 모델을 로드하고 평가를 실행하며, 모델의 성능을 보여주는 다양한 지표를 출력할 수 있습니다.

사용법

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Run the evaluation

results = model.val(data="coco8.yaml")

# Print specific metrics

print("Class indices with average precision:", results.ap_class_index)

print("Average precision for all classes:", results.box.all_ap)

print("Average precision:", results.box.ap)

print("Average precision at IoU=0.50:", results.box.ap50)

print("Class indices for average precision:", results.box.ap_class_index)

print("Class-specific results:", results.box.class_result)

print("F1 score:", results.box.f1)

print("F1 score curve:", results.box.f1_curve)

print("Overall fitness score:", results.box.fitness)

print("Mean average precision:", results.box.map)

print("Mean average precision at IoU=0.50:", results.box.map50)

print("Mean average precision at IoU=0.75:", results.box.map75)

print("Mean average precision for different IoU thresholds:", results.box.maps)

print("Mean results for different metrics:", results.box.mean_results)

print("Mean precision:", results.box.mp)

print("Mean recall:", results.box.mr)

print("Precision:", results.box.p)

print("Precision curve:", results.box.p_curve)

print("Precision values:", results.box.prec_values)

print("Specific precision metrics:", results.box.px)

print("Recall:", results.box.r)

print("Recall curve:", results.box.r_curve)

결과 객체에는 전처리 시간, 추론 시간, 손실(loss), 후처리 시간과 같은 속도 지표도 포함됩니다. 이러한 지표를 분석함으로써 더 나은 성능을 위해 YOLO26 모델을 미세 조정하고 최적화할 수 있으며, 특정 사용 사례에 더욱 효과적으로 만들 수 있습니다.

미세 조정은 어떻게 작동하나요?

미세 조정은 사전 훈련된 모델을 가져와 특정 작업 또는 데이터셋에서 성능을 향상시키기 위해 매개변수를 조정하는 것을 포함합니다. 모델 재훈련이라고도 하는 이 프로세스는 모델이 실제 애플리케이션에서 마주하게 될 특정 데이터를 더 잘 이해하고 결과를 예측할 수 있도록 합니다. 최적의 결과를 얻기 위해 모델 평가를 기반으로 모델을 재훈련할 수 있습니다.

모델 미세 조정을 위한 팁

모델 미세 조정은 최적의 성능을 얻기 위해 여러 중요한 매개변수와 기술에 세심한 주의를 기울이는 것을 의미합니다. 다음은 프로세스를 안내하는 데 필요한 몇 가지 필수 팁입니다.

더 높은 학습률로 시작

일반적으로 초기 학습 epoch 동안 학습률은 낮게 시작하여 점차 증가하여 학습 프로세스를 안정화합니다. 그러나 모델이 이전 데이터 세트에서 일부 특징을 이미 학습했으므로 더 높은 학습률로 바로 시작하는 것이 더 유리할 수 있습니다.

YOLO26 모델을 평가할 때 다음을 설정할 수 있습니다. warmup_epochs 유효성 검사 파라미터를 warmup_epochs=0 를 설정하여 학습률이 너무 낮게 시작되는 것을 방지할 수 있습니다. 이 과정을 따라가면 제공된 가중치에서 새로운 데이터의 뉘앙스에 맞춰 학습이 계속됩니다.

작은 객체를 위한 이미지 타일링

이미지 타일링은 작은 객체에 대한 detect 정확도를 향상시킬 수 있습니다. 1280x1280 이미지를 여러 640x640 세그먼트로 분할하는 것과 같이 더 큰 이미지를 더 작은 세그먼트로 나누면 원본 해상도를 유지하고 모델이 고해상도 조각으로부터 학습할 수 있습니다. YOLO26을 사용할 때는 이러한 새 세그먼트에 대한 레이블을 올바르게 조정해야 합니다.

커뮤니티와 소통

다른 컴퓨터 비전 애호가들과 아이디어와 질문을 공유하면 프로젝트의 문제점에 대한 창의적인 해결책을 얻을 수 있습니다. 다음은 배우고, 문제를 해결하고, 연결할 수 있는 몇 가지 훌륭한 방법입니다.

도움말 및 지원 찾기

- GitHub 이슈: YOLO26 GitHub 저장소를 탐색하고 이슈 탭을 사용하여 질문하고, 버그를 보고하고, 기능을 제안하십시오. 커뮤니티와 관리자는 발생하는 모든 문제에 대해 지원할 준비가 되어 있습니다.

- Ultralytics Discord 서버: Ultralytics Discord 서버에 가입하여 다른 사용자 및 개발자와 연결하고, 지원을 받고, 지식을 공유하고, 아이디어를 브레인스토밍하십시오.

공식 문서

- Ultralytics YOLO26 문서: 다양한 컴퓨터 비전 작업 및 프로젝트에 대한 포괄적인 가이드와 유용한 통찰력을 얻으려면 공식 YOLO26 문서를 확인하십시오.

결론

컴퓨터 비전 모델을 평가하고 미세 조정하는 것은 성공적인 모델 배포를 위한 중요한 단계입니다. 이러한 단계를 통해 모델이 정확하고 효율적이며 전체 애플리케이션에 적합한지 확인할 수 있습니다. 가능한 최상의 모델을 훈련하는 핵심은 지속적인 실험과 학습입니다. 매개변수를 조정하고, 새로운 기술을 시도하고, 다양한 데이터 세트를 탐색하는 것을 주저하지 마십시오. 계속 실험하고 가능한 것의 경계를 넓히십시오!

FAQ

YOLO26 모델 성능 평가를 위한 주요 지표는 무엇인가요?

YOLO26 모델 성능을 평가하는 데 중요한 지표로는 Confidence Score, Intersection over Union (IoU), 그리고 Mean Average Precision (mAP)이 있습니다. Confidence Score는 detect된 각 객체 클래스에 대한 모델의 확신도를 측정합니다. IoU는 예측된 바운딩 박스가 실제 값과 얼마나 잘 겹치는지 평가합니다. Mean Average Precision (mAP)은 클래스 전반의 정밀도 점수를 집계하며, mAP@.5 및 mAP@.5:.95는 다양한 IoU 임계값에 대한 두 가지 일반적인 유형입니다. 이러한 지표에 대한 자세한 내용은 YOLO26 성능 지표 가이드에서 확인하십시오.

특정 데이터셋에 맞게 사전 학습된 YOLO26 모델을 어떻게 미세 조정할 수 있나요?

사전 훈련된 YOLO26 모델을 미세 조정하는 것은 특정 작업 또는 데이터셋에서 성능을 향상시키기 위해 매개변수를 조정하는 것을 포함합니다. 지표를 사용하여 모델을 평가하는 것부터 시작한 다음, 초기 학습률을 더 높게 설정하여 조정합니다. warmup_epochs parameter를 0으로 설정하여 즉시 안정화하십시오. 다음과 같은 매개변수를 사용하십시오. rect=true 다양한 이미지 크기를 효과적으로 처리하는 데 유용합니다. 자세한 내용은 Dataset Introduction 섹션을 참조하십시오. YOLO26 모델 미세 조정.

YOLO26 모델을 평가할 때 가변 이미지 크기를 어떻게 처리할 수 있나요?

평가 중에 다양한 이미지 크기를 처리하려면 다음을 사용하십시오. rect=true YOLO26의 매개변수는 이미지 크기에 따라 각 배치에 대한 네트워크의 stride를 조정합니다. imgsz parameter는 이미지 크기 조정의 최대 크기를 설정하며 기본값은 640입니다. 필요에 따라 조정하십시오. imgsz 데이터 세트 및 GPU 메모리에 맞게 조정합니다. 자세한 내용은 다음을 참조하십시오. 다양한 이미지 크기 처리 섹션.

YOLO26 모델의 mAP(Mean Average Precision)를 개선하기 위해 어떤 실질적인 단계를 취할 수 있나요?

YOLO26 모델의 mAP(Mean Average Precision)를 개선하기 위한 몇 가지 단계는 다음과 같습니다.

- 하이퍼파라미터 튜닝: 다양한 학습률, 배치 크기 및 이미지 증강을 실험해 보세요.

- Data Augmentation: Mosaic 및 MixUp과 같은 기술을 사용하여 다양한 학습 샘플을 만듭니다.

- 이미지 타일링: 큰 이미지를 작은 타일로 분할하여 작은 물체에 대한 감지 정확도를 높입니다. 구체적인 전략은 모델 미세 조정에 대한 자세한 가이드를 참조하세요.

python에서 YOLO26 모델 평가 지표에 어떻게 접근하나요?

다음 단계에 따라 python을 사용하여 YOLO26 모델 평가 지표에 액세스할 수 있습니다.

사용법

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Run the evaluation

results = model.val(data="coco8.yaml")

# Print specific metrics

print("Class indices with average precision:", results.ap_class_index)

print("Average precision for all classes:", results.box.all_ap)

print("Mean average precision at IoU=0.50:", results.box.map50)

print("Mean recall:", results.box.mr)

이러한 지표를 분석하면 YOLO26 모델을 미세 조정하고 최적화하는 데 도움이 됩니다. 더 자세한 내용은 YOLO26 지표에 대한 가이드를 확인하십시오.