Аугментация во время тестирования (TTA)

📚 В этом руководстве объясняется, как использовать Test Time Augmentation (TTA) во время тестирования и inference для улучшения mAP и Recall с помощью YOLOv5 🚀.

Прежде чем начать

Клонируйте репозиторий и установите requirements.txt в окружении Python>=3.8.0, включая PyTorch>=1.8. Модели и наборы данных загружаются автоматически из последнего релиза YOLOv5.

git clone https://github.com/ultralytics/yolov5 # clone

cd yolov5

pip install -r requirements.txt # install

Тестировать нормально

Прежде чем пробовать TTA, мы хотим установить базовую производительность для сравнения. Эта команда тестирует YOLOv5x на COCO val2017 при размере изображения 640 пикселей. yolov5x.pt это самая большая и точная из доступных моделей. Другие варианты: yolov5s.pt, yolov5m.pt и yolov5l.pt, или вашу собственную контрольную точку после обучения пользовательскому набору данных ./weights/best.pt. Подробную информацию обо всех доступных моделях можно найти в нашем Документация YOLOv5.

python val.py --weights yolov5x.pt --data coco.yaml --img 640 --half

Вывод:

val: data=./data/coco.yaml, weights=['yolov5x.pt'], batch_size=32, imgsz=640, conf_thres=0.001, iou_thres=0.65, task=val, device=, single_cls=False, augment=False, verbose=False, save_txt=False, save_conf=False, save_json=True, project=runs/val, name=exp, exist_ok=False, half=True

YOLOv5 🚀 v5.0-267-g6a3ee7c torch 1.9.0+cu102 CUDA:0 (Tesla P100-PCIE-16GB, 16280.875MB)

Fusing layers...

Model Summary: 476 layers, 87730285 parameters, 0 gradients

val: Scanning '../datasets/coco/val2017' images and labels...4952 found, 48 missing, 0 empty, 0 corrupted: 100% 5000/5000 [00:01<00:00, 2846.03it/s]

val: New cache created: ../datasets/coco/val2017.cache

Class Images Labels P R mAP@.5 mAP@.5:.95: 100% 157/157 [02:30<00:00, 1.05it/s]

all 5000 36335 0.746 0.626 0.68 0.49

Speed: 0.1ms pre-process, 22.4ms inference, 1.4ms NMS per image at shape (32, 3, 640, 640) # <--- baseline speed

Evaluating pycocotools mAP... saving runs/val/exp/yolov5x_predictions.json...

...

Average Precision (AP) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.504 # <--- baseline mAP

Average Precision (AP) @[ IoU=0.50 | area= all | maxDets=100 ] = 0.688

Average Precision (AP) @[ IoU=0.75 | area= all | maxDets=100 ] = 0.546

Average Precision (AP) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.351

Average Precision (AP) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.551

Average Precision (AP) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.644

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 1 ] = 0.382

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 10 ] = 0.628

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.681 # <--- baseline mAR

Average Recall (AR) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.524

Average Recall (AR) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.735

Average Recall (AR) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.826

Тестирование с TTA

Добавить --augment к любому существующему val.py команду для включения TTA и увеличения размера изображения примерно на 30% для улучшения результатов. Обратите внимание, что вывод с включенным TTA обычно занимает примерно в 2-3 раза больше времени, чем обычный вывод, поскольку изображения переворачиваются слева направо и обрабатываются в 3 различных разрешениях, а результаты объединяются перед NMS. Часть снижения скорости связана просто с большим размером изображений (832 против 640), а часть — с фактическими операциями TTA, поэтому убедитесь, что ваша GPU имеет достаточный запас памяти, прежде чем увеличивать --img.

python val.py --weights yolov5x.pt --data coco.yaml --img 832 --augment --half

Вывод:

val: data=./data/coco.yaml, weights=['yolov5x.pt'], batch_size=32, imgsz=832, conf_thres=0.001, iou_thres=0.6, task=val, device=, single_cls=False, augment=True, verbose=False, save_txt=False, save_conf=False, save_json=True, project=runs/val, name=exp, exist_ok=False, half=True

YOLOv5 🚀 v5.0-267-g6a3ee7c torch 1.9.0+cu102 CUDA:0 (Tesla P100-PCIE-16GB, 16280.875MB)

Fusing layers...

/usr/local/lib/python3.7/dist-packages/torch/nn/functional.py:718: UserWarning: Named tensors and all their associated APIs are an experimental feature and subject to change. Please do not use them for anything important until they are released as stable. (Triggered internally at /pytorch/c10/core/TensorImpl.h:1156.)

return torch.max_pool2d(input, kernel_size, stride, padding, dilation, ceil_mode)

Model Summary: 476 layers, 87730285 parameters, 0 gradients

val: Scanning '../datasets/coco/val2017' images and labels...4952 found, 48 missing, 0 empty, 0 corrupted: 100% 5000/5000 [00:01<00:00, 2885.61it/s]

val: New cache created: ../datasets/coco/val2017.cache

Class Images Labels P R mAP@.5 mAP@.5:.95: 100% 157/157 [07:29<00:00, 2.86s/it]

all 5000 36335 0.718 0.656 0.695 0.503

Speed: 0.2ms pre-process, 80.6ms inference, 2.7ms NMS per image at shape (32, 3, 832, 832) # <--- TTA speed

Evaluating pycocotools mAP... saving runs/val/exp2/yolov5x_predictions.json...

...

Average Precision (AP) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.516 # <--- TTA mAP

Average Precision (AP) @[ IoU=0.50 | area= all | maxDets=100 ] = 0.701

Average Precision (AP) @[ IoU=0.75 | area= all | maxDets=100 ] = 0.562

Average Precision (AP) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.361

Average Precision (AP) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.564

Average Precision (AP) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.656

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 1 ] = 0.388

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 10 ] = 0.640

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.696 # <--- TTA mAR

Average Recall (AR) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.553

Average Recall (AR) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.744

Average Recall (AR) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.833

Инференс с TTA

detect.py Вывод TTA работает идентично val.py TTA: просто добавьте --augment к любому существующему detect.py команда:

python detect.py --weights yolov5s.pt --img 832 --source data/images --augment

Вывод:

YOLOv5 🚀 v5.0-267-g6a3ee7c torch 1.9.0+cu102 CUDA:0 (Tesla P100-PCIE-16GB, 16280.875MB)

Downloading https://github.com/ultralytics/yolov5/releases/download/v5.0/yolov5s.pt to yolov5s.pt...

100% 14.1M/14.1M [00:00<00:00, 81.9MB/s]

Fusing layers...

Model Summary: 224 layers, 7266973 parameters, 0 gradients

image 1/2 /content/yolov5/data/images/bus.jpg: 832x640 4 persons, 1 bus, 1 fire hydrant, Done. (0.029s)

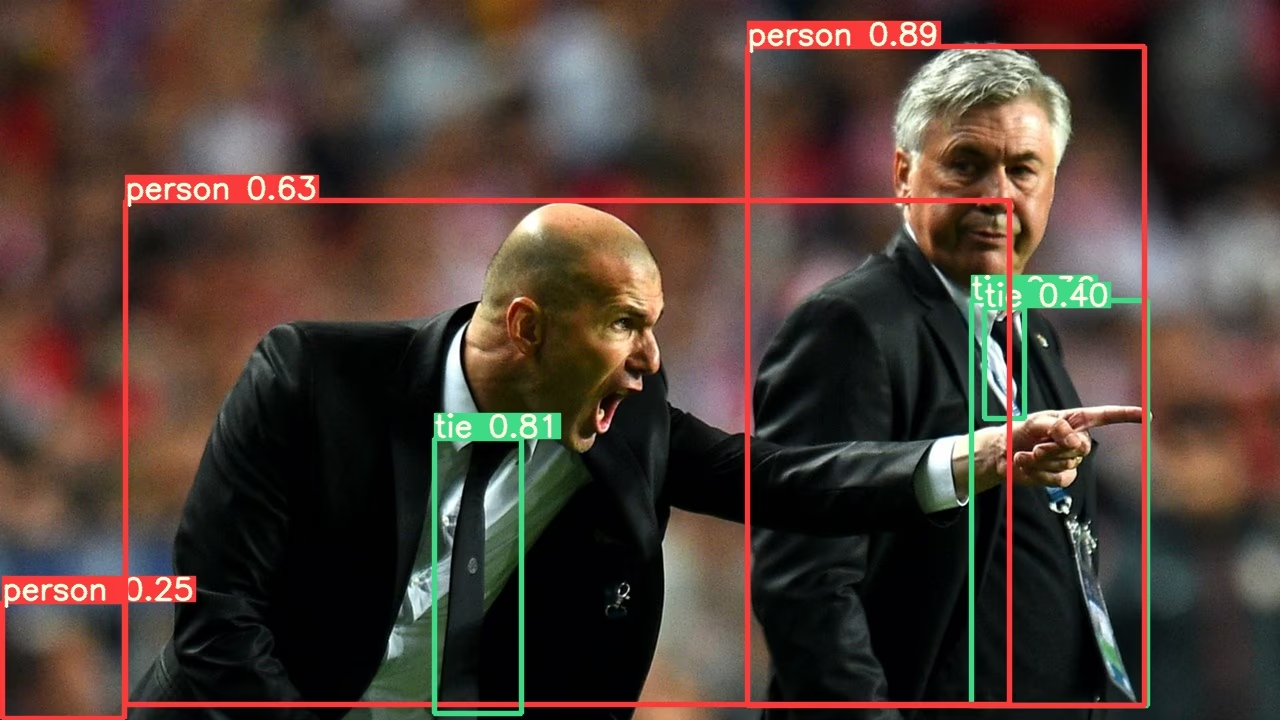

image 2/2 /content/yolov5/data/images/zidane.jpg: 480x832 3 persons, 3 ties, Done. (0.024s)

Results saved to runs/detect/exp

Done. (0.156s)

PyTorch Hub TTA

TTA автоматически интегрирован во все YOLOv5 PyTorch Hub моделей и может быть получен путем передачи augment=True во время инференса.

import torch

# Model

model = torch.hub.load("ultralytics/yolov5", "yolov5s") # or yolov5m, yolov5x, custom

# Images

img = "https://ultralytics.com/images/zidane.jpg" # or file, PIL, OpenCV, numpy, multiple

# Inference

results = model(img, augment=True) # <--- TTA inference

# Results

results.print() # or .show(), .save(), .crop(), .pandas(), etc.

Настроить

Вы можете настроить операции TTA, применяемые в YOLOv5 forward_augment() метод.

Преимущества аугментации во время тестирования

Аугментация во время тестирования предоставляет несколько ключевых преимуществ для задач обнаружения объектов:

- Повышенная точность: Как показано в результатах выше, TTA увеличивает mAP с 0.504 до 0.516 и mAR с 0.681 до 0.696.

- Улучшенное обнаружение мелких объектов: TTA особенно улучшает обнаружение мелких объектов, при этом AP для малых областей улучшается с 0,351 до 0,361.

- Повышенная надежность: Тестируя несколько вариаций каждого изображения, TTA снижает влияние угла обзора, освещения и других факторов окружающей среды.

- Простая реализация: Требуется только добавить

--augmentфлаг к существующим командам.

Компромиссом является увеличение времени инференса, что делает TTA более подходящим для приложений, где точность имеет приоритет над скоростью.

Поддерживаемые среды

Ultralytics предоставляет ряд готовых к использованию сред, каждая из которых предварительно установлена с необходимыми зависимостями, такими как CUDA, CUDNN, Python и PyTorch, чтобы дать старт вашим проектам.

- Бесплатные блокноты GPU:

- Google Cloud: Краткое руководство по GCP

- Amazon: Краткое руководство по AWS

- Azure: Краткое руководство по AzureML

- Docker: Краткое руководство по Docker

Статус проекта

Этот значок указывает на то, что все тесты непрерывной интеграции (CI) YOLOv5 GitHub Actions успешно пройдены. Эти тесты CI тщательно проверяют функциональность и производительность YOLOv5 по различным ключевым аспектам: обучение, валидация, вывод, экспорт и бенчмарки. Они обеспечивают стабильную и надежную работу в macOS, Windows и Ubuntu, при этом тесты проводятся каждые 24 часа и при каждом новом коммите.