Meilleures pratiques pour le déploiement de modèles

Introduction

Le déploiement du modèle est l'étape d'un projet de vision par ordinateur qui fait passer un modèle de la phase de développement à une application réelle. Il existe différentes options de déploiement de modèle : le déploiement dans le cloud offre une évolutivité et une facilité d'accès, le déploiement en périphérie réduit la latence en rapprochant le modèle de la source de données, et le déploiement local garantit la confidentialité et le contrôle. Le choix de la bonne stratégie dépend des besoins de votre application, en équilibrant la vitesse, la sécurité et l'évolutivité.

Regarder : Comment optimiser et déployer des modèles d'IA : meilleures pratiques, dépannage et considérations de sécurité

Il est également important de suivre les meilleures pratiques lors du déploiement d'un modèle, car le déploiement peut avoir un impact significatif sur l'efficacité et la fiabilité des performances du modèle. Dans ce guide, nous nous concentrerons sur la manière de nous assurer que le déploiement de votre modèle se déroule de manière fluide, efficace et sécurisée.

Options de déploiement de modèles

Souvent, une fois qu'un modèle est entraîné, évalué et testé, il doit être converti dans des formats spécifiques pour être déployé efficacement dans divers environnements, tels que le cloud, la périphérie ou les appareils locaux.

Avec YOLO26, vous pouvez exporter votre modèle vers divers formats en fonction de vos besoins de déploiement. Par exemple, exporter YOLO26 vers ONNX est simple et idéal pour transférer des modèles entre frameworks. Pour explorer davantage d'options d'intégration et assurer un déploiement fluide dans différents environnements, visitez notre hub d'intégration de modèles.

Choisir un environnement de déploiement

Le choix de l'endroit où déployer votre modèle de vision par ordinateur dépend de plusieurs facteurs. Les différents environnements ont des avantages et des défis uniques, il est donc essentiel de choisir celui qui convient le mieux à vos besoins.

Déploiement dans le cloud

Le déploiement dans le cloud est idéal pour les applications qui doivent évoluer rapidement et traiter de grandes quantités de données. Les plateformes comme AWS, Google Cloud et Azure facilitent la gestion de vos modèles, de la formation au déploiement. Elles offrent des services tels que AWS SageMaker, Google AI Platform et Azure Machine Learning pour vous accompagner tout au long du processus.

Cependant, l'utilisation du cloud peut être coûteuse, surtout avec une utilisation élevée des données, et vous pourriez rencontrer des problèmes de latence si vos utilisateurs sont éloignés des centres de données. Pour gérer les coûts et les performances, il est important d'optimiser l'utilisation des ressources et de garantir la conformité aux règles de confidentialité des données.

Déploiement en périphérie

Le déploiement en périphérie fonctionne bien pour les applications nécessitant des réponses en temps réel et une faible latence, en particulier dans les endroits où l'accès à Internet est limité ou inexistant. Le déploiement de modèles sur des appareils périphériques tels que les smartphones ou les gadgets IoT garantit un traitement rapide et maintient les données locales, ce qui améliore la confidentialité. Le déploiement en périphérie permet également d'économiser de la bande passante grâce à la réduction des données envoyées vers le cloud.

Cependant, les appareils périphériques ont souvent une puissance de traitement limitée, vous devrez donc optimiser vos modèles. Des outils comme TensorFlow Lite et NVIDIA Jetson peuvent vous aider. Malgré les avantages, la maintenance et la mise à jour de nombreux appareils peuvent être difficiles.

Déploiement local

Le déploiement local est préférable lorsque la confidentialité des données est essentielle ou lorsqu'il n'y a pas d'accès à Internet ou que cet accès n'est pas fiable. L'exécution de modèles sur des serveurs locaux ou des ordinateurs de bureau vous donne un contrôle total et assure la sécurité de vos données. Il peut également réduire la latence si le serveur est proche de l'utilisateur.

Cependant, la mise à l'échelle locale peut être difficile, et la maintenance peut prendre du temps. L'utilisation d'outils comme Docker pour la conteneurisation et Kubernetes pour la gestion peut aider à rendre les déploiements locaux plus efficaces. Des mises à jour et une maintenance régulières sont nécessaires pour que tout fonctionne correctement.

Conteneurisation pour un déploiement simplifié

La conteneurisation est une approche puissante qui regroupe votre modèle et toutes ses dépendances dans une unité standardisée appelée conteneur. Cette technique garantit des performances constantes dans différents environnements et simplifie le processus de déploiement.

Avantages de l'utilisation de Docker pour le déploiement de modèles

Docker est devenu la norme de l'industrie pour la conteneurisation dans les déploiements d'apprentissage automatique pour plusieurs raisons :

- Cohérence de l'environnement : Les conteneurs Docker encapsulent votre modèle et toutes ses dépendances, éliminant le problème du "ça marche sur ma machine" en assurant un comportement cohérent entre les environnements de développement, de test et de production.

- Isolation : Les conteneurs isolent les applications les unes des autres, empêchant les conflits entre les différentes versions de logiciels ou bibliothèques.

- Portabilité : Les conteneurs Docker peuvent s’exécuter sur n’importe quel système prenant en charge Docker, ce qui facilite le déploiement de vos modèles sur différentes plateformes sans modification.

- Scalabilité : Les conteneurs peuvent être facilement mis à l'échelle en fonction de la demande, et les outils d'orchestration comme Kubernetes peuvent automatiser ce processus.

- Contrôle de version : Les images Docker peuvent être versionnées, ce qui vous permet de suivre les modifications et de revenir aux versions précédentes si nécessaire.

Implémenter Docker pour le déploiement de YOLO26

Pour conteneuriser votre modèle YOLO26, vous pouvez créer un Dockerfile qui spécifie toutes les dépendances et configurations nécessaires. Voici un exemple de base :

FROM ultralytics/ultralytics:latest

WORKDIR /app

# Copy your model and any additional files

COPY ./models/yolo26.pt /app/models/

COPY ./scripts /app/scripts/

# Set up any environment variables

ENV MODEL_PATH=/app/models/yolo26.pt

# Command to run when the container starts

CMD ["python", "/app/scripts/predict.py"]

Cette approche garantit que le déploiement de votre modèle est reproductible et cohérent dans différents environnements, réduisant considérablement le problème du "ça marche sur ma machine" qui affecte souvent les processus de déploiement.

Techniques d'optimisation de modèle

L'optimisation de votre modèle de vision par ordinateur l'aide à fonctionner efficacement, en particulier lors du déploiement dans des environnements aux ressources limitées comme les appareils périphériques. Voici quelques techniques clés pour optimiser votre modèle.

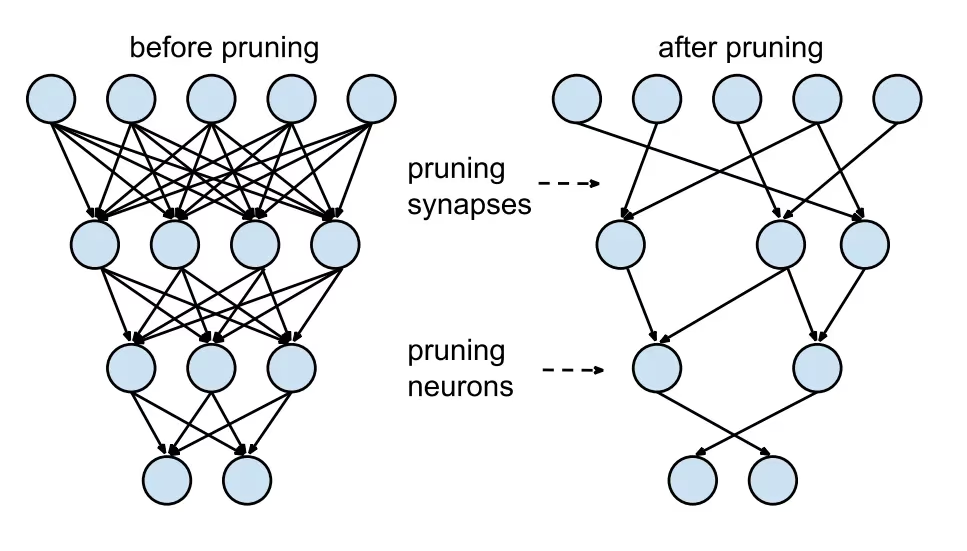

Élagage de modèle

L'élagage réduit la taille du modèle en supprimant les poids qui contribuent peu au résultat final. Il rend le modèle plus petit et plus rapide sans affecter de manière significative la précision. L'élagage consiste à identifier et à éliminer les paramètres inutiles, ce qui permet d'obtenir un modèle plus léger qui nécessite moins de puissance de calcul. Il est particulièrement utile pour déployer des modèles sur des appareils dotés de ressources limitées.

Quantification de modèle

La quantification convertit les poids et les activations du modèle d'une précision élevée (comme les nombres à virgule flottante de 32 bits) à une précision inférieure (comme les entiers de 8 bits). En réduisant la taille du modèle, elle accélère l'inférence. L'entraînement conscient de la quantification (QAT) est une méthode où le modèle est entraîné en tenant compte de la quantification, préservant ainsi la précision mieux que la quantification post-entraînement. En gérant la quantification pendant la phase d'entraînement, le modèle apprend à s'adapter à une précision inférieure, maintenant ainsi les performances tout en réduisant les exigences de calcul.

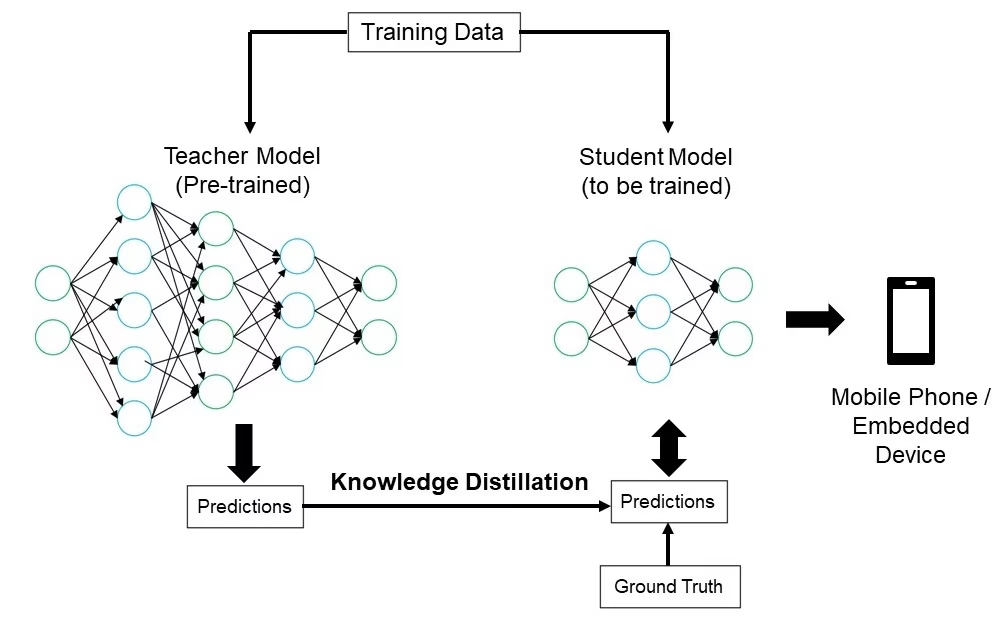

Distillation des connaissances

La distillation des connaissances implique la formation d'un modèle plus petit et plus simple (l'étudiant) pour imiter les sorties d'un modèle plus grand et plus complexe (l'enseignant). Le modèle étudiant apprend à approximer les prédictions de l'enseignant, ce qui donne un modèle compact qui conserve une grande partie de la précision de l'enseignant. Cette technique est avantageuse pour créer des modèles efficaces adaptés au déploiement sur des appareils périphériques avec des ressources limitées.

Dépannage des problèmes de déploiement

Vous pouvez rencontrer des difficultés lors du déploiement de vos modèles de vision par ordinateur, mais la compréhension des problèmes courants et des solutions peut faciliter le processus. Voici quelques conseils généraux de dépannage et les meilleures pratiques pour vous aider à résoudre les problèmes de déploiement.

Votre modèle est moins précis après le déploiement

Constater une baisse de la précision de votre modèle après le déploiement peut être frustrant. Ce problème peut provenir de divers facteurs. Voici quelques étapes pour vous aider à identifier et à résoudre le problème :

- Vérifier la cohérence des données: Vérifiez que les données traitées par votre modèle après le déploiement sont cohérentes avec les données sur lesquelles il a été entraîné. Les différences de distribution, de qualité ou de format des données peuvent avoir un impact significatif sur les performances.

- Valider les étapes de prétraitement : Vérifiez que toutes les étapes de prétraitement appliquées pendant l’entraînement sont également appliquées de manière cohérente pendant le déploiement. Cela comprend le redimensionnement des images, la normalisation des valeurs de pixels et d’autres transformations de données.

- Évaluez l'Environnement du Modèle : Assurez-vous que les configurations matérielles et logicielles utilisées lors du déploiement correspondent à celles utilisées lors de l'entraînement. Les différences de bibliothèques, de versions et de capacités matérielles peuvent introduire des divergences.

- Surveiller l'inférence du modèle : Enregistrez les entrées et les sorties à différentes étapes du pipeline d'inférence pour détecter toute anomalie. Cela peut aider à identifier des problèmes tels que la corruption de données ou une mauvaise gestion des sorties du modèle.

- Vérifier l'exportation et la conversion du modèle : Réexportez le modèle et assurez-vous que le processus de conversion maintient l'intégrité des poids et de l'architecture du modèle.

- Test avec un ensemble de données contrôlé : Déployez le modèle dans un environnement de test avec un ensemble de données que vous contrôlez et comparez les résultats avec la phase d’entraînement. Vous pouvez déterminer si le problème vient de l’environnement de déploiement ou des données.

Lors du déploiement de YOLO26, plusieurs facteurs peuvent affecter la précision du modèle. La conversion de modèles vers des formats comme TensorRT implique des optimisations telles que la quantification des poids et la fusion de couches, ce qui peut entraîner des pertes de précision mineures. L'utilisation de FP16 (précision semi-double) au lieu de FP32 (précision simple) peut accélérer l'inférence mais peut introduire des erreurs de précision numérique. De plus, les contraintes matérielles, comme celles sur le Jetson Nano, avec un nombre inférieur de cœurs CUDA et une bande passante mémoire réduite, peuvent impacter les performances.

Les inférences prennent plus de temps que prévu

Lors du déploiement de modèles d'apprentissage automatique, il est important qu'ils fonctionnent efficacement. Si les inférences prennent plus de temps que prévu, cela peut affecter l'expérience utilisateur et l'efficacité de votre application. Voici quelques étapes pour vous aider à identifier et à résoudre le problème :

- Implémenter des exécutions de préchauffage : Les exécutions initiales incluent souvent des frais généraux de configuration, ce qui peut fausser les mesures de latence. Effectuez quelques inférences de préchauffage avant de mesurer la latence. L'exclusion de ces exécutions initiales fournit une mesure plus précise des performances du modèle.

- Optimiser le moteur d'inférence : Vérifiez que le moteur d'inférence est entièrement optimisé pour votre architecture GPU spécifique. Utilisez les derniers pilotes et versions de logiciels adaptés à votre matériel pour garantir des performances et une compatibilité maximales.

- Utiliser le traitement asynchrone : Le traitement asynchrone peut aider à gérer les charges de travail plus efficacement. Utilisez des techniques de traitement asynchrone pour gérer plusieurs inférences simultanément, ce qui peut aider à répartir la charge et à réduire les temps d’attente.

- Profiler le pipeline d'inférence : L'identification des goulots d'étranglement dans le pipeline d'inférence peut aider à identifier la source des retards. Utilisez des outils de profilage pour analyser chaque étape du processus d'inférence, en identifiant et en corrigeant toutes les étapes qui causent des retards importants, telles que les couches inefficaces ou les problèmes de transfert de données.

- Utiliser une précision appropriée : L’utilisation d’une précision plus élevée que nécessaire peut ralentir les temps d’inférence. Expérimentez avec une précision plus faible, telle que FP16 (demi-précision), au lieu de FP32 (précision complète). Bien que FP16 puisse réduire le temps d’inférence, n’oubliez pas qu’il peut avoir un impact sur la précision du modèle.

Si vous rencontrez ce problème lors du déploiement de YOLO26, sachez que YOLO26 propose diverses tailles de modèles, telles que YOLO26n (nano) pour les appareils à faible capacité mémoire et YOLO26x (extra-large) pour les GPU plus puissants. Choisir la bonne variante de modèle pour votre matériel peut aider à équilibrer l'utilisation de la mémoire et le temps de traitement.

Gardez également à l'esprit que la taille des images d'entrée a un impact direct sur l'utilisation de la mémoire et le temps de traitement. Des résolutions plus faibles réduisent l'utilisation de la mémoire et accélèrent l'inférence, tandis que des résolutions plus élevées améliorent la précision mais nécessitent plus de mémoire et de puissance de traitement.

Considérations de sécurité lors du déploiement de modèles

Un autre aspect important du déploiement est la sécurité. La sécurité de vos modèles déployés est essentielle pour protéger les données sensibles et la propriété intellectuelle. Voici quelques bonnes pratiques que vous pouvez suivre en matière de déploiement sécurisé de modèles.

Transmission sécurisée des données

Il est très important de s'assurer que les données envoyées entre les clients et les serveurs sont sécurisées afin d'empêcher leur interception ou leur accès par des parties non autorisées. Vous pouvez utiliser des protocoles de chiffrement comme TLS (Transport Layer Security) pour chiffrer les données pendant leur transmission. Même si quelqu'un intercepte les données, il ne pourra pas les lire. Vous pouvez également utiliser un chiffrement de bout en bout qui protège les données de la source à la destination, de sorte que personne entre les deux ne puisse y accéder.

Contrôles d'accès

Il est essentiel de contrôler qui peut accéder à votre modèle et à ses données afin d'empêcher toute utilisation non autorisée. Utilisez des méthodes d'authentification fortes pour vérifier l'identité des utilisateurs ou des systèmes qui tentent d'accéder au modèle, et envisagez d'ajouter une sécurité supplémentaire avec l'authentification multifacteur (MFA). Configurez le contrôle d'accès basé sur les rôles (RBAC) pour attribuer des autorisations en fonction des rôles des utilisateurs, afin que les personnes n'aient accès qu'à ce dont elles ont besoin. Conservez des journaux d'audit détaillés pour suivre tous les accès et modifications apportés au modèle et à ses données, et examinez régulièrement ces journaux pour détecter toute activité suspecte.

Obfuscation de modèle

La protection de votre modèle contre la rétro-ingénierie ou l'utilisation abusive peut être réalisée par l'obfuscation du modèle. Cela implique le chiffrement des paramètres du modèle, tels que les poids et les biais dans les réseaux neuronaux, afin de rendre difficile la compréhension ou la modification du modèle par des personnes non autorisées. Vous pouvez également obfusquer l'architecture du modèle en renommant les couches et les paramètres ou en ajoutant des couches factices, ce qui rend plus difficile la rétro-ingénierie par les attaquants. Vous pouvez également servir le modèle dans un environnement sécurisé, comme une enclave sécurisée ou en utilisant un environnement d'exécution de confiance (TEE), ce qui peut fournir une couche de protection supplémentaire pendant l'inférence.

Partagez des idées avec vos pairs

Faire partie d'une communauté de passionnés de vision par ordinateur peut vous aider à résoudre des problèmes et à apprendre plus rapidement. Voici quelques façons de vous connecter, d'obtenir de l'aide et de partager des idées.

Ressources communautaires

- Problèmes GitHub : Explorez le dépôt GitHub de YOLO26 et utilisez l'onglet Issues pour poser des questions, signaler des bugs et suggérer de nouvelles fonctionnalités. La communauté et les mainteneurs sont très actifs et prêts à aider.

- Serveur Discord Ultralytics : Rejoignez le serveur Discord Ultralytics pour discuter avec d’autres utilisateurs et développeurs, obtenir de l’aide et partager vos expériences.

Documentation officielle

- Documentation Ultralytics YOLO26 : Consultez la documentation officielle de YOLO26 pour des guides détaillés et des conseils utiles sur divers projets de vision par ordinateur.

L'utilisation de ces ressources vous aidera à résoudre les défis et à vous tenir au courant des dernières tendances et pratiques dans la communauté de la vision par ordinateur.

Conclusion et prochaines étapes

Nous avons passé en revue certaines des meilleures pratiques à suivre lors du déploiement de modèles de vision par ordinateur. En sécurisant les données, en contrôlant l'accès et en masquant les détails du modèle, vous pouvez protéger les informations sensibles tout en assurant le bon fonctionnement de vos modèles. Nous avons également discuté de la manière de résoudre les problèmes courants tels que la réduction de la précision et la lenteur des inférences en utilisant des stratégies telles que les exécutions de préchauffage, l'optimisation des moteurs, le traitement asynchrone, le profilage des pipelines et le choix de la bonne précision.

Après avoir déployé votre modèle, l'étape suivante consiste à surveiller, maintenir et documenter votre application. Une surveillance régulière permet de détecter et de corriger rapidement les problèmes, la maintenance maintient vos modèles à jour et fonctionnels, et une bonne documentation assure le suivi de tous les changements et mises à jour. Ces étapes vous aideront à atteindre les objectifs de votre projet de vision par ordinateur.

FAQ

Quelles sont les meilleures pratiques pour le déploiement d'un modèle de machine learning avec Ultralytics YOLO26 ?

Le déploiement d'un modèle de machine learning, en particulier avec Ultralytics YOLO26, implique plusieurs bonnes pratiques pour garantir efficacité et fiabilité. Tout d'abord, choisissez l'environnement de déploiement qui correspond à vos besoins : cloud, edge ou local. Optimisez votre modèle grâce à des techniques telles que l'élagage, la quantification et la distillation de connaissances pour un déploiement efficace dans des environnements à ressources limitées. Envisagez d'utiliser la conteneurisation avec Docker pour assurer la cohérence entre les différents environnements. Enfin, assurez-vous que la cohérence des données et les étapes de prétraitement s'alignent sur la phase d'entraînement pour maintenir les performances. Vous pouvez également vous référer aux options de déploiement de modèles pour des directives plus détaillées.

Comment puis-je résoudre les problèmes de déploiement courants avec les modèles Ultralytics YOLO26 ?

Le dépannage des problèmes de déploiement peut être décomposé en quelques étapes clés. Si la précision de votre modèle diminue après le déploiement, vérifiez la cohérence des données, validez les étapes de prétraitement et assurez-vous que l'environnement matériel/logiciel correspond à ce que vous avez utilisé pendant la formation. Pour les temps d'inférence lents, effectuez des exécutions d'échauffement, optimisez votre moteur d'inférence, utilisez le traitement asynchrone et profilez votre pipeline d'inférence. Consultez le guide de dépannage des problèmes de déploiement pour obtenir un guide détaillé sur ces meilleures pratiques.

Comment l'optimisation d'Ultralytics YOLO26 améliore-t-elle les performances des modèles sur les appareils edge ?

L'optimisation des modèles Ultralytics YOLO26 pour les appareils edge implique l'utilisation de techniques telles que l'élagage pour réduire la taille du modèle, la quantification pour convertir les poids en une précision inférieure, et la distillation de connaissances pour entraîner des modèles plus petits qui imitent les plus grands. Ces techniques garantissent que le modèle fonctionne efficacement sur des appareils dotés d'une puissance de calcul limitée. Des outils comme TensorFlow Lite et NVIDIA Jetson sont particulièrement utiles pour ces optimisations. Apprenez-en davantage sur ces techniques dans notre section sur l'optimisation des modèles.

Quelles sont les considérations de sécurité pour le déploiement de modèles de machine learning avec Ultralytics YOLO26 ?

La sécurité est primordiale lors du déploiement de modèles d'apprentissage automatique. Assurez une transmission sécurisée des données en utilisant des protocoles de chiffrement tels que TLS. Mettez en œuvre des contrôles d'accès robustes, y compris une authentification forte et un contrôle d'accès basé sur les rôles (RBAC). Les techniques d'obfuscation de modèle, telles que le chiffrement des paramètres du modèle et la diffusion de modèles dans un environnement sécurisé comme un environnement d'exécution de confiance (TEE), offrent une protection supplémentaire. Pour des pratiques détaillées, consultez les considérations de sécurité.

Comment choisir l'environnement de déploiement adapté à mon modèle Ultralytics YOLO26 ?

Le choix de l'environnement de déploiement optimal pour votre modèle Ultralytics YOLO26 dépend des besoins spécifiques de votre application. Le déploiement cloud offre évolutivité et facilité d'accès, ce qui le rend idéal pour les applications avec de grands volumes de données. Le déploiement edge est préférable pour les applications à faible latence nécessitant des réponses en temps réel, en utilisant des outils comme TensorFlow Lite. Le déploiement local convient aux scénarios exigeant une confidentialité et un contrôle stricts des données. Pour un aperçu complet de chaque environnement, consultez notre section sur le choix d'un environnement de déploiement.