تصدير TFLite و ONNX و CoreML و TensorRT

📚 يشرح هذا الدليل كيفية تصدير نموذج YOLOv5 🚀 مُدرَّب من PyTorch إلى تنسيقات نشر متنوعة بما في ذلك ONNX و TensorRT و CoreML والمزيد.

قبل أن تبدأ

استنساخ المستودع وتثبيت requirements.txt في بيئة Python>=3.8.0، بما في ذلك PyTorch>=1.8. يتم تنزيل النماذج و مجموعات البيانات تلقائيًا من أحدث إصدار YOLOv5.

git clone https://github.com/ultralytics/yolov5 # clone

cd yolov5

pip install -r requirements.txt # install

ل TensorRT مثال على التصدير (يتطلب وحدة معالجة الرسوميات GPU)، راجع Colab الخاص بنا دفتر ملاحظات قسم الملحق.

تنسيقات التصدير المدعومة

يتم دعم استدلال YOLOv5 رسميًا بـ 12 تنسيقًا:

نصائح لتحسين الأداء

- يمكنك التصدير إلى ONNX أو OpenVINO للحصول على تسريع يصل إلى 3x لوحدة المعالجة المركزية CPU. راجع معايير وحدة المعالجة المركزية CPU.

- يمكنك التصدير إلى TensorRT للحصول على تسريع يصل إلى 5x لوحدة معالجة الرسوميات GPU. راجع معايير وحدة معالجة الرسوميات GPU.

| التنسيق | export.py --include | النموذج |

|---|---|---|

| PyTorch | - | yolov5s.pt |

| TorchScript | torchscript | yolov5s.torchscript |

| ONNX | onnx | yolov5s.onnx |

| OpenVINO | openvino | yolov5s_openvino_model/ |

| TensorRT | engine | yolov5s.engine |

| CoreML | coreml | yolov5s.mlmodel |

| TensorFlow SavedModel | saved_model | yolov5s_saved_model/ |

| TensorFlow GraphDef | pb | yolov5s.pb |

| TensorFlow Lite | tflite | yolov5s.tflite |

| TensorFlow Edge TPU | edgetpu | yolov5s_edgetpu.tflite |

| TensorFlow.js | tfjs | yolov5s_web_model/ |

| PaddlePaddle | paddle | yolov5s_paddle_model/ |

المعايير

يتم تشغيل المعايير أدناه على Colab Pro باستخدام دفتر البرنامج التعليمي YOLOv5 . لإعادة الإنتاج:

python benchmarks.py --weights yolov5s.pt --imgsz 640 --device 0

Colab Pro V100 GPU

benchmarks: weights=/content/yolov5/yolov5s.pt, imgsz=640, batch_size=1, data=/content/yolov5/data/coco128.yaml, device=0, half=False, test=False

Checking setup...

YOLOv5 🚀 v6.1-135-g7926afc torch 1.10.0+cu111 CUDA:0 (Tesla V100-SXM2-16GB, 16160MiB)

Setup complete ✅ (8 CPUs, 51.0 GB RAM, 46.7/166.8 GB disk)

Benchmarks complete (458.07s)

Format mAP@0.5:0.95 Inference time (ms)

0 PyTorch 0.4623 10.19

1 TorchScript 0.4623 6.85

2 ONNX 0.4623 14.63

3 OpenVINO NaN NaN

4 TensorRT 0.4617 1.89

5 CoreML NaN NaN

6 TensorFlow SavedModel 0.4623 21.28

7 TensorFlow GraphDef 0.4623 21.22

8 TensorFlow Lite NaN NaN

9 TensorFlow Edge TPU NaN NaN

10 TensorFlow.js NaN NaN

Colab Pro CPU

benchmarks: weights=/content/yolov5/yolov5s.pt, imgsz=640, batch_size=1, data=/content/yolov5/data/coco128.yaml, device=cpu, half=False, test=False

Checking setup...

YOLOv5 🚀 v6.1-135-g7926afc torch 1.10.0+cu111 CPU

Setup complete ✅ (8 CPUs, 51.0 GB RAM, 41.5/166.8 GB disk)

Benchmarks complete (241.20s)

Format mAP@0.5:0.95 Inference time (ms)

0 PyTorch 0.4623 127.61

1 TorchScript 0.4623 131.23

2 ONNX 0.4623 69.34

3 OpenVINO 0.4623 66.52

4 TensorRT NaN NaN

5 CoreML NaN NaN

6 TensorFlow SavedModel 0.4623 123.79

7 TensorFlow GraphDef 0.4623 121.57

8 TensorFlow Lite 0.4623 316.61

9 TensorFlow Edge TPU NaN NaN

10 TensorFlow.js NaN NaN

تصدير نموذج YOLOv5 مُدرَّب

يقوم هذا الأمر بتصدير نموذج YOLOv5s المدرب مسبقًا إلى تنسيقات TorchScript و ONNX. yolov5s.pt هو النموذج 'الصغير'، وهو ثاني أصغر نموذج متاح. الخيارات الأخرى هي yolov5n.pt, yolov5m.pt, yolov5l.pt و yolov5x.pt، جنبًا إلى جنب مع نظائرها P6، أي. yolov5s6.pt أو نقطة تفتيش تدريب مخصصة خاصة بك، على سبيل المثال runs/exp/weights/best.pt. للحصول على تفاصيل حول جميع النماذج المتاحة، يرجى الاطلاع على README الخاص بنا جدول.

python export.py --weights yolov5s.pt --include torchscript onnx

نصيحة

إضافة --half لتصدير النماذج بتنسيق FP16 half الدقة لأحجام ملفات أصغر.

الناتج:

export: data=data/coco128.yaml, weights=['yolov5s.pt'], imgsz=[640, 640], batch_size=1, device=cpu, half=False, inplace=False, train=False, keras=False, optimize=False, int8=False, dynamic=False, simplify=False, opset=12, verbose=False, workspace=4, nms=False, agnostic_nms=False, topk_per_class=100, topk_all=100, iou_thres=0.45, conf_thres=0.25, include=['torchscript', 'onnx']

YOLOv5 🚀 v6.2-104-ge3e5122 Python-3.8.0 torch-1.12.1+cu113 CPU

Downloading https://github.com/ultralytics/yolov5/releases/download/v6.2/yolov5s.pt to yolov5s.pt...

100% 14.1M/14.1M [00:00<00:00, 274MB/s]

Fusing layers...

YOLOv5s summary: 213 layers, 7225885 parameters, 0 gradients

PyTorch: starting from yolov5s.pt with output shape (1, 25200, 85) (14.1 MB)

TorchScript: starting export with torch 1.12.1+cu113...

TorchScript: export success ✅ 1.7s, saved as yolov5s.torchscript (28.1 MB)

ONNX: starting export with onnx 1.12.0...

ONNX: export success ✅ 2.3s, saved as yolov5s.onnx (28.0 MB)

Export complete (5.5s)

Results saved to /content/yolov5

Detect: python detect.py --weights yolov5s.onnx

Validate: python val.py --weights yolov5s.onnx

PyTorch Hub: model = torch.hub.load('ultralytics/yolov5', 'custom', 'yolov5s.onnx')

Visualize: https://netron.app/

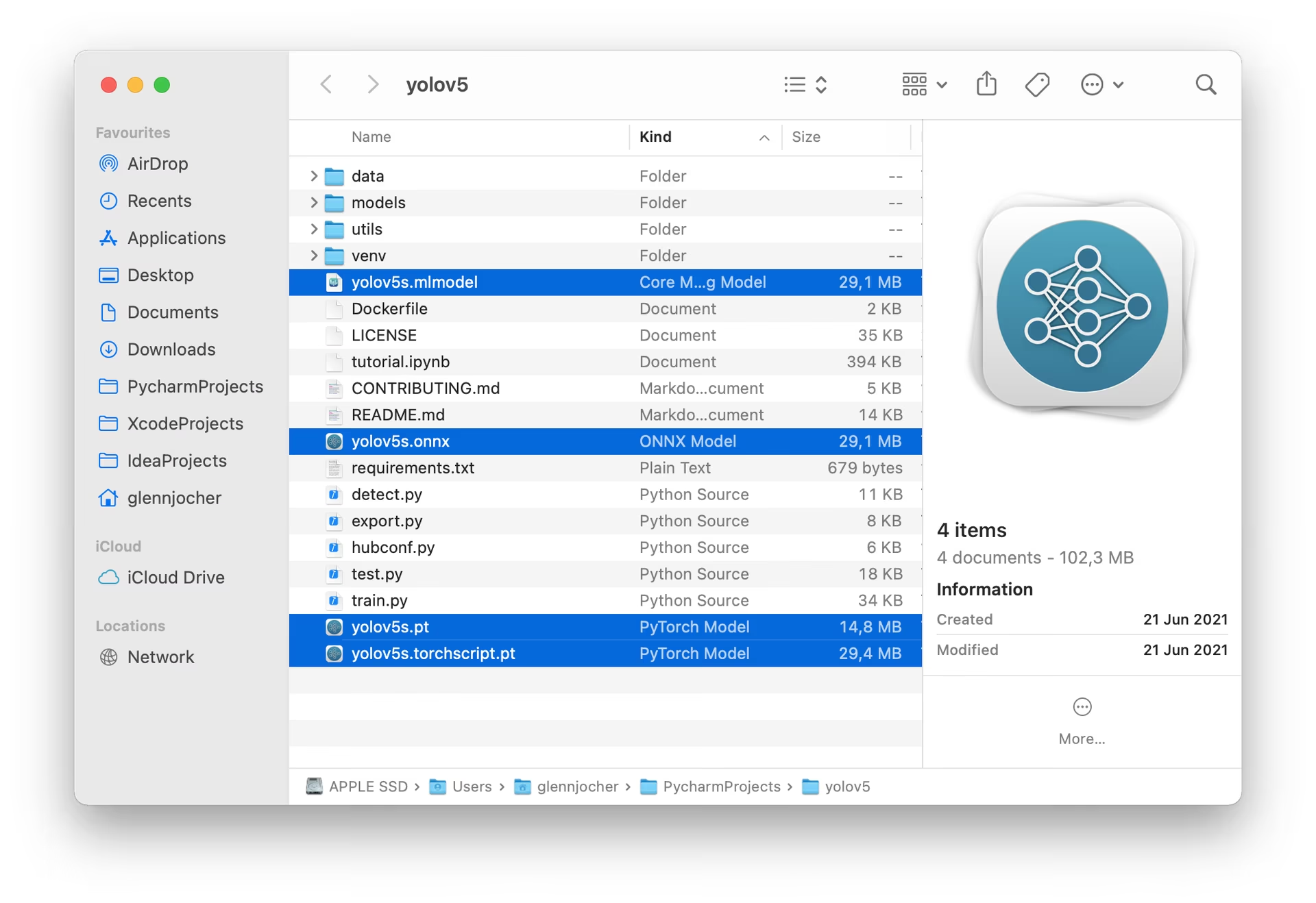

سيتم حفظ النماذج الثلاثة التي تم تصديرها بجانب نموذج PyTorch الأصلي:

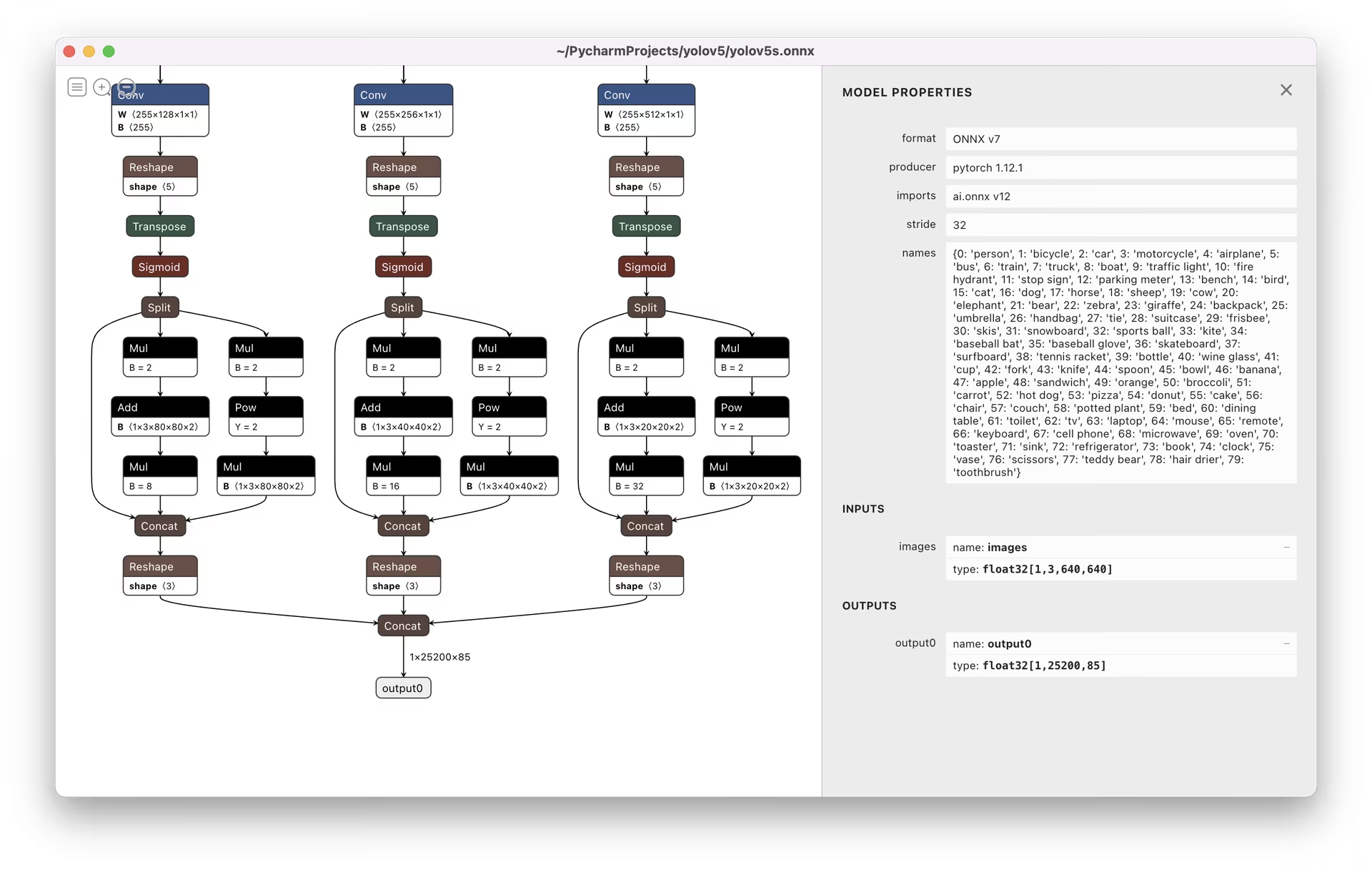

يوصى باستخدام عارض Netron لتصور النماذج المصدرة:

أمثلة على استخدام النموذج المصدر

detect.py تشغيل الاستدلال على النماذج التي تم تصديرها:

python detect.py --weights yolov5s.pt # PyTorch

python detect.py --weights yolov5s.torchscript # TorchScript

python detect.py --weights yolov5s.onnx # ONNX Runtime or OpenCV DNN with dnn=True

python detect.py --weights yolov5s_openvino_model # OpenVINO

python detect.py --weights yolov5s.engine # TensorRT

python detect.py --weights yolov5s.mlmodel # CoreML (macOS only)

python detect.py --weights yolov5s_saved_model # TensorFlow SavedModel

python detect.py --weights yolov5s.pb # TensorFlow GraphDef

python detect.py --weights yolov5s.tflite # TensorFlow Lite

python detect.py --weights yolov5s_edgetpu.tflite # TensorFlow Edge TPU

python detect.py --weights yolov5s_paddle_model # PaddlePaddle

val.py تشغيل التحقق من الصحة على النماذج التي تم تصديرها:

python val.py --weights yolov5s.pt # PyTorch

python val.py --weights yolov5s.torchscript # TorchScript

python val.py --weights yolov5s.onnx # ONNX Runtime or OpenCV DNN with dnn=True

python val.py --weights yolov5s_openvino_model # OpenVINO

python val.py --weights yolov5s.engine # TensorRT

python val.py --weights yolov5s.mlmodel # CoreML (macOS Only)

python val.py --weights yolov5s_saved_model # TensorFlow SavedModel

python val.py --weights yolov5s.pb # TensorFlow GraphDef

python val.py --weights yolov5s.tflite # TensorFlow Lite

python val.py --weights yolov5s_edgetpu.tflite # TensorFlow Edge TPU

python val.py --weights yolov5s_paddle_model # PaddlePaddle

استخدم PyTorch Hub مع نماذج YOLOv5 المصدرة:

import torch

# Model

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s.pt")

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s.torchscript") # TorchScript

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s.onnx") # ONNX Runtime

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s_openvino_model") # OpenVINO

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s.engine") # TensorRT

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s.mlmodel") # CoreML (macOS Only)

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s_saved_model") # TensorFlow SavedModel

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s.pb") # TensorFlow GraphDef

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s.tflite") # TensorFlow Lite

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s_edgetpu.tflite") # TensorFlow Edge TPU

model = torch.hub.load("ultralytics/yolov5", "custom", "yolov5s_paddle_model") # PaddlePaddle

# Images

img = "https://ultralytics.com/images/zidane.jpg" # or file, Path, PIL, OpenCV, numpy, list

# Inference

results = model(img)

# Results

results.print() # or .show(), .save(), .crop(), .pandas(), etc.

الاستدلال OpenCV DNN

OpenCV الاستدلال باستخدام نماذج ONNX:

python export.py --weights yolov5s.pt --include onnx

python detect.py --weights yolov5s.onnx --dnn # detect

python val.py --weights yolov5s.onnx --dnn # validate

الاستدلال بلغة ++C

YOLOv5 OpenCV DNN C++ أمثلة الاستدلال على نموذج ONNX المصدر:

- https://github.com/Hexmagic/ONNX-yolov5/blob/master/src/test.cpp

- https://github.com/doleron/yolov5-opencv-cpp-python

أمثلة على استدلال ++YOLOv5 OpenVINO C:

- https://github.com/dacquaviva/yolov5-openvino-cpp-python

- https://github.com/UNeedCryDear/yolov5-seg-opencv-dnn-cpp

الاستدلال في متصفح الويب TensorFlow.js

البيئات المدعومة

توفر Ultralytics مجموعة من البيئات الجاهزة للاستخدام، كل منها مثبت مسبقًا بالتبعيات الأساسية مثل CUDA و CUDNN و Python و PyTorch، لبدء مشاريعك.

- دفاتر ملاحظات GPU مجانية:

- Google Cloud: دليل البدء السريع في GCP

- Amazon: دليل البدء السريع في AWS

- Azure: دليل البدء السريع في AzureML

- Docker: دليل البدء السريع لـ Docker

حالة المشروع

تشير هذه الشارة إلى أن جميع اختبارات التكامل المستمر (CI) لـ YOLOv5 GitHub Actions قد اجتازت بنجاح. تتحقق اختبارات CI هذه بدقة من وظائف وأداء YOLOv5 عبر مختلف الجوانب الرئيسية: التدريب، التحقق، الاستدلال، التصدير، و المعايير. وهي تضمن تشغيلًا متسقًا وموثوقًا على أنظمة macOS و Windows و Ubuntu، مع إجراء الاختبارات كل 24 ساعة وعند كل commit جديد.