YOLOv5 クイックスタート 🚀

Ultralytics YOLOv5で、リアルタイム物体検出のダイナミックな領域への旅を始めましょう!このガイドは、YOLOv5をマスターすることを目指すAI愛好家や専門家にとって、包括的な出発点となるように作成されています。初期設定から高度なトレーニングテクニックまで、すべてを網羅しています。このガイドを終える頃には、最先端の深層学習手法を使用して、YOLOv5を自信を持ってプロジェクトに実装するための知識が得られます。エンジンを点火して、YOLOv5に飛び込みましょう!

インストール

YOLOv5リポジトリをクローンし、環境を確立して、起動の準備をしてください。これにより、必要な要件がすべてインストールされます。Python>=3.8.0とPyTorch>=1.8が離陸の準備ができていることを確認してください。これらの基本的なツールは、YOLOv5を効果的に実行するために不可欠です。

git clone https://github.com/ultralytics/yolov5 # clone repository

cd yolov5

pip install -r requirements.txt # install dependencies

PyTorch Hubを使用した推論

PyTorch Hub推論におけるYOLOv5のシンプルさを体験してください。ここでは、モデルが最新のYOLOv5 リリースからシームレスにダウンロードされます。この方法は、PyTorchの力を活用してモデルのロードと実行を容易にし、予測を簡単に取得できるようにします。

import torch

# Model loading

model = torch.hub.load("ultralytics/yolov5", "yolov5s") # Can be 'yolov5n' - 'yolov5x6', or 'custom'

# Inference on images

img = "https://ultralytics.com/images/zidane.jpg" # Can be a file, Path, PIL, OpenCV, numpy, or list of images

# Run inference

results = model(img)

# Display results

results.print() # Other options: .show(), .save(), .crop(), .pandas(), etc. Explore these in the Predict mode documentation.

detect.pyによる推論

Harness detect.py 汎用性のために 推論 さまざまなソースから自動的に取得します。 モデル 最新のYOLOv5から リリース そして、簡単に結果を保存します。このスクリプトは、コマンドラインでの使用や、YOLOv5をより大規模なシステムに統合するのに最適で、画像、ビデオ、ディレクトリ、ウェブカメラ、さらにはなどの入力をサポートします。 ライブストリーム.

python detect.py --weights yolov5s.pt --source 0 # webcam

python detect.py --weights yolov5s.pt --source image.jpg # image

python detect.py --weights yolov5s.pt --source video.mp4 # video

python detect.py --weights yolov5s.pt --source screen # screenshot

python detect.py --weights yolov5s.pt --source path/ # directory

python detect.py --weights yolov5s.pt --source list.txt # list of images

python detect.py --weights yolov5s.pt --source list.streams # list of streams

python detect.py --weights yolov5s.pt --source 'path/*.jpg' # glob pattern

python detect.py --weights yolov5s.pt --source 'https://youtu.be/LNwODJXcvt4' # YouTube video

python detect.py --weights yolov5s.pt --source 'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream

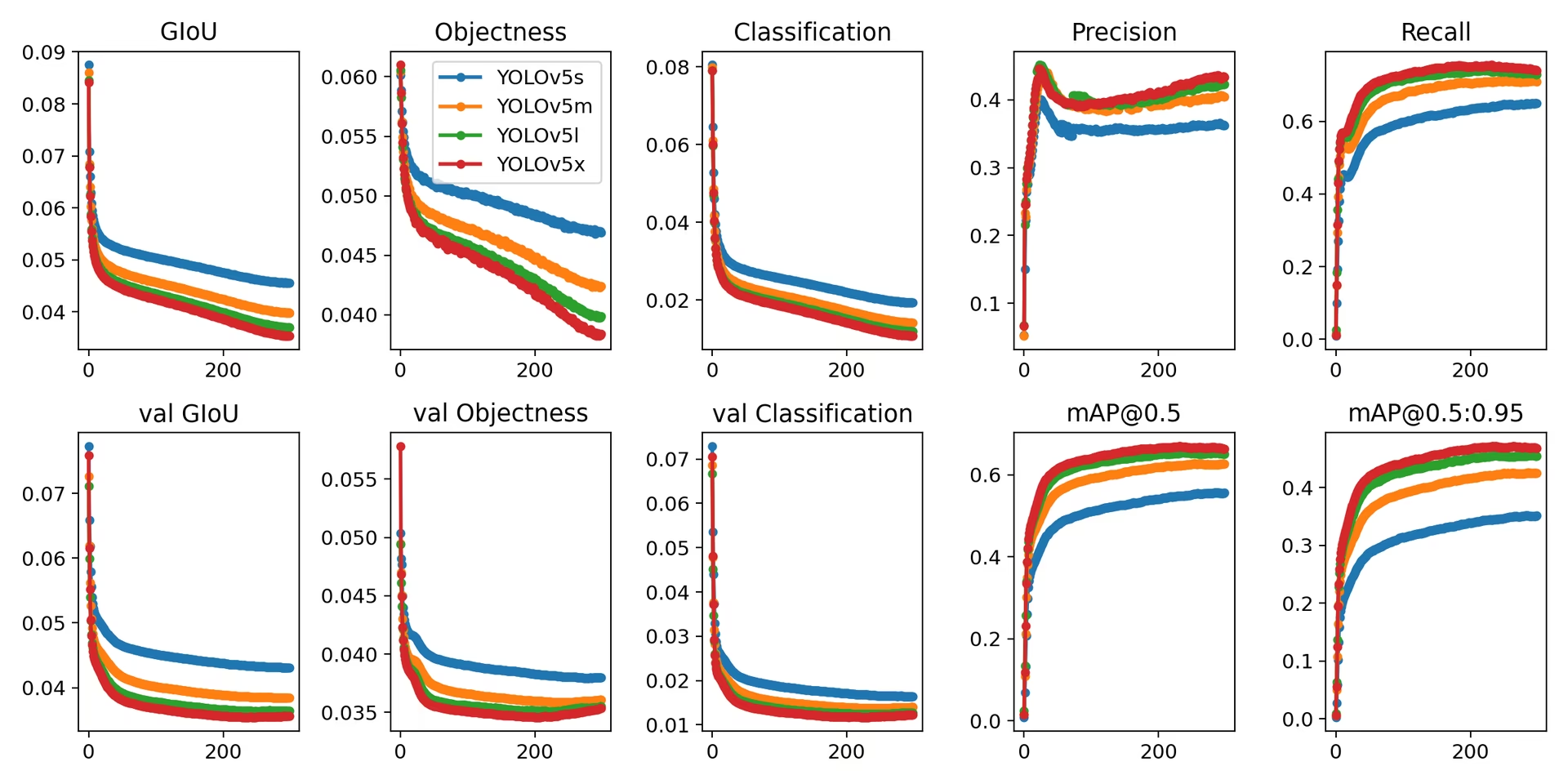

学習

YOLOv5を複製する COCOデータセット に従ってベンチマークを行います。 トレーニング手順 下記。必要な モデル および データセット (例えば coco128.yaml または完全な coco.yaml) は、最新の YOLOv5 から直接取得されます。 リリースは、V100上でYOLOv5n/s/m/l/xを学習させる GPU 通常、それぞれ1/2/4/6/8日かかります(ただし、 マルチGPUトレーニング セットアップはより高速に動作します)。可能な限り最高のパフォーマンスを実現するために、 --batch-size または、以下を使用します。 --batch-size -1 YOLOv5の場合 AutoBatch 最適なものを自動的に見つける機能 バッチサイズは、V100-16GB GPUに最適なバッチサイズです。詳細については、 構成ガイド モデル構成ファイルの詳細については( *.yaml)。

# Train YOLOv5n on COCO128 for 3 epochs

python train.py --data coco128.yaml --epochs 3 --weights yolov5n.pt --batch-size 128

# Train YOLOv5s on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5s.yaml --batch-size 64

# Train YOLOv5m on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5m.yaml --batch-size 40

# Train YOLOv5l on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5l.yaml --batch-size 24

# Train YOLOv5x on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5x.yaml --batch-size 16

結論として、YOLOv5は物体detectのための最先端ツールであるだけでなく、視覚的理解を通じて世界との相互作用を変革する機械学習の力を証明するものです。このガイドを進め、YOLOv5をプロジェクトに適用し始めるにあたり、あなたはコンピュータービジョンにおいて目覚ましい偉業を達成できる技術革命の最前線にいることを忘れないでください。さらなる知見や同志からのサポートが必要な場合は、開発者や研究者の活発なコミュニティが集まる弊社のGitHubリポジトリにご参加ください。コード不要のデータセット管理やモデルトレーニングのためのUltralytics Platformのような追加リソースを探索したり、実際のアプリケーションやインスピレーションについては弊社のソリューションページをご覧ください。探求を続け、革新を続け、YOLOv5の驚異を楽しんでください。Happy detect! 🌠🔍