YOLOv5 퀵스타트 🚀

Ultralytics YOLOv5와 함께 실시간 객체 감지의 역동적인 영역으로 여정을 시작하세요! 이 가이드는 YOLOv5를 마스터하려는 AI 애호가와 전문가를 위한 포괄적인 시작점 역할을 하도록 제작되었습니다. 초기 설정부터 고급 학습 기술까지 모든 것을 다룹니다. 이 가이드가 끝나면 최첨단 딥 러닝 방법을 사용하여 YOLOv5를 프로젝트에 자신 있게 구현할 수 있는 지식을 갖게 될 것입니다. 엔진에 불을 붙이고 YOLOv5로 날아오르세요!

설치

YOLOv5 저장소를 복제하고 환경을 설정하여 시작을 준비합니다. 이렇게 하면 필요한 모든 요구 사항이 설치됩니다. Python>=3.8.0 및 PyTorch>=1.8이 이륙 준비가 되었는지 확인하십시오. 이러한 기본 도구는 YOLOv5를 효과적으로 실행하는 데 중요합니다.

git clone https://github.com/ultralytics/yolov5 # clone repository

cd yolov5

pip install -r requirements.txt # install dependencies

PyTorch Hub를 사용한 추론

PyTorch Hub 추론을 통해 YOLOv5의 간편함을 경험해 보세요. 여기서 모델은 최신 YOLOv5 릴리스에서 원활하게 다운로드됩니다. 이 방법은 쉬운 모델 로딩 및 실행을 위해 PyTorch의 강력한 기능을 활용하여 예측을 간단하게 수행할 수 있도록 합니다.

import torch

# Model loading

model = torch.hub.load("ultralytics/yolov5", "yolov5s") # Can be 'yolov5n' - 'yolov5x6', or 'custom'

# Inference on images

img = "https://ultralytics.com/images/zidane.jpg" # Can be a file, Path, PIL, OpenCV, numpy, or list of images

# Run inference

results = model(img)

# Display results

results.print() # Other options: .show(), .save(), .crop(), .pandas(), etc. Explore these in the Predict mode documentation.

detect.py를 사용한 추론

다양한 소스에서 다재다능한 추론을 위해 detect.py 다재다능한 추론 다양한 소스에서 자동으로 가져옵니다. 모델 최신 YOLOv5 릴리스 결과를 쉽게 저장합니다. 이 스크립트는 명령줄 사용에 적합하며 YOLOv5를 이미지, 비디오, 디렉토리, 웹캠, 심지어 실시간 스트림.

python detect.py --weights yolov5s.pt --source 0 # webcam

python detect.py --weights yolov5s.pt --source image.jpg # image

python detect.py --weights yolov5s.pt --source video.mp4 # video

python detect.py --weights yolov5s.pt --source screen # screenshot

python detect.py --weights yolov5s.pt --source path/ # directory

python detect.py --weights yolov5s.pt --source list.txt # list of images

python detect.py --weights yolov5s.pt --source list.streams # list of streams

python detect.py --weights yolov5s.pt --source 'path/*.jpg' # glob pattern

python detect.py --weights yolov5s.pt --source 'https://youtu.be/LNwODJXcvt4' # YouTube video

python detect.py --weights yolov5s.pt --source 'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream

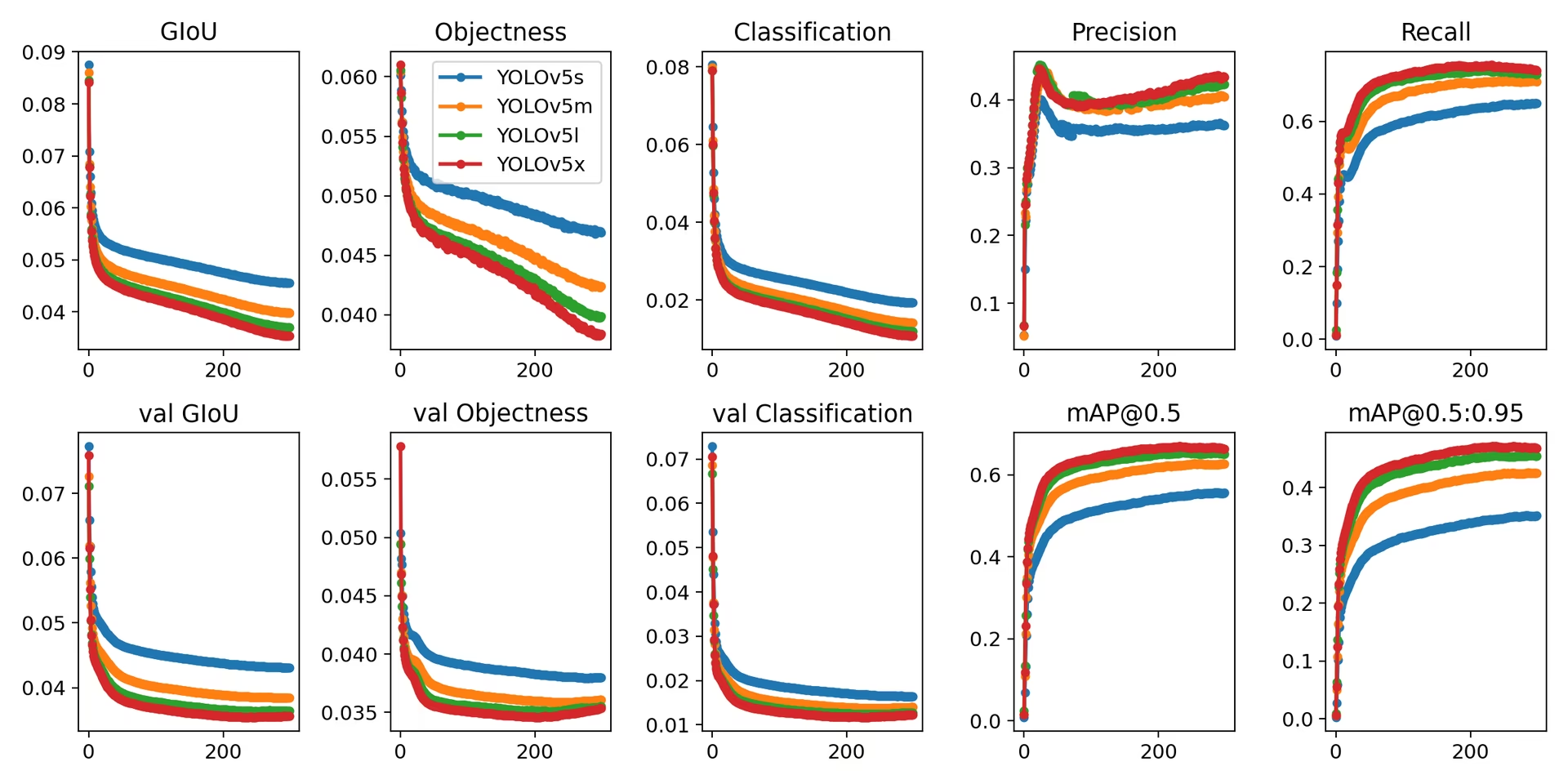

훈련

아래 지침에 따라 YOLOv5 COCO 데이터셋 다음을 따라 벤치마크 학습 지침 아래에 필요한 모델 및 데이터 세트 (예: coco128.yaml 또는 전체 coco.yaml) 최신 YOLOv5에서 직접 가져옵니다. 릴리스V100에서 YOLOv5n/s/m/l/x를 학습합니다. GPU 일반적으로 각각 1/2/4/6/8일이 소요됩니다(참고: 다중 GPU 학습 설정은 더 빠른 속도를 제공합니다.) 가능한 가장 높은 사양을 사용하여 성능을 극대화하거나, --batch-size 또는 다음을 사용하십시오. --batch-size -1 YOLOv5를 위한 AutoBatch 기능은 최적의 값을 자동으로 찾습니다. 배치 크기다음 배치 크기는 V100-16GB GPU에 적합합니다. 자세한 내용은 다음을 참조하십시오. 구성 가이드 모델 구성 파일에 대한 자세한 내용은 (*.yaml)입니다.

# Train YOLOv5n on COCO128 for 3 epochs

python train.py --data coco128.yaml --epochs 3 --weights yolov5n.pt --batch-size 128

# Train YOLOv5s on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5s.yaml --batch-size 64

# Train YOLOv5m on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5m.yaml --batch-size 40

# Train YOLOv5l on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5l.yaml --batch-size 24

# Train YOLOv5x on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5x.yaml --batch-size 16

결론적으로, YOLOv5는 객체 detect를 위한 최첨단 도구일 뿐만 아니라 시각적 이해를 통해 우리가 세상과 상호작용하는 방식을 변화시키는 머신러닝의 힘을 증명하는 것입니다. 이 가이드를 따라가며 YOLOv5를 프로젝트에 적용하기 시작할 때, 여러분이 컴퓨터 비전 분야에서 놀라운 업적을 달성할 수 있는 기술 혁명의 선두에 서 있다는 것을 기억하십시오. 동료 비전가들의 추가적인 통찰력이나 지원이 필요하다면, 개발자와 연구자들로 이루어진 활기찬 커뮤니티의 본거지인 저희 GitHub 저장소로 초대합니다. 코드 없이 데이터셋 관리 및 모델 학습을 위한 Ultralytics Platform과 같은 추가 리소스를 탐색하거나, 실제 애플리케이션 및 영감을 얻기 위해 저희 솔루션 페이지를 확인하십시오. 계속 탐색하고, 계속 혁신하며, YOLOv5의 경이로움을 즐기십시오. 즐거운 detect 되세요! 🌠🔍