ImageNet 데이터셋

ImageNet은 시각적 객체 인식 연구에 사용하도록 설계된 주석이 달린 이미지의 대규모 데이터베이스입니다. 1,400만 개가 넘는 이미지를 포함하고 있으며 각 이미지는 WordNet synset을 사용하여 주석이 달려 있어 컴퓨터 비전 작업에서 딥 러닝 모델을 훈련하는 데 사용할 수 있는 가장 광범위한 리소스 중 하나입니다.

ImageNet 사전 학습 모델

| 모델 | 크기 (픽셀) | acc top1 | acc top5 | 속도 CPU ONNX (ms) | 속도 T4 TensorRT10 (ms) | 파라미터 (M) | FLOPs (B) at 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

주요 기능

- ImageNet은 수천 개의 객체 범주에 걸쳐 1,400만 개 이상의 고해상도 이미지를 포함합니다.

- 이 데이터 세트는 WordNet 계층 구조에 따라 구성되며, 각 synset은 카테고리를 나타냅니다.

- ImageNet은 컴퓨터 비전 분야에서 학습 및 벤치마킹에 널리 사용되며, 특히 이미지 분류 및 객체 detect 작업에 사용됩니다.

- 연례 ImageNet 대규모 시각 인식 챌린지 (ILSVRC)는 컴퓨터 비전 연구 발전에 중요한 역할을 해왔습니다.

데이터 세트 구조

ImageNet 데이터셋은 WordNet 계층 구조를 사용하여 구성됩니다. 계층 구조의 각 노드는 카테고리를 나타내며, 각 카테고리는 synset(동의어 집합)으로 설명됩니다. ImageNet의 이미지는 하나 이상의 synset으로 주석 처리되어 다양한 객체와 그 관계를 인식하는 모델을 훈련하기 위한 풍부한 리소스를 제공합니다.

ImageNet Large Scale Visual Recognition Challenge (ILSVRC)

연례 ImageNet 대규모 시각 인식 챌린지 (ILSVRC)는 컴퓨터 비전 분야에서 중요한 행사였습니다. 이는 연구자와 개발자가 표준화된 평가 지표를 사용하여 대규모 데이터셋에서 자신들의 알고리즘과 모델을 평가할 수 있는 플랫폼을 제공했습니다. ILSVRC는 이미지 분류, 객체 detect 및 기타 컴퓨터 비전 작업을 위한 딥러닝 모델 개발에 상당한 발전을 가져왔습니다.

응용 분야

ImageNet 데이터셋은 이미지 분류, 객체 detect 및 객체 위치 파악과 같은 다양한 컴퓨터 비전 작업에서 딥러닝 모델을 훈련하고 평가하는 데 널리 사용됩니다. AlexNet, VGG, ResNet과 같은 일부 인기 있는 딥러닝 아키텍처는 ImageNet 데이터셋을 사용하여 개발되고 벤치마킹되었습니다.

사용법

224x224 이미지 크기로 ImageNet 데이터셋에서 딥러닝 모델을 100 epoch 동안 훈련하려면 다음 코드 스니펫을 사용할 수 있습니다. 사용 가능한 인수의 전체 목록은 모델 훈련 페이지를 참조하십시오.

훈련 예제

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-cls.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="imagenet", epochs=100, imgsz=224)

# Start training from a pretrained *.pt model

yolo classify train data=imagenet model=yolo26n-cls.pt epochs=100 imgsz=224

샘플 이미지 및 주석

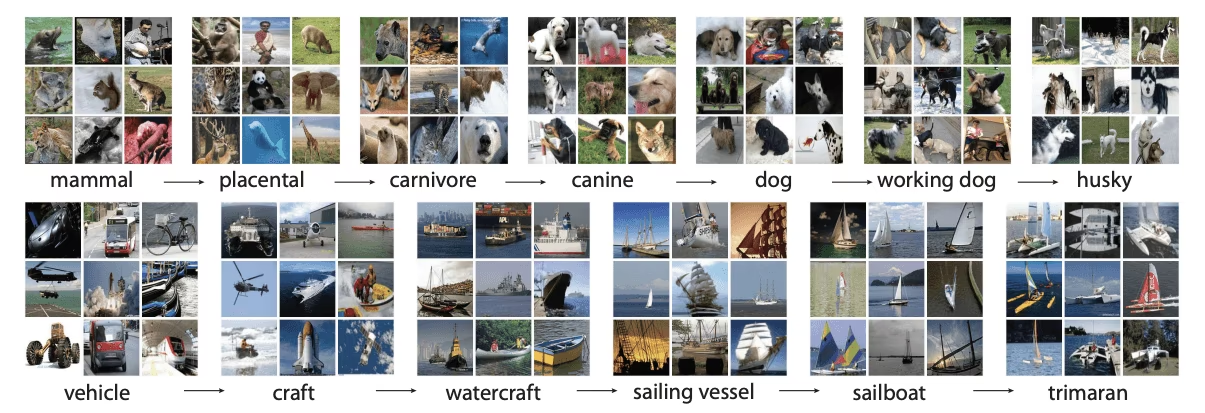

ImageNet 데이터셋은 수천 개의 객체 카테고리에 걸쳐 고해상도 이미지를 포함하며, 컴퓨터 비전 모델을 훈련하고 평가하기 위한 다양하고 광범위한 데이터셋을 제공합니다. 다음은 데이터셋의 이미지 예시입니다.

이 예시는 ImageNet 데이터셋에 있는 이미지의 다양성과 복잡성을 보여주며, 강력한 컴퓨터 비전 모델을 훈련하기 위한 다양한 데이터셋의 중요성을 강조합니다.

인용 및 감사의 말씀

연구 또는 개발 작업에서 ImageNet 데이터셋을 사용하는 경우, 다음 논문을 인용해 주십시오.

@article{ILSVRC15,

author = {Olga Russakovsky and Jia Deng and Hao Su and Jonathan Krause and Sanjeev Satheesh and Sean Ma and Zhiheng Huang and Andrej Karpathy and Aditya Khosla and Michael Bernstein and Alexander C. Berg and Li Fei-Fei},

title={ImageNet Large Scale Visual Recognition Challenge},

year={2015},

journal={International Journal of Computer Vision (IJCV)},

volume={115},

number={3},

pages={211-252}

}

Olga Russakovsky, Jia Deng, Li Fei-Fei가 이끄는 ImageNet 팀이 머신러닝 및 컴퓨터 비전 연구 커뮤니티를 위한 귀중한 리소스인 ImageNet 데이터셋을 생성하고 유지 관리해 주신 것에 감사드립니다. ImageNet 데이터셋 및 그 생성자에 대한 자세한 내용은 ImageNet 웹사이트를 방문하십시오.

FAQ

ImageNet 데이터셋이란 무엇이며 컴퓨터 비전에서 어떻게 사용됩니까?

ImageNet 데이터셋은 WordNet synset을 사용하여 분류된 1,400만 개 이상의 고해상도 이미지로 구성된 대규모 데이터베이스입니다. 이는 이미지 분류 및 객체 detect를 포함한 시각 객체 인식 연구에 광범위하게 사용됩니다. 데이터셋의 주석과 방대한 양은 딥러닝 모델 훈련을 위한 풍부한 리소스를 제공합니다. 특히 AlexNet, VGG, ResNet과 같은 모델은 ImageNet을 사용하여 훈련되고 벤치마킹되었으며, 이는 컴퓨터 비전 발전에 있어 ImageNet의 역할을 보여줍니다.

ImageNet 데이터셋에서 이미지 분류를 위해 사전 학습된 YOLO 모델을 어떻게 사용할 수 있습니까?

ImageNet 데이터셋에서 이미지 분류를 위해 사전 훈련된 Ultralytics YOLO 모델을 사용하려면 다음 단계를 따르십시오.

훈련 예제

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-cls.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="imagenet", epochs=100, imgsz=224)

# Start training from a pretrained *.pt model

yolo classify train data=imagenet model=yolo26n-cls.pt epochs=100 imgsz=224

더 자세한 학습 지침은 학습 페이지를 참조하세요.

제 ImageNet 데이터셋 프로젝트에 Ultralytics YOLO26 사전 훈련 모델을 왜 사용해야 하나요?

Ultralytics YOLO26 사전 훈련 모델은 다양한 컴퓨터 비전 작업에서 속도와 정확도 측면에서 최첨단 성능을 제공합니다. 예를 들어, YOLO26n-cls 모델은 70.0%의 top-1 정확도와 89.4%의 top-5 정확도를 가지며 실시간 애플리케이션에 최적화되어 있습니다. 사전 훈련 모델은 처음부터 훈련하는 데 필요한 컴퓨팅 리소스를 줄이고 개발 주기를 단축합니다. ImageNet 사전 훈련 모델 섹션에서 YOLO26 모델의 성능 지표에 대해 자세히 알아보세요.

ImageNet 데이터셋은 어떻게 구성되어 있으며 왜 중요합니까?

ImageNet 데이터셋은 WordNet 계층 구조를 사용하여 구성되며, 여기서 계층 구조의 각 노드는 synset(동의어 집합)으로 설명되는 카테고리를 나타냅니다. 이러한 구조는 상세한 주석을 가능하게 하여 다양한 객체를 인식하는 모델을 훈련하는 데 이상적입니다. ImageNet의 다양성과 풍부한 주석은 강력하고 일반화 가능한 딥러닝 모델을 개발하기 위한 귀중한 데이터셋으로 만듭니다. 이 구성에 대한 자세한 내용은 데이터셋 구조 섹션에서 확인할 수 있습니다.

ImageNet Large Scale Visual Recognition Challenge (ILSVRC)는 컴퓨터 비전에서 어떤 역할을 합니까?

연례 ImageNet 대규모 시각 인식 챌린지 (ILSVRC)는 대규모의 표준화된 데이터셋에서 알고리즘을 평가하기 위한 경쟁 플랫폼을 제공함으로써 컴퓨터 비전 발전을 이끄는 데 중추적인 역할을 해왔습니다. 이는 표준화된 평가 지표를 제공하여 이미지 분류, 객체 detect 및 이미지 segment와 같은 분야에서 혁신과 발전을 촉진합니다. 이 챌린지는 딥러닝 및 컴퓨터 비전 기술로 가능한 것의 한계를 지속적으로 확장해 왔습니다.