获得最佳YOLOv5训练结果的技巧

📚 本指南介绍了如何使用YOLOv5 🚀获得最佳的mAP和训练结果。

大多数情况下,无需更改模型或训练设置即可获得良好结果,前提是您的数据集足够大且标注良好。如果一开始没有获得良好结果,您可以采取一些步骤进行改进,但我们始终建议用户在考虑任何更改之前首先使用所有默认设置进行训练。这有助于建立性能基线并发现改进领域。

如果您对训练结果有疑问 我们建议您提供尽可能多的信息 如果您期望得到有用的响应,包括结果图(训练损失、验证损失、P、R、mAP)、PR 曲线, 混淆矩阵,训练马赛克、测试结果和数据集统计图像,例如 labels.png。所有这些都位于您的 project/name 目录,通常是 yolov5/runs/train/exp.

我们为希望在 YOLOv5 训练中获得最佳结果的用户整理了一份完整的指南,如下所示。

数据集

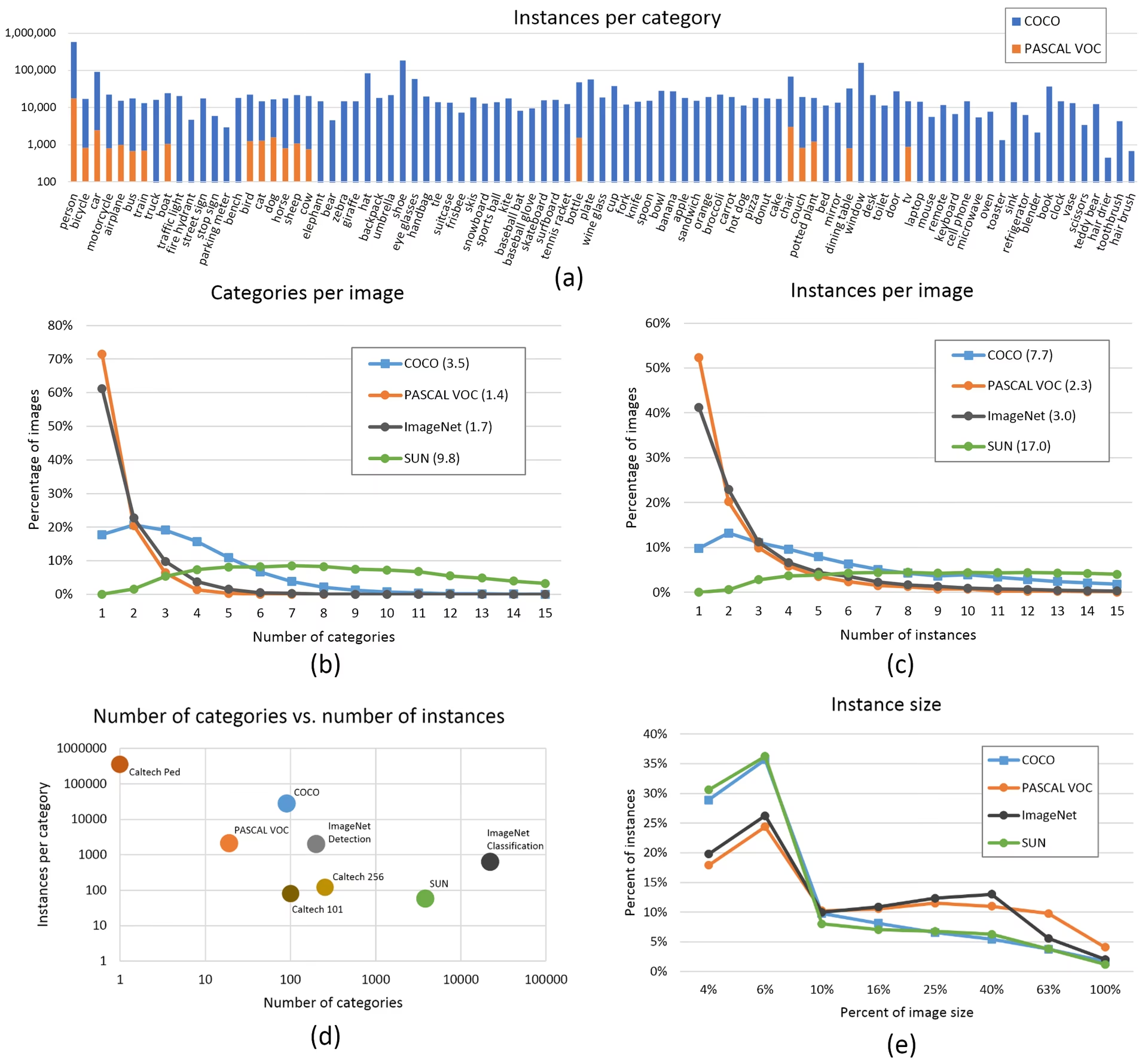

- 每个类别的图像数量。 建议每个类别 ≥ 1500 张图像

- 每个类别的实例数。 建议每个类别 ≥ 10000 个实例(已标注对象)

- 图像多样性。 必须代表部署环境。对于真实世界的用例,我们建议使用来自一天中不同时间、不同季节、不同天气、不同光照、不同角度、不同来源(在线抓取、本地收集、不同相机等)的图像。

- 标签一致性。所有图像中所有类别的所有实例都必须被标记。部分标记将不起作用。

- 标签准确性。标签必须紧密包围每个对象。对象与其边界框之间不应存在任何空间。不应有任何对象缺少标签。

- 训练/验证集划分原则。确保验证集和测试集图像绝不出现在训练集中,以避免过于乐观的指标。保持各划分之间类别分布相似。

- 标签验证。 查看

train_batch*.jpg在训练开始时验证您的标签是否正确显示,例如查看 示例 mosaic。 - 背景图像。背景图像是没有物体的图像,添加到数据集中以减少误报(FP)。我们建议使用大约 0-10% 的背景图像来帮助减少 FP(COCO 有 1000 张背景图像作为参考,占总数的 1%)。背景图像不需要标签。

模型选择

像 YOLOv5x 和 YOLOv5x6 这样更大的模型在几乎所有情况下都会产生更好的结果,但具有更多的参数,需要更多的 CUDA 内存来训练,并且运行速度较慢。对于 移动 部署,我们推荐 YOLOv5s/m;对于 云 部署,我们推荐 YOLOv5l/x。请参阅我们的 README 表格,以全面比较所有模型。

从预训练权重开始。 推荐用于中小型数据集(例如: VOC, VisDrone, GlobalWheat)。将模型名称传递给

--weights参数。模型会自动从以下位置下载 最新的 YOLOv5 版本.python train.py --data custom.yaml --weights yolov5s.pt python train.py --data custom.yaml --weights yolov5m.pt python train.py --data custom.yaml --weights yolov5l.pt python train.py --data custom.yaml --weights yolov5x.pt python train.py --data custom.yaml --weights custom_pretrained.pt从头开始。 推荐用于大型数据集(例如: COCO, Objects365, OIv6)。传入你感兴趣的模型架构 YAML,以及一个空的

--weights ''参数:python train.py --data custom.yaml --weights '' --cfg yolov5s.yaml python train.py --data custom.yaml --weights '' --cfg yolov5m.yaml python train.py --data custom.yaml --weights '' --cfg yolov5l.yaml python train.py --data custom.yaml --weights '' --cfg yolov5x.yaml

训练设置

在修改任何内容之前,首先使用默认设置进行训练,以建立性能基线。完整的 train.py 设置列表可以在 train.py 参数解析器中找到。

- Epochs. 从300个epochs开始。如果过早发生过拟合,则可以减少epochs。如果在300个epochs后没有发生过拟合,则训练更长时间,即600、1200等epochs。

- 图像大小。 COCO 以原生分辨率进行训练

--img 640,虽然由于数据集中存在大量小物体,但它可以受益于以更高的分辨率进行训练,例如--img 1280。如果有很多小物体,那么自定义数据集将受益于以原始或更高分辨率进行训练。在相同的分辨率下可获得最佳推理结果--img作为训练运行的地方,例如,如果您在以下位置进行训练--img 1280您还应该在...进行测试和detect--img 1280. - 批处理大小。 使用最大的

--batch-size您的硬件允许的。小批量大小会产生较差的 批量归一化 统计数据,应避免使用。您可以使用--batch-size -1自动选择适合您 GPU 的最佳批次大小。 - 学习率。 默认的学习率计划在大多数情况下都适用。为了更快地收敛,您可以尝试使用

--cos-lrflag 以启用余弦学习率调度,它在 epochs 上按照余弦曲线逐渐降低学习率。 - 数据增强。 YOLOv5 包括各种增强技术,如 mosaic,它结合了多个训练图像。对于最后几个 epoch,请考虑使用

--close-mosaic 10禁用 mosaic 数据增强,这有助于稳定训练。 - 超参数。 默认超参数位于 hyp.scratch-low.yaml。我们建议您先使用默认的超参数进行训练,然后再考虑修改任何参数。通常,增加增强超参数会减少并延迟过拟合,从而允许更长时间的训练和更高的最终mAP。 减少损失分量增益超参数,例如

hyp['obj']将有助于减少这些特定损失分量中的过拟合。有关优化这些超参数的自动化方法,请参阅我们的 超参数进化教程. - 混合精度训练。 启用混合精度训练,使用

--amp以加速训练并减少内存使用,同时不牺牲模型准确性。 - 多GPU训练。 如果您有多个 GPU,请使用

--device 0,1,2,3在它们之间分配训练,这可以显著减少训练时间。 - 提前停止。 使用

--patience 50如果验证指标在 50 个 epoch 内没有改善,则停止训练,从而节省时间并防止过度拟合。

高级优化技术

- 迁移学习. 对于专门的数据集,从预训练权重开始,并在训练过程中逐渐解冻层,以使模型适应您的特定任务。

- 模型剪枝. 训练后,考虑剪枝您的模型以删除冗余权重,并在不显著降低性能的情况下减小模型大小。

- 模型集成. 对于关键应用,训练具有不同配置的多个模型,并结合它们的预测以提高准确性。

- 测试时增强。 在推理期间启用 TTA,使用

--augment通过平均输入图像的增强版本的结果来提高预测准确性。

延伸阅读

如果您想了解更多信息,一个好的起点是 Karpathy 的“神经网络训练秘诀”,其中包含适用于所有 ML 领域的训练的绝妙想法:https://karpathy.github.io/2019/04/25/recipe/

有关训练设置和配置的更多详细信息,请参阅Ultralytics 训练设置文档,其中提供了所有可用参数的全面说明。

祝您好运 🍀 ,如果您有任何其他问题,请告诉我们!

常见问题

如何判断我的模型是否过拟合?

如果训练损失持续下降而验证损失开始增加,则您的模型可能存在过拟合。监控验证mAP——如果它在训练损失持续改善的同时趋于平稳或下降,则表明存在过拟合。解决方案包括增加更多训练数据、增强数据扩充或实施正则化技术。

训练 YOLOv5 的最佳批次大小是多少?

最佳批次大小取决于您的 GPU 内存。较大的批次大小通常提供更好的批次归一化统计信息和训练稳定性。使用您的硬件可以处理的最大批次大小,而不会耗尽内存。您可以使用 --batch-size -1 自动确定适合您设置的最佳批次大小。

如何加速 YOLOv5 训练?

要加速训练,请尝试:启用混合精度训练,使用 --amp,使用多个 GPU 与 --device 0,1,2,3,使用以下方式缓存您的数据集: --cache,并优化您的批次大小。如果对绝对精度要求不高,还可以考虑使用较小的模型变体,如 YOLOv5s。