사용자 정의 데이터로 YOLOv5 학습

📚 본 가이드에서는 YOLOv5 모델 🚀을 사용하여 자신만의 사용자 정의 데이터 세트를 훈련하는 방법을 설명합니다. 사용자 정의 모델을 훈련하는 것은 일반적인 객체 감지를 넘어 특정 실제 애플리케이션에 맞게 컴퓨터 비전 솔루션을 조정하는 데 있어 기본적인 단계입니다.

시작하기 전에

먼저 필요한 환경이 설정되었는지 확인하십시오. YOLOv5 저장소를 복제하고 다음 위치에서 필요한 종속성을 설치하십시오. requirements.txt입니다. A Python>=3.8.0 환경: PyTorch>=1.8 필수적입니다. 모델과 데이터 세트는 최신 YOLOv5에서 자동으로 다운로드됩니다. 릴리스 로컬에서 찾을 수 없는 경우.

git clone https://github.com/ultralytics/yolov5 # Clone the repository

cd yolov5

pip install -r requirements.txt # Install dependencies

맞춤형 데이터로 학습하기

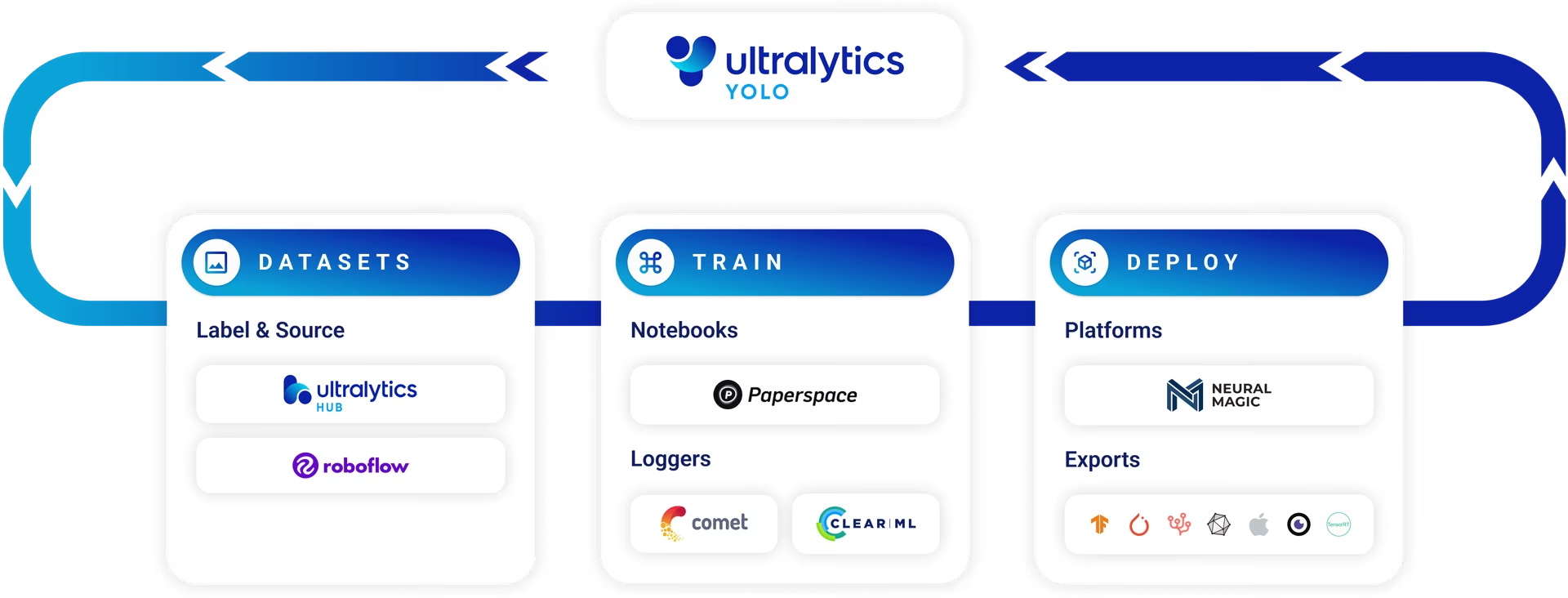

사용자 정의 객체 탐지 모델을 개발하는 것은 반복적인 과정입니다.

- Collect & Organize Images: 특정 작업과 관련된 이미지를 수집합니다. 고품질의 다양한 데이터가 중요합니다. 데이터 수집 및 어노테이션에 대한 가이드를 참조하세요.

- 객체 레이블 지정: 이미지 내에서 관심 있는 객체에 정확하게 어노테이션을 추가합니다.

- 모델 훈련: 레이블이 지정된 데이터를 사용하여 YOLOv5 모델을 훈련합니다. 사전 훈련된 가중치로 시작하여 전이 학습을 활용하세요.

- 배포 및 예측: 훈련된 모델을 사용하여 새로운 미지의 데이터에 대한 추론을 수행합니다.

- Collect Edge Cases: 모델 성능이 낮은 시나리오(edge cases)를 식별하고 유사한 데이터를 데이터 세트에 추가하여 견고성을 향상시킵니다. 이 주기를 반복합니다.

Ultralytics Platform은 데이터셋 관리, 모델 훈련 및 배포를 포함한 이 전체 머신러닝 운영(MLOps) 주기를 위한 간소화된 노코드 솔루션을 제공합니다.

라이선스

Ultralytics는 다양한 사용 시나리오를 수용하기 위해 두 가지 라이선스 옵션을 제공합니다.

- AGPL-3.0 라이선스: 이 OSI 승인 오픈 소스 라이선스는 개방형 협업과 지식 공유에 열정적인 학생, 연구원 및 매니아에게 이상적입니다. 파생 저작물은 동일한 라이선스로 공유해야 합니다. 자세한 내용은 LICENSE 파일을 참조하십시오.

- Enterprise License: 상업용 애플리케이션을 위해 설계된 이 라이선스는 AGPL-3.0의 오픈 소스 규정 없이 Ultralytics 소프트웨어 및 AI 모델을 상업용 제품 및 서비스에 원활하게 통합할 수 있도록 허용합니다. 프로젝트에 상업적 배포가 필요한 경우 Enterprise License를 요청하십시오.

Ultralytics 라이선스 페이지에서 라이선스 옵션에 대해 자세히 알아보세요.

학습을 시작하기 전에 데이터 세트 준비가 필수적입니다.

1. 데이터세트 생성

YOLOv5 모델은 객체 클래스의 시각적 특징을 학습하기 위해 레이블이 지정된 데이터가 필요합니다. 데이터 세트를 올바르게 구성하는 것이 중요합니다.

1.1 생성 dataset.yaml

데이터 세트 구성 파일 (예: coco128.yaml)은 데이터 세트의 구조, 클래스 이름 및 이미지 디렉토리 경로를 간략하게 설명합니다. COCO128 광범위한 데이터 세트에서 처음 128개의 이미지를 포함하는 작은 예제 데이터 세트 역할을 합니다. COCO 데이터세트. 학습 파이프라인을 빠르게 테스트하고 다음과 같은 잠재적인 문제를 진단하는 데 유용합니다. 과적합.

에 지정되어 있습니다. dataset.yaml 파일 구조는 다음을 포함합니다.

path: 데이터 세트가 포함된 루트 디렉터리입니다.train,val,test: 상대 경로는 다음을 기준으로 합니다.path이미지 또는 텍스트 파일이 포함된 디렉터리에 이미지 경로를 나열하여 훈련, 유효성 검사 및 테스트 세트를 설정하려면.names: 클래스 인덱스(0부터 시작)를 해당 클래스 이름에 매핑하는 딕셔리.

다음을 설정할 수 있습니다. path 를 절대 디렉터리(예 /home/user/datasets/coco128) 또는 다음과 같은 상대 경로입니다. ../datasets/coco128 를 사용하여 YOLOv5 리포지토리 루트에서 교육을 시작할 수 있습니다.

다음은 구조입니다. coco128.yaml (GitHub에서 보기):

# Dataset root directory relative to the yolov5 directory

path: coco128

# Train/val/test sets: specify directories, *.txt files, or lists

train: images/train2017 # 128 images for training

val: images/train2017 # 128 images for validation

test: # Optional path to test images

# Classes (example using 80 COCO classes)

names:

0: person

1: bicycle

2: car

# ... (remaining COCO classes)

77: teddy bear

78: hair drier

79: toothbrush

1.2 모델을 활용하여 자동 레이블링

도구를 사용한 수동 레이블링은 일반적인 접근 방식이지만, 이 프로세스는 시간이 많이 걸릴 수 있습니다. 기초 모델의 최근 발전은 주석 프로세스를 자동화하거나 반자동화할 수 있는 가능성을 제공하여 데이터 세트 생성을 크게 가속화할 수 있습니다. 다음은 레이블 생성에 도움이 될 수 있는 모델의 몇 가지 예입니다.

- Google Gemini: Gemini와 같은 대규모 멀티모달 모델은 강력한 이미지 이해 능력을 갖추고 있습니다. 이미지 내에서 객체를 식별하고 찾도록 프롬프트하여 YOLO 형식 레이블로 변환할 수 있는 경계 상자 또는 설명을 생성할 수 있습니다. 제공된 튜토리얼 노트북에서 잠재력을 살펴보세요.

- SAM2 (Segment Anything Model 2): SAM2와 같은 segmentation에 중점을 둔 Foundation 모델은 높은 정밀도로 객체를 식별하고 묘사할 수 있습니다. 주로 segmentation을 위한 것이지만 결과 마스크는 종종 객체 detection 작업에 적합한 바운딩 박스 어노테이션으로 변환될 수 있습니다.

- YOLOWorld: 이 모델은 개방형 어휘 감지 기능을 제공합니다. 관심 있는 객체의 텍스트 설명을 제공하면 YOLOWorld는 특정 클래스에 대한 사전 학습 없이 이미지에서 해당 객체를 찾을 수 있습니다. 이는 초기 레이블 생성을 위한 시작점으로 사용될 수 있으며, 이후 개선될 수 있습니다.

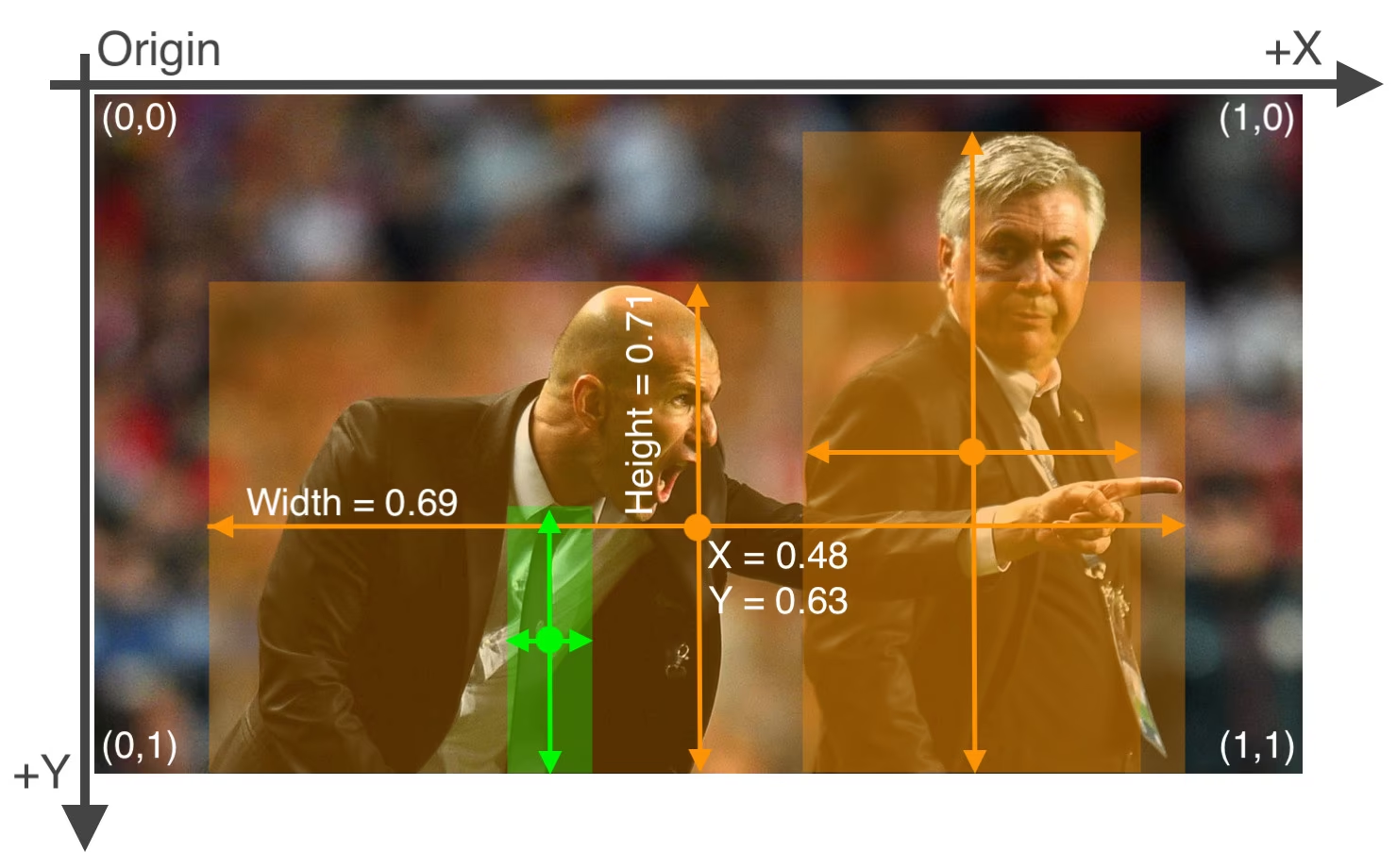

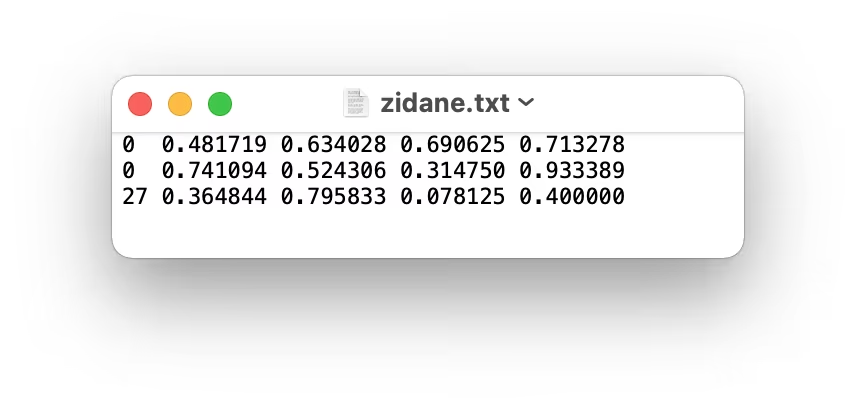

이러한 모델을 사용하면 "사전 레이블링" 단계를 제공하여 필요한 수동 노력을 줄일 수 있습니다. 그러나 자동으로 생성된 레이블의 정확성과 일관성을 보장하기 위해 검토하고 개선하는 것이 중요합니다. 품질이 훈련된 YOLOv5 모델의 성능에 직접적인 영향을 미치기 때문입니다. 레이블을 생성(및 잠재적으로 개선)한 후에는 레이블이 다음을 준수하는지 확인하십시오. YOLO 형식: 하나 *.txt 각 라인이 객체를 나타내는 이미지 당 파일 class_index x_center y_center width height (정규화된 좌표, 0부터 시작하는 클래스). 이미지에 관심 있는 객체가 없으면 해당 *.txt 파일이 필요합니다.

YOLO 형식 *.txt 파일 사양은 정확해야 합니다.

- 객체 바운딩 박스 당 한 행입니다.

- 각 행은 다음을 포함해야 합니다:

class_index x_center y_center width height. - 좌표는 다음 형식이어야 합니다. 정규화됨 0과 1 사이의 범위로 만듭니다. 이를 위해 다음의 픽셀 값을 나눕니다.

x_center및width이미지의 총 너비로 나누고,y_center및height이미지의 총 높이로 나눕니다. - 클래스 인덱스는 0부터 시작합니다(예: 첫 번째 클래스는 다음으로 표시됨).

0이며, 두 번째는1, 등등)을 의미합니다.

위 이미지에 해당하는 레이블 파일로, 두 개의 '사람' 객체(클래스 인덱스 0)와 하나의 'tie' 객체 (클래스 인덱스 27), 다음과 같습니다:

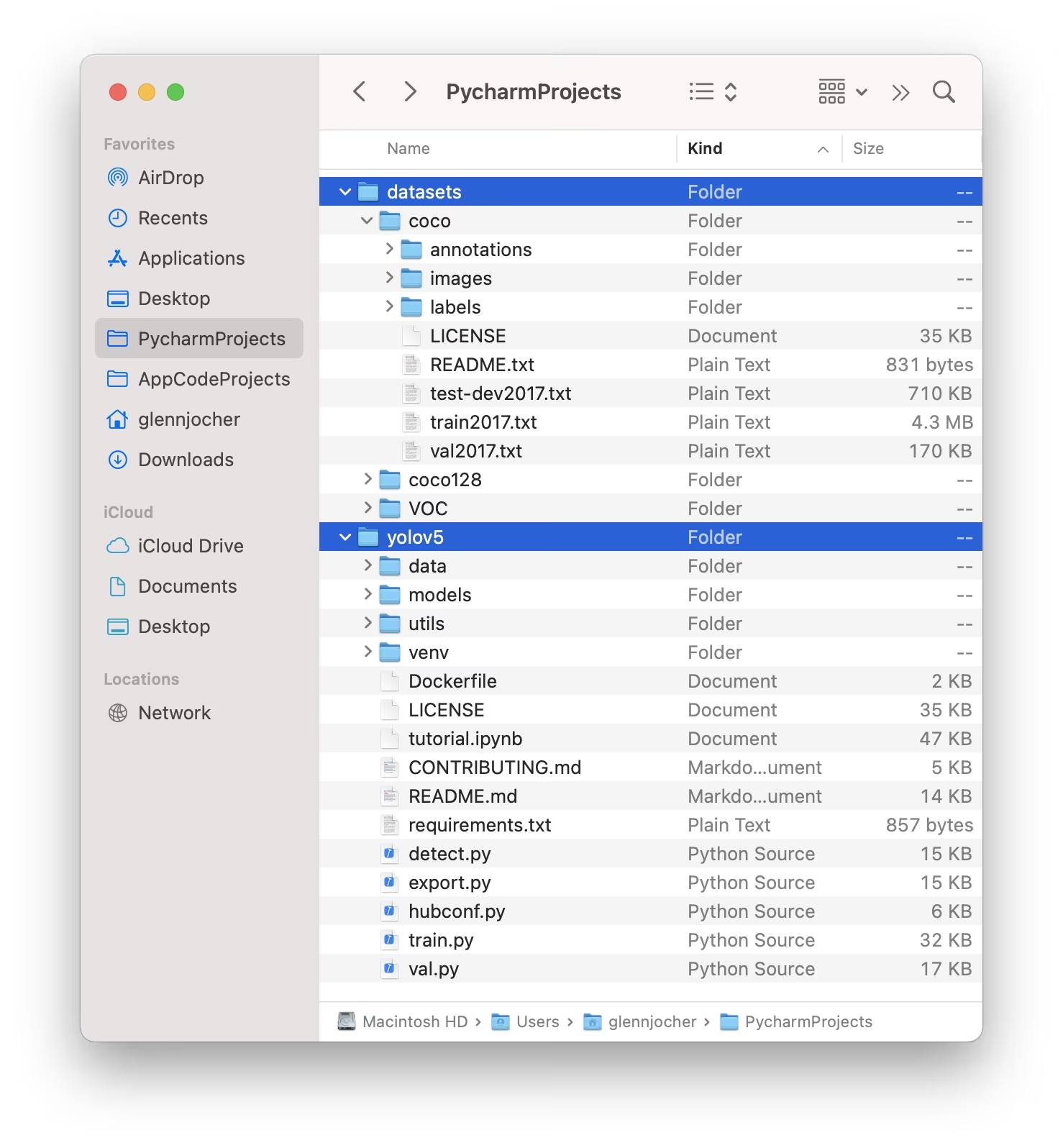

1.3 디렉토리 구성

구조화하세요 데이터 세트 아래 그림과 같이 디렉토리. 기본적으로 YOLOv5는 데이터 세트 디렉토리 (예: /coco128) 내에 있어야 합니다. /datasets 폴더에 위치 인접한 해당 /yolov5 저장소 디렉터리입니다.

YOLOv5는 각 이미지에 대한 레이블의 마지막 인스턴스를 대체하여 자동으로 찾습니다. /images/ 이미지 경로에서 /labels/. 예를 들어:

../datasets/coco128/images/im0.jpg # Path to the image file

../datasets/coco128/labels/im0.txt # Path to the corresponding label file

권장되는 디렉토리 구조는 다음과 같습니다.

/datasets/

└── coco128/ # Dataset root

├── images/

│ ├── train2017/ # Training images

│ │ ├── 000000000009.jpg

│ │ └── ...

│ └── val2017/ # Validation images (optional if using same set for train/val)

│ └── ...

└── labels/

├── train2017/ # Training labels

│ ├── 000000000009.txt

│ └── ...

└── val2017/ # Validation labels (optional if using same set for train/val)

└── ...

2. 모델 선택

학습 프로세스를 시작하려면 사전 학습된 모델을 선택하십시오. 사전 학습된 가중치로 시작하면 처음부터 학습하는 것보다 학습 속도가 크게 향상되고 성능이 향상됩니다. YOLOv5는 속도와 정확성의 균형을 다르게 맞춘 다양한 모델 크기를 제공합니다. 예를 들어 YOLOv5s는 리소스가 제한된 환경에 적합한 두 번째로 작고 가장 빠른 모델입니다. 사용 가능한 모든 모델에 대한 자세한 비교는 README 표를 참조하십시오.

3. 학습

다음을 시작합니다. 모델 학습 다음을 사용하여 train.py 스크립트. 필수 인수는 다음과 같습니다.

--img: 입력을 정의합니다. 이미지 크기 (예:--img 640). 일반적으로 크기가 클수록 정확도가 향상되지만 더 많은 GPU 메모리가 필요합니다.--batch: 다음을 결정합니다. 배치 크기 (예:--batch 16). GPU가 처리할 수 있는 가장 큰 크기를 선택하십시오.--epochs: 총 훈련 횟수를 지정합니다. epochs (예:--epochs 100). 하나의 epoch는 전체 훈련 데이터 세트를 한 번 통과하는 것을 나타냅니다.--data: 다음의 경로:dataset.yaml파일 (예:--data coco128.yaml)입니다.--weights: 초기 가중치 파일의 경로입니다. 사전 훈련된 가중치(예:--weights yolov5s.pt)는 더 빠른 수렴과 우수한 결과를 위해 적극 권장됩니다. 처음부터 학습하려면 (매우 큰 데이터 세트와 특정 요구 사항이 있는 경우가 아니면 권장하지 않음) 다음을 사용하십시오.--weights '' --cfg yolov5s.yaml.

사전 훈련된 가중치는 로컬에서 찾을 수 없는 경우 최신 YOLOv5 릴리스에서 자동으로 다운로드됩니다.

# Example: Train YOLOv5s on the COCO128 dataset for 3 epochs

python train.py --img 640 --batch 16 --epochs 3 --data coco128.yaml --weights yolov5s.pt

학습 속도 최적화

💡 사용 --cache ram 또는 --cache disk 데이터 세트 이미지를 다음 위치에 캐시하려면 RAM 또는 로컬 디스크에 있습니다. 이는 특히 데이터 세트 I/O(입력/출력) 작업이 병목 현상일 때 훈련 속도를 크게 향상시킵니다. 상당한 RAM 또는 디스크 공간이 필요합니다.

로컬 데이터 저장소

💡 항상 로컬에 저장된 데이터 세트를 사용하여 훈련하십시오. 네트워크 드라이브(예: Google Drive) 또는 원격 저장소에서 데이터에 액세스하면 속도가 현저히 느려지고 훈련 성능이 저하될 수 있습니다. 데이터 세트를 로컬 SSD에 복사하는 것이 가장 좋은 방법인 경우가 많습니다.

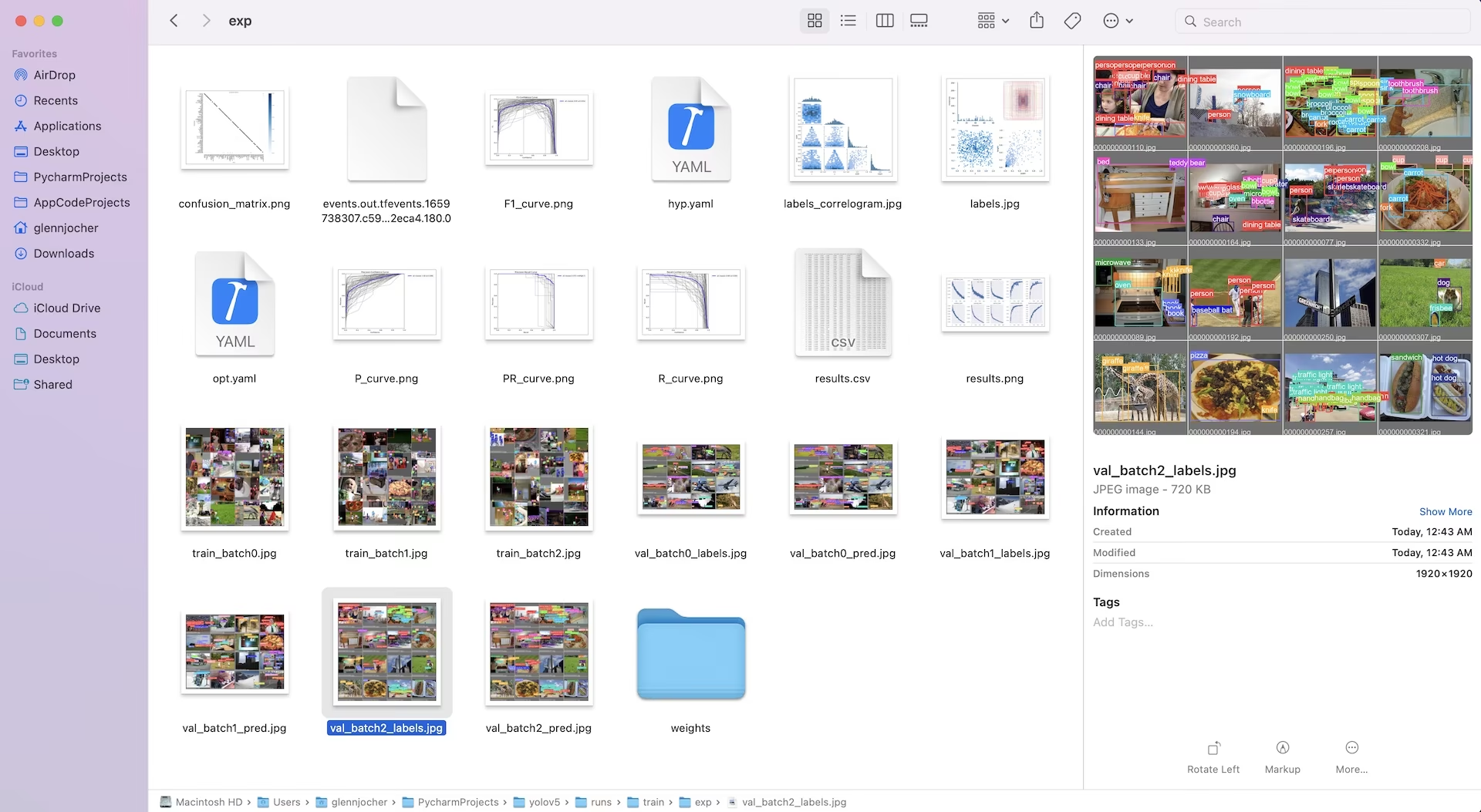

가중치 및 로그를 포함한 모든 학습 결과는 다음 위치에 저장됩니다. runs/train/ 디렉토리입니다. 각 훈련 세션은 새로운 하위 디렉토리를 생성합니다(예: runs/train/exp, runs/train/exp2, 등)입니다. 직접 체험해 보려면 공식 튜토리얼 노트북의 학습 섹션을 살펴보십시오.

4. 시각화

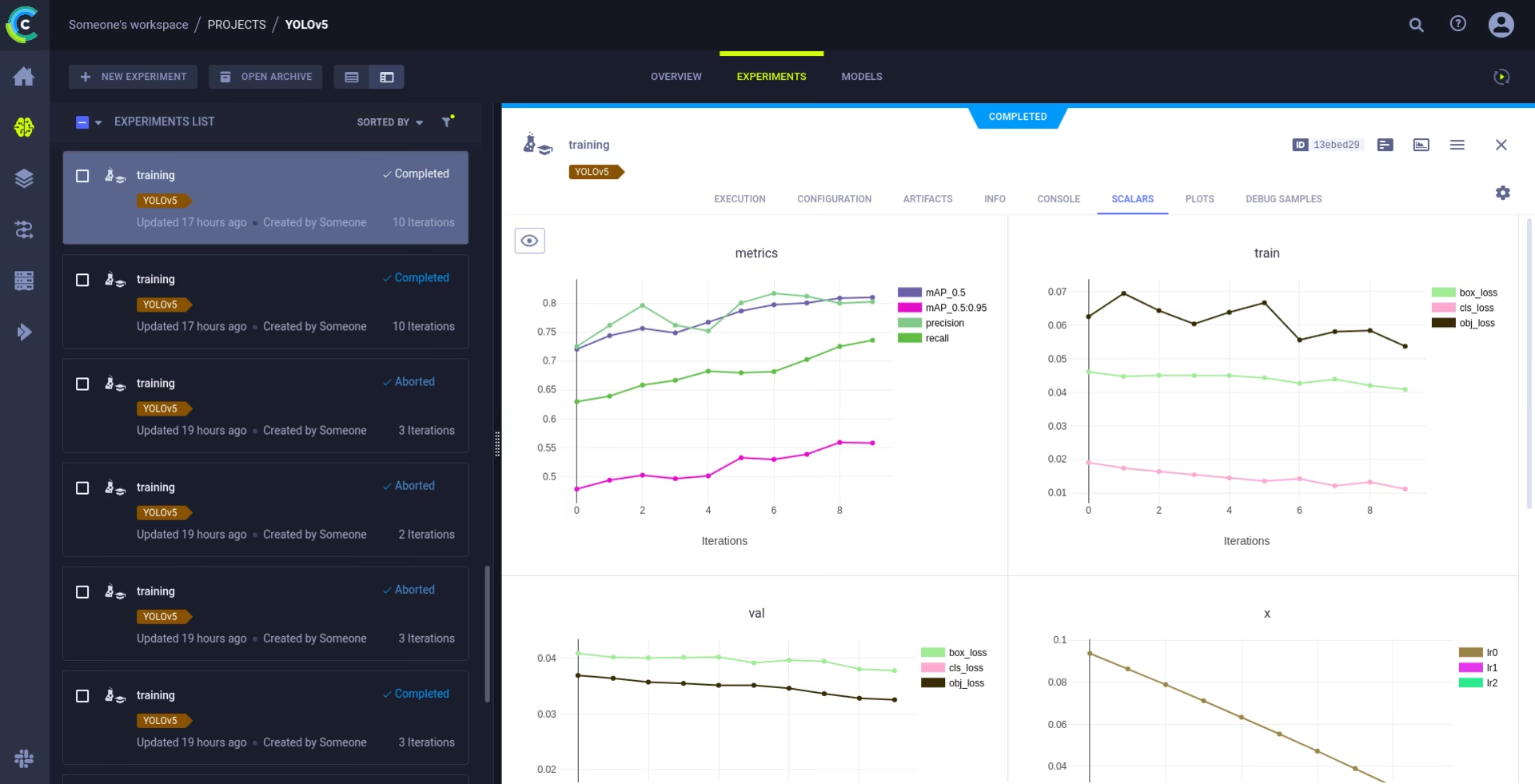

YOLOv5는 다양한 도구와 원활하게 통합되어 학습 진행 상황을 시각화하고, 결과를 평가하고, 실시간으로 성능을 모니터링할 수 있습니다.

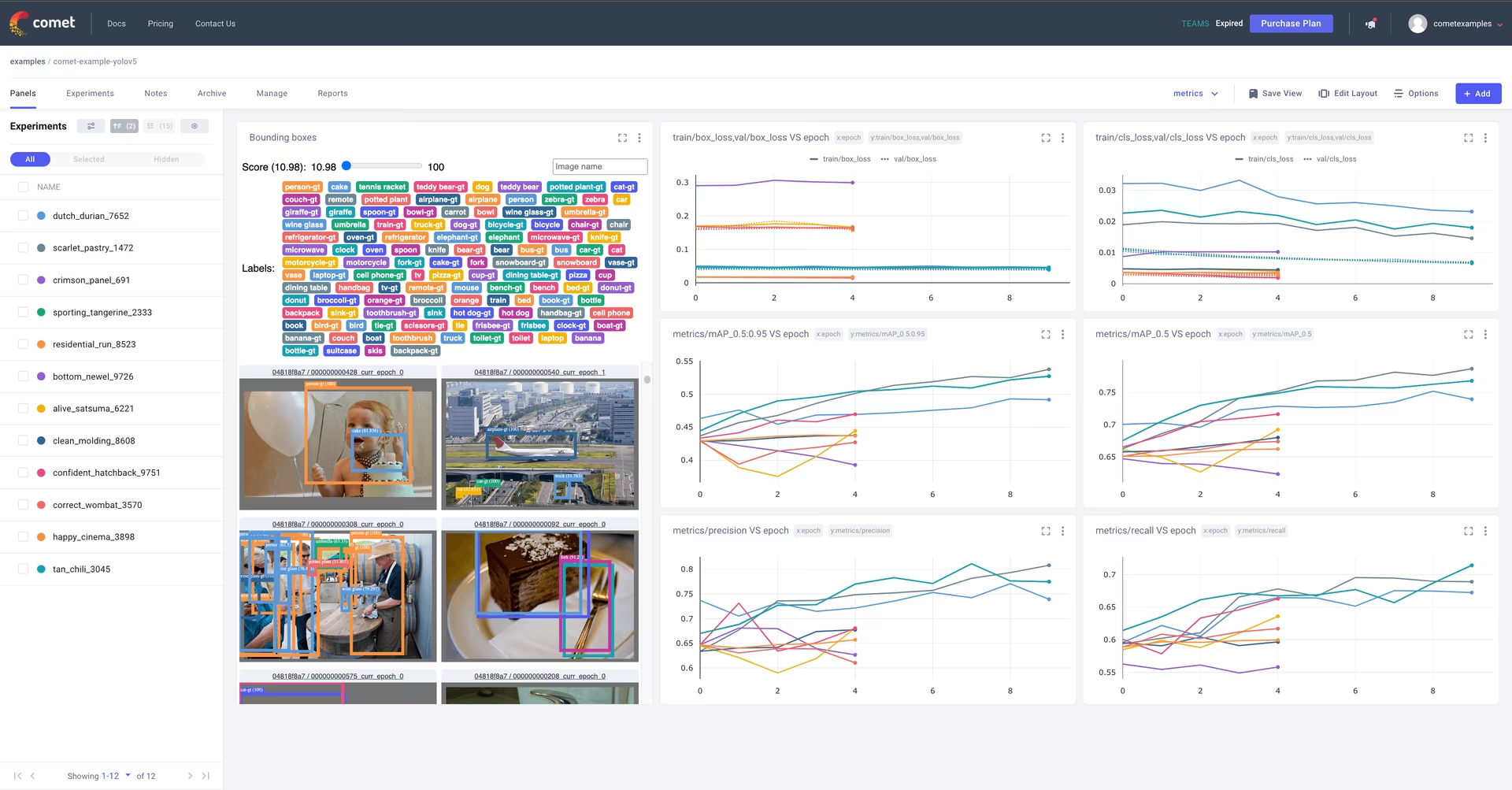

Comet 로깅 및 시각화 🌟 신규

Comet은 포괄적인 실험 추적을 위해 완벽하게 통합되었습니다. 실시간으로 메트릭을 시각화하고, 하이퍼파라미터를 저장하고, 데이터 세트 및 모델 체크포인트를 관리하고, 대화형 Comet Custom Panels를 사용하여 모델 예측을 분석합니다.

시작하기는 간단합니다:

pip install comet_ml # 1. Install Comet library

export COMET_API_KEY=YOUR_API_KEY_HERE # 2. Set your Comet API key (create a free account at Comet.ml)

python train.py --img 640 --epochs 3 --data coco128.yaml --weights yolov5s.pt # 3. Train your model - Comet automatically logs everything!

지원되는 기능에 대해 자세히 알아보려면 다음을 참조하세요. Comet 통합 가이드입니다. Comet의 기능에 대한 자세한 내용은 공식 문서실시간 데모를 보려면 Comet Colab Notebook을 사용해 보세요.

ClearML 로깅 및 자동화 🌟 신규

ClearML 통합을 통해 자세한 실험 추적, 데이터세트 버전 관리, 심지어 원격으로 학습 실행까지 가능합니다. 다음의 간단한 단계를 통해 ClearML을 활성화하십시오.

- 패키지 설치:

pip install clearml - ClearML 초기화: 실행

clearml-initClearML 서버(자체 호스팅 또는 무료 티어)입니다.

ClearML은 실험 세부 정보, 모델 업로드, 비교, 커밋되지 않은 코드 변경 사항 및 설치된 패키지를 자동으로 캡처하여 완전한 재현성을 보장합니다. ClearML Data를 사용하여 원격 에이전트에서 학습 작업을 쉽게 예약하고 데이터 세트 버전을 관리할 수 있습니다. 자세한 내용은 ClearML 통합 가이드를 참조하십시오.

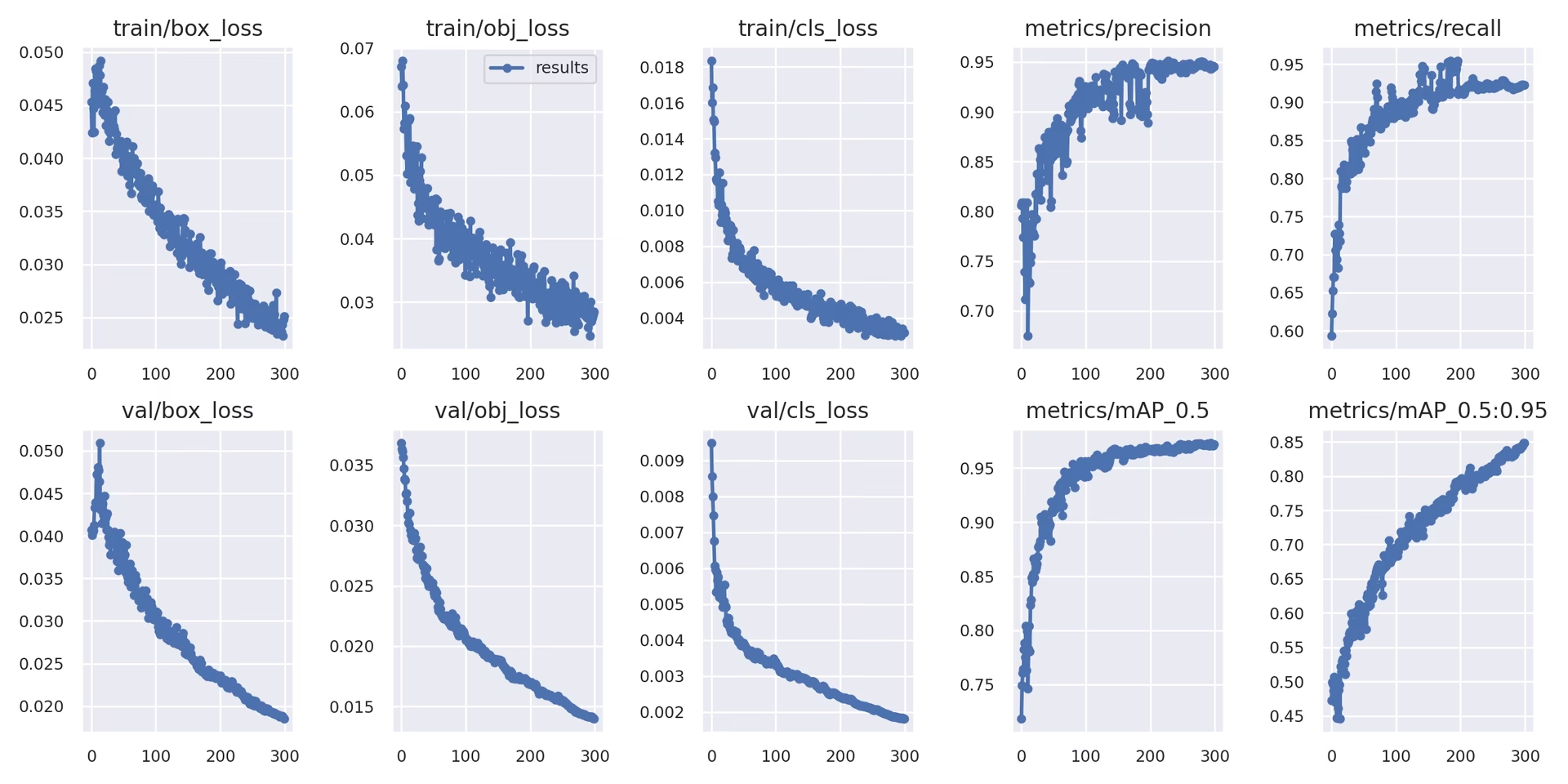

로컬 로깅

학습 결과는 자동으로 기록됩니다. TensorBoard 다음에 저장됩니다. CSV 특정 실험 디렉터리 내의 파일(예:) runs/train/exp). 기록된 데이터는 다음과 같습니다:

- 학습 및 검증 손실과 성능 지표.

- 적용된 증강(모자이크와 같은)을 보여주는 sample_images.

- 시각적 검사를 위한 모델 예측과 함께 제공되는 Ground Truth 레이블입니다.

- 정밀도-재현율 (PR) 곡선과 같은 주요 평가 지표.

- 자세한 클래스별 성능 분석을 위한 오차 행렬입니다.

에 지정되어 있습니다. results.csv 파일은 모든 epoch 이후에 업데이트되며 다음과 같이 표시됩니다. results.png 학습이 완료되면 한 번 실행합니다. 또한 다음을 플롯할 수도 있습니다. results.csv 제공된 유틸리티 함수를 사용하여 파일을 수동으로 작성하십시오.

from utils.plots import plot_results

# Plot results from a specific training run directory

plot_results("runs/train/exp/results.csv") # This will generate 'results.png' in the same directory

5. 다음 단계

훈련이 성공적으로 완료되면 가장 성능이 좋은 모델 체크포인트(best.pt)이 저장되어 배포 또는 추가 개선을 위해 준비되었습니다. 잠재적인 다음 단계는 다음과 같습니다.

- 학습된 모델을 사용하여 새로운 이미지 또는 비디오에 대한 추론을 CLI 또는 Python을 통해 실행합니다.

- 모델의 정확도 및 다양한 데이터 분할(예: 홀드아웃 테스트 세트)에 대한 일반화 기능을 평가하기 위해 유효성 검사를 수행합니다.

- ONNX, TensorFlow SavedModel 또는 TensorRT와 같은 다양한 배포 형식으로 모델을 내보내기하여 다양한 플랫폼에서 최적화된 추론을 수행합니다.

- 하이퍼파라미터 튜닝 기술을 사용하여 잠재적으로 추가적인 성능 향상을 얻으십시오.

- 최상의 훈련 결과를 위한 팁을 따라 모델을 계속 개선하고 성능 분석을 기반으로 더 다양하고 어려운 데이터를 반복적으로 추가하십시오.

지원되는 환경

Ultralytics는 CUDA, cuDNN, Python 및 PyTorch와 같은 필수 종속성이 장착된 즉시 사용 가능한 환경을 제공하여 원활한 시작을 지원합니다.

- 무료 GPU 노트북:

- 클라우드 플랫폼:

- Google Cloud: GCP 빠른 시작 가이드

- Amazon AWS: AWS 퀵스타트 가이드

- Microsoft Azure: AzureML 빠른 시작 가이드

- 로컬 설정:

- Docker: Docker 빠른 시작 가이드

- Docker: Docker 빠른 시작 가이드

프로젝트 상태

이 배지는 모든 YOLOv5 GitHub 동작 지속적통합(CI) 테스트를 성공적으로 통과했음을 나타냅니다. 이러한 엄격한 CI 테스트는 macOS, Windows 및 Ubuntu 운영 체제 전반에서 교육, 검증, 추론, 내보내기 및 벤치마크를 포함한 핵심 기능을 다룹니다. 테스트는 24시간마다 그리고 각 코드 커밋 시 자동으로 실행되어 일관된 안정성과 최적의 성능을 보장합니다.

FAQ

사용자 정의 데이터 세트에서 YOLOv5를 훈련하려면 어떻게 해야 하나요?

사용자 정의 데이터 세트에서 YOLOv5를 훈련하려면 몇 가지 주요 단계가 필요합니다.

- 데이터 세트 준비: 이미지를 수집하고 주석을 답니다. 주석이 필요한 형식인지 확인합니다. YOLO 형식이미지와 레이블을 다음과 같이 구성합니다.

train/및val/(선택적으로test/) 디렉토리를 고려하십시오. 다음과 같은 모델을 사용하는 것을 고려해보세요. Google Gemini, SAM2또는 YOLOWorld 레이블링 프로세스를 지원하거나 자동화하려면 (섹션 1.2 참조). - 환경 설정: YOLOv5 저장소를 복제하고 다음을 사용하여 종속성을 설치합니다.

pip install -r requirements.txt.git clone https://github.com/ultralytics/yolov5 cd yolov5 pip install -r requirements.txt - 데이터 세트 구성 생성: 데이터세트 경로, 클래스 수 및 클래스 이름을 다음 위치에 정의합니다.

dataset.yaml파일. - 학습 시작: python에서

train.py스크립트, 경로 제공dataset.yaml, 원하는 사전 훈련된 가중치(예:yolov5s.pt), 이미지 크기, 배치 크기 및 epoch 수를 지정합니다.python train.py --img 640 --batch 16 --epochs 100 --data path/to/your/dataset.yaml --weights yolov5s.pt

YOLO 모델 훈련을 위해 Ultralytics Platform을 사용해야 하는 이유는 무엇인가요?

Ultralytics Platform은 종종 코드를 작성할 필요 없이 전체 YOLO 모델 개발 수명 주기를 간소화하도록 설계된 포괄적인 플랫폼입니다. 주요 이점은 다음과 같습니다:

- 단순화된 학습: 미리 구성된 환경과 직관적인 사용자 인터페이스를 사용하여 모델을 쉽게 학습할 수 있습니다.

- 통합 데이터 관리: 플랫폼 내에서 데이터 세트를 효율적으로 업로드, 버전 관리 및 관리합니다.

- 실시간 모니터링: Comet 또는 TensorBoard와 같은 통합 도구를 사용하여 훈련 진행 상황을 추적하고 성능 지표를 시각화합니다.

- Collaboration Features: 공유 리소스, 프로젝트 관리 도구 및 간편한 모델 공유를 통해 팀워크를 촉진합니다.

- No-Code 배포: 학습된 모델을 다양한 대상에 직접 배포합니다.

실용적인 안내를 위해 저희 블로그 게시물인 Ultralytics Platform으로 사용자 지정 모델을 훈련하는 방법을 확인해 보세요.

어떻게 어노테이션된 데이터를 YOLOv5 형식으로 변환하나요?

수동으로 주석을 달든 자동화된 도구(섹션 1.2에 언급된 도구와 같은)를 사용하든 최종 레이블은 YOLOv5에서 요구하는 특정 YOLO 형식이어야 합니다.

- 하나 만들기

.txt각 이미지에 대한 파일. 파일 이름은 이미지 파일 이름과 일치해야 합니다(예:image1.jpg다음과 같습니다.image1.txt). 이러한 파일을 다음 위치에 넣습니다.labels/디렉토리는 다음 위치와 평행합니다.images/디렉토리 (예:../datasets/mydataset/labels/train/)입니다. - 각 라인은 다음을 포함해야 합니다.

.txt파일은 하나의 객체 어노테이션을 나타내며 다음 형식을 따릅니다.class_index center_x center_y width height. - 좌표 (

center_x,center_y,width,height)이어야 합니다. 정규화됨 (0.0과 1.0 사이의 값)이며 이미지 크기에 상대적입니다. - 클래스 인덱스는 0부터 시작 (첫 번째 클래스는

0이며, 두 번째는1, 등)입니다.

많은 수동 어노테이션 도구가 YOLO 형식으로 직접 내보내기를 제공합니다. 자동화된 모델을 사용하는 경우 해당 출력(예: 경계 상자 좌표, 분할 마스크)을 이 특정 정규화된 텍스트 형식으로 변환하는 스크립트 또는 프로세스가 필요합니다. 최종 데이터 세트 구조가 가이드에 제공된 예제를 준수하는지 확인하십시오. 자세한 내용은 데이터 수집 및 어노테이션 가이드를 참조하십시오.

상업적 애플리케이션에서 YOLOv5를 사용할 때 라이선스 옵션은 무엇인가요?

Ultralytics는 다양한 요구 사항에 맞는 유연한 라이선스를 제공합니다.

- AGPL-3.0 라이선스: 이 오픈 소스 라이선스는 학술 연구, 개인 프로젝트 및 오픈 소스 규정 준수가 허용되는 상황에 적합합니다. 수정 사항 및 파생 저작물도 AGPL-3.0에 따라 오픈 소스로 제공되어야 합니다. AGPL-3.0 라이선스 세부 정보를 검토하십시오.

- Enterprise License: YOLOv5를 독점 제품 또는 서비스에 통합하는 기업을 위해 설계된 상업용 라이선스입니다. 이 라이선스는 AGPL-3.0의 오픈 소스 의무를 제거하여 클로즈드 소스 배포를 허용합니다. 자세한 내용이나 Enterprise License를 요청하려면 라이선스 페이지를 방문하십시오.

프로젝트 요구 사항 및 배포 모델에 가장 적합한 라이선스를 선택하세요.