COCO 데이터셋

The COCO (Common Objects in Context) 데이터셋은 대규모 객체 detect, segment 및 캡셔닝 데이터셋입니다. 이 데이터셋은 다양한 객체 카테고리에 대한 연구를 장려하기 위해 설계되었으며, 컴퓨터 비전 모델 벤치마킹에 일반적으로 사용됩니다. 객체 detect, segment 및 자세 추정 작업을 수행하는 연구원과 개발자에게 필수적인 데이터셋입니다.

참고: Ultralytics COCO 데이터셋 개요

COCO 사전 학습 모델

| 모델 | 크기 (픽셀) | mAPval 50-95 | mAPval 50-95(e2e) | 속도 CPU ONNX (ms) | 속도 T4 TensorRT10 (ms) | 파라미터 (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

주요 기능

- COCO는 33만 개의 이미지를 포함하며, 이 중 20만 개의 이미지에는 객체 detect, segment 및 캡셔닝 작업을 위한 주석이 있습니다.

- 이 데이터 세트는 자동차, 자전거, 동물과 같은 일반적인 객체는 물론 우산, 핸드백, 스포츠 장비와 같은 더 구체적인 범주를 포함하여 80개의 객체 범주로 구성됩니다.

- 주석에는 각 이미지에 대한 객체 경계 상자, 분할 마스크 및 캡션이 포함됩니다.

- COCO는 객체 detect를 위한 평균 정밀도 (mAP)와 segment 작업을 위한 평균 재현율 (mAR)과 같은 표준화된 평가 지표를 제공하여 모델 성능 비교에 적합합니다.

데이터 세트 구조

COCO 데이터셋은 세 가지 하위 집합으로 나뉩니다:

- Train2017: 이 하위 세트에는 객체 탐지, 분할 및 캡셔닝 모델을 훈련하기 위한 118K개의 이미지가 포함되어 있습니다.

- Val2017: 이 하위 세트에는 모델 훈련 중 유효성 검사 목적으로 사용되는 5K개의 이미지가 있습니다.

- Test2017: 이 하위 집합은 학습된 모델을 테스트하고 벤치마킹하는 데 사용되는 2만 개의 이미지로 구성됩니다. 이 하위 집합에 대한 실제 주석은 공개적으로 제공되지 않으며, 성능 평가를 위해 결과는 COCO 평가 서버에 제출됩니다.

응용 분야

COCO 데이터셋은 객체 detect (예: Ultralytics YOLO, Faster R-CNN, SSD), 인스턴스 segment (예: Mask R-CNN), 키포인트 detect (예: OpenPose)와 같은 딥러닝 모델 학습 및 평가에 널리 사용됩니다. 이 데이터셋의 다양한 객체 카테고리, 많은 수의 주석이 달린 이미지, 그리고 표준화된 평가 지표는 컴퓨터 비전 연구원과 실무자에게 필수적인 자원입니다.

데이터세트 YAML

데이터셋 구성을 정의하는 데 YAML (Yet Another Markup Language) 파일이 사용됩니다. 이 파일에는 데이터셋의 경로, 클래스 및 기타 관련 정보가 포함됩니다. COCO 데이터셋의 경우, coco.yaml 파일은 다음 위치에서 관리됩니다. https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco.yaml.

ultralytics/cfg/datasets/coco.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # val images (relative to 'path') 5000 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

segments = True # segment or box labels

dir = Path(yaml["path"]) # dataset root dir

urls = [ASSETS_URL + ("/coco2017labels-segments.zip" if segments else "/coco2017labels.zip")] # labels

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

사용법

이미지 크기 640으로 COCO 데이터셋에서 YOLO26n 모델을 100 에포크 동안 훈련하려면 다음 코드 스니펫을 사용할 수 있습니다. 사용 가능한 인자의 포괄적인 목록은 모델 훈련 페이지를 참조하십시오.

훈련 예제

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

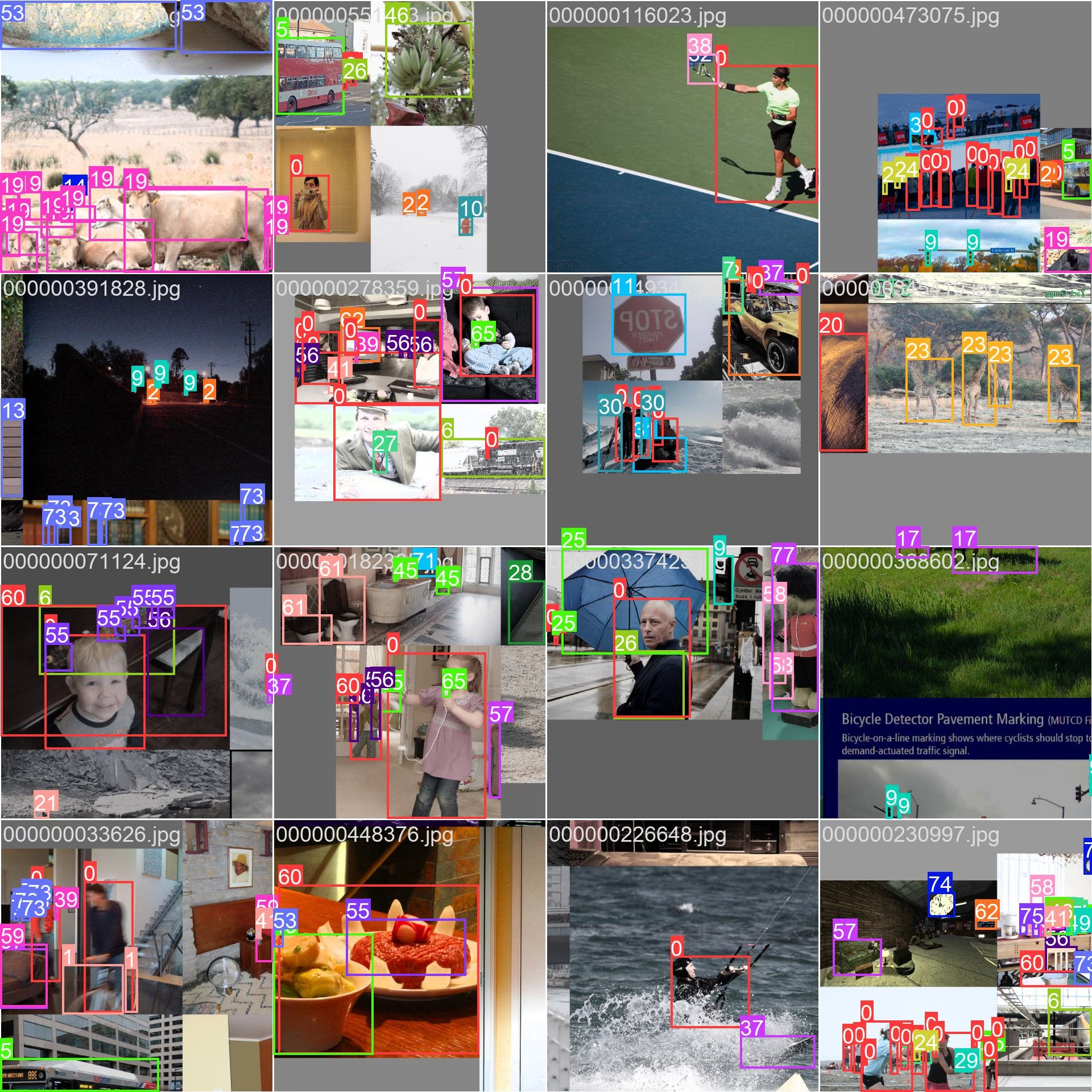

샘플 이미지 및 주석

COCO 데이터셋은 다양한 객체 카테고리와 복잡한 장면을 포함하는 다채로운 이미지 세트를 포함합니다. 다음은 데이터셋의 이미지 예시와 해당 주석입니다:

- 모자이크 이미지: 이 이미지는 모자이크 데이터 세트 이미지로 구성된 훈련 배치를 보여줍니다. 모자이킹은 각 훈련 배치 내에서 객체와 장면의 다양성을 높이기 위해 여러 이미지를 단일 이미지로 결합하는 훈련 중 사용되는 기술입니다. 이는 모델이 다양한 객체 크기, 종횡비 및 컨텍스트로 일반화하는 능력을 향상시키는 데 도움이 됩니다.

이 예시는 COCO 데이터셋 이미지의 다양성과 복잡성을 보여주며, 학습 과정에서 모자이킹 사용의 이점을 보여줍니다.

인용 및 감사의 말씀

연구 또는 개발 작업에서 COCO 데이터셋을 사용하는 경우, 다음 논문을 인용해 주십시오.

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

컴퓨터 비전 커뮤니티를 위한 이 귀중한 자원을 만들고 유지 관리해 준 COCO 컨소시엄에 감사드립니다. COCO 데이터셋 및 제작자에 대한 자세한 내용은 COCO 데이터셋 웹사이트를 방문하십시오.

FAQ

COCO 데이터셋이란 무엇이며, 컴퓨터 비전에 왜 중요한가요?

COCO 데이터셋 (Common Objects in Context)은 객체 detect, segment 및 캡셔닝에 사용되는 대규모 데이터셋입니다. 이 데이터셋은 80가지 객체 카테고리에 대한 상세한 주석이 포함된 33만 개의 이미지를 포함하고 있어 컴퓨터 비전 모델 벤치마킹 및 학습에 필수적입니다. 연구원들은 다양한 카테고리와 평균 정밀도 (mAP)와 같은 표준화된 평가 지표 때문에 COCO를 사용합니다.

COCO 데이터셋을 사용하여 YOLO 모델을 어떻게 학습시킬 수 있나요?

COCO 데이터셋을 사용하여 YOLO26 모델을 훈련하려면 다음 코드 스니펫을 사용할 수 있습니다:

훈련 예제

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

사용 가능한 인수에 대한 자세한 내용은 Training 페이지를 참조하십시오.

COCO 데이터셋의 주요 특징은 무엇인가요?

COCO 데이터셋에는 다음이 포함됩니다:

- 330K 이미지, 객체 감지, 분할 및 캡션용으로 주석이 달린 200K.

- 자동차 및 동물과 같은 일반적인 항목부터 핸드백 및 스포츠 장비와 같은 특정 항목에 이르기까지 80개의 객체 범주가 있습니다.

- 객체 detect (mAP) 및 segment (평균 재현율, mAR)를 위한 표준화된 평가 지표.

- 다양한 객체 크기 및 컨텍스트에서 모델 일반화를 향상시키기 위해 학습 배치에서 모자이킹 기술을 사용합니다.

COCO 데이터셋으로 훈련된 사전 훈련된 YOLO26 모델은 어디에서 찾을 수 있습니까?

COCO 데이터셋으로 사전 훈련된 YOLO26 모델은 문서에 제공된 링크에서 다운로드할 수 있습니다. 예시는 다음과 같습니다:

이 모델들은 크기, mAP, 추론 속도 면에서 다양하며, 다양한 성능 및 리소스 요구 사항에 대한 옵션을 제공합니다.

COCO 데이터셋은 어떻게 구성되어 있으며 어떻게 사용하나요?

COCO 데이터셋은 세 가지 하위 집합으로 나뉩니다:

- Train2017: 학습용 118K 이미지.

- Val2017: 학습 중 검증을 위한 5K 이미지.

- Test2017: 학습된 모델 벤치마킹을 위한 2만 개의 이미지. 성능 평가를 위해 결과는 COCO 평가 서버에 제출되어야 합니다.

데이터셋의 YAML 구성 파일은 coco.yaml에서 확인할 수 있으며, 여기에는 경로, 클래스 및 데이터셋 세부 정보가 정의되어 있습니다.